Multisearch di Google: la multimodalità è il futuro delle interfacce uomo-macchina

Google ha recentemente introdotto Multisearch: una nuova modalità di ricerca che comprende una componente visuale (attraverso Lens) e una componente testuale o vocale. Quali scenari si apriranno? Cosa comporterà questo in ambito SEO?

Google, attraverso Lens, ci ha già fatto conoscere le potenzialità della ricerca visuale. Mi è capitato, ad esempio di non conoscere il modello di un paio di scarpe da running che mi interessavano.. è bastato inquadrarle con Lens per ottenere non solo l'informazione sul modello in qualche secondo, ma anche le promozioni, le recensioni, i negozi dove poterle acquistare, e molto altro.

Recentemente , però, è stata introdotta una modalità di ricerca completamente nuova, definita "multisearch", la quale, partendo dall'immagine inquadrata su Lens, combina la ricerca visuale e quella testuale o vocale.

Attraverso multisearch puoi andare oltre il campo di ricerca e porre domande su ciò che vedi.

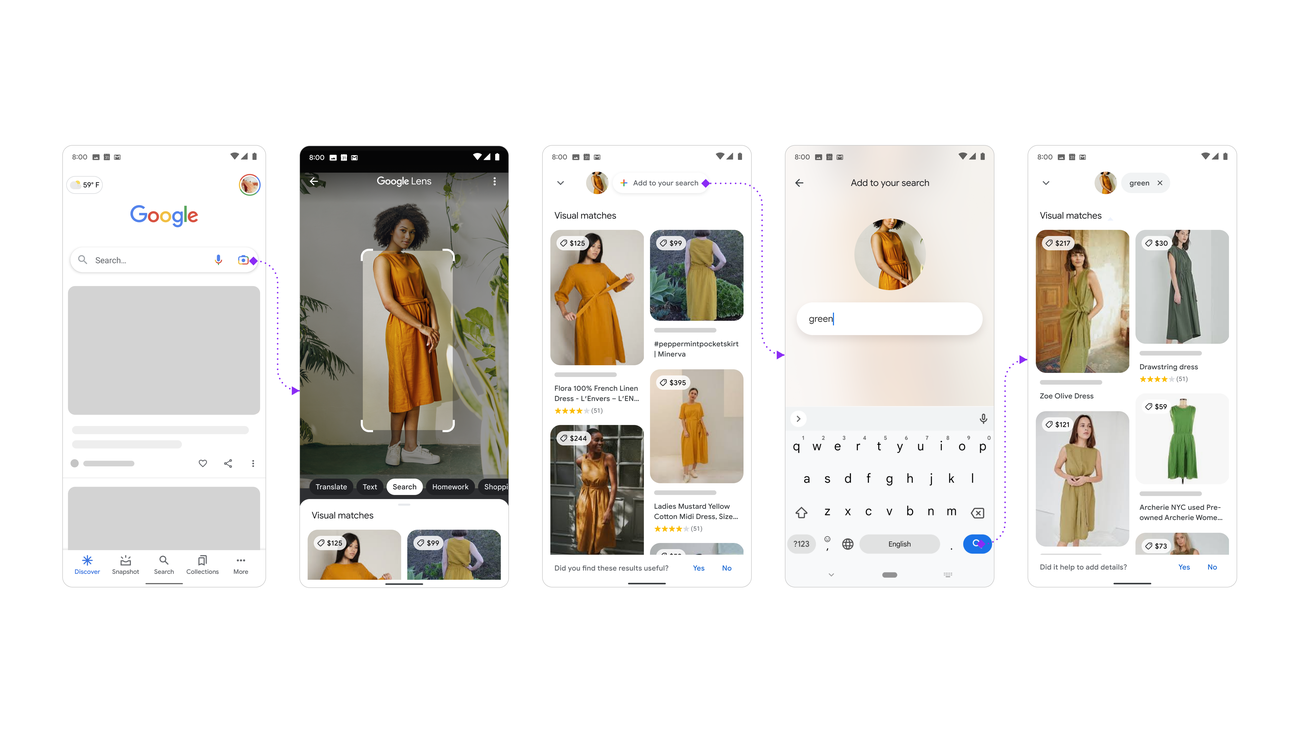

L'immagine che segue mostra un esempio pratico di ricerca svolto attraverso questa nuova modalità. In semplici step, è facilissimo comprenderne il funzionamento.

- Sfruttando Google Lens un utente inquadrato un vestito;

- successivamente l'interfaccia permette di aggiungere una domanda testuale (query di ricerca) in riferimento a quel contesto;

- l'utente aggiunge un colore;

- ottiene, come risultati, vestiti uguali o simili a quello inquadrato del colore specificato.

Sarebbe stato possibile ottenere lo stesso risultato attraverso una normale ricerca o una ricerca visuale? Direi di no.

Altri esempi di utilità della combinazione tra due modalità possono essere i seguenti:

- possiamo fotografare un ambiente, ad esempio un salotto, e aggiungere "tavolino da caffè" per ottenere un tavolo nello stesso stile che si abbina in maniera perfetta;

- possiamo fotografare una pianta che non conosciamo ed aggiungere "come si coltiva", per ottenere i dettagli sulla tipologia di pianta ed istruzioni dettagliate sulla coltivazione.

Tutto questo è reso possibile dall'evoluzione degli algoritmi di intelligenza artificiale, che stanno rendendo sempre più semplice la comprensione dell'ambiente che ci circonda in maniera più naturale ed intuitiva.

Se riflettiamo su questo, si tratta di un aspetto molto semplice: aggiungendo più sensi all'intelligenza artificiale, ed addestrandola ad interpretare i nuovi stimoli che ne derivano, la potenza derivante è estremamente più elevata.

Questi concetti daranno vita alle interfacce multimodali, il futuro dell'interazione tra uomo e macchina.

Attraverso questi sistemi potremo comunicare con gli algoritmi attraverso le immagini, il testo, la voce, le gesture, gli elementi multimediali, e attraverso mezzi che probabilmente oggi non conosciamo.

Di certo, inoltre, questa nuova funzione potrebbe essere migliorata da MUM, l'ultimo modello di intelligenza artificiale di Google dedicato alla ricerca, per rendere i risultati sempre più pertinenti e completi. Nel seguente post, infatti, pubblicato in occasione di Google Search On 2021, si esplorava il futuro della ricerca e si faceva un esempio in cui, attraverso Lens, si inquadrava la trasmissione di una bicicletta, e si chiedeva al sistema: "come si aggiusta"?

E la creazione dei contenuti online come si evolverà?

Io credo che la parola chiave per il futuro sarà "correlazione". Più riusciremo a correlare le entità connettendole al mondo reale, più daremo la possibilità agli algoritmi di comprendere i contenuti da offrire alle persone in risposta agli "stimoli di ricerca".

L'intelligenza artificiale migliorerà sempre di più spingendosi ad una precisione sempre maggiore nel creare autonomamente queste correlazioni, ma i dati strutturati continueranno ad offrire degli schemi estremamente potenti.

Multisearch è disponibile come funzione beta in inglese negli Stati Uniti, e riguarda soprattutto le ricerche con intento transazionale (orientato all'acquisto di prodotti).

Per approfondire