Modelli di linguaggio: cosa sono, come funzionano, potenzialità e rischi

I modelli di linguaggio di grandi dimensioni (LLM) come GPT-4 sono estremamente potenti, e proprio per questo motivo ha senso approfondirli. Con Piero Savastano andiamo a fondo su questo tema, presentando anche un progetto di AI open source: Cheshire Cat.

In una chiacchierata con Piero Savastano (completa nel video che segue) parliamo di modelli di linguaggio di grandi dimensioni (LLM, o Large Language Model) e di un progetto (Cheshire Cat) che li interpreta in una modalità molto aderente alla mia visione. Ma discuteremo anche in merito a questioni legate al bilancio tra la protezione dei dati degli utenti e le performance di questi sistemi.

Piero è un esperto di Machine Learning e Data Science molto seguito su YouTube, proprio su queste tematiche.

Modelli di linguaggio: Piero Savastano e Alessio Pomaro

La magia dell'autocompletamento

Chiunque abbia utilizzato uno smartphone o abbia inviato una mail attraverso Gmail ha familiarità con la funzione di autocompletamento, che suggerisce la parola successiva mentre si digita un messaggio o una ricerca. Questa apparente "magia" è resa possibile grazie ai modelli di linguaggio, che sono simili a un'autocomplete su larga scala.

Modelli di linguaggio: simulazioni avanzate del linguaggio umano

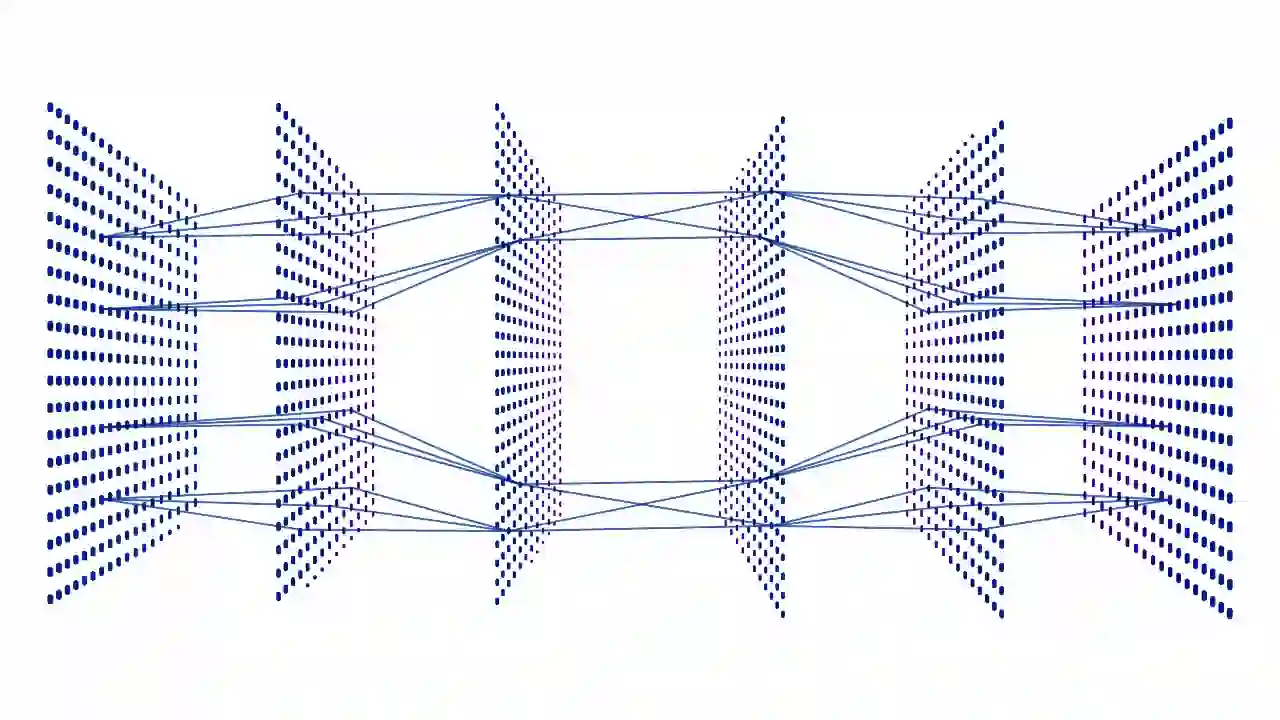

Un modello di linguaggio è essenzialmente un software che simula il funzionamento del linguaggio umano, basandosi su modelli statistici e algoritmi di apprendimento profondo (deep learning). Tali sistemi vengono addestrati attraverso l'analisi di enormi quantità di dati testuali per imparare a prevedere la parola successiva in una sequenza, tenendo conto del contesto del contenuto precedente.

I modelli di linguaggio possono suggerire parole che hanno senso e sono pertinenti al contesto in cui vengono utilizzate.

In realtà, i modelli non completano parole, ma si basano su token, ovvero su sequenze di caratteri. L'effetto percepito è il medesimo, ma si tratta di una precisazione importante.

Il funzionamento dei modelli di linguaggio: il meccanismo dell'autoregressione

Alla base di un modello di linguaggio c'è un meccanismo chiamato autoregressione, in cui gli output dipendono dagli stati precedenti.

An autoregressive model can therefore be seen as a model that utilizes its previous predictions for generating new ones.

Questo processo ciclico permette al modello di generare frasi e risposte coerenti e fluide, proprio come un essere umano potrebbe fare durante una conversazione.

Language model e intelligenza artificiale

I modelli di linguaggio sono una componente dell'intelligenza artificiale (AI) applicata al settore della comunicazione e del linguaggio naturale. Grazie ai recenti progressi nella ricerca e nello sviluppo, questi sistemi si sono evoluti fino a mostrare "capacità di ragionamento" e di risposta a domande sempre più complesse. Nonostante ciò,

..è importante ricordare che questi modelli non sono entità intelligenti in grado di conversare con noi come un essere umano, ma piuttosto macchine che completano sequenze di testo in modo probabilistico e basato sui dati a loro disposizione.

Il progetto "Cheshire Cat" e il futuro dei modelli di linguaggio

Lo "Stregatto" (Cheshire Cat) è un progetto che mira alla creazione di un'intelligenza artificiale open source basata su un'architettura cognitiva composta da varie componenti, tra cui un language model.

Oltre alla generazione di linguaggio, lo Stregatto integra una memoria a lungo termine, la possibilità di connettersi a servizi esterni e di caricare documenti per fornire un contesto più ampio e personalizzato.

L'obiettivo di questo progetto è quello di diventare il "WordPress dell'intelligenza artificiale", offrendo una piattaforma aperta e personalizzabile per sviluppatori, aziende e utenti finali.

I modelli di linguaggio come strumento per migliorare la comunicazione digitale

Ricapitolando i concetti, i modelli di linguaggio stanno rivoluzionando il modo in cui interagiamo con i nostri dispositivi e le nostre applicazioni. Grazie all'apprendimento profondo e all'elaborazione del linguaggio naturale, questi modelli ci permettono di comunicare in modo più fluido e coerente, aprendo nuove opportunità nel campo dell'intelligenza artificiale e della comunicazione digitale. Con progetti come Cheshire Cat, il futuro dei modelli di linguaggio appare promettente e accessibile a tutti, offrendo soluzioni open source e rispettose della privacy per un'interazione sempre più avanzata e personalizzata.

Il video di presentazione di Cheshire Cat

Applicazioni pratiche dei modelli di linguaggio: dall'automazione all'assistenza clienti

I modelli di linguaggio offrono una vasta gamma di applicazioni pratiche che vanno oltre la semplice generazione di testo. Ad esempio, possono essere utilizzati per automatizzare processi interni in un'azienda, come la gestione dei dati e l'inserimento di informazioni nel CRM (Customer Relationship Management). Inoltre, possono essere impiegati come assistenti virtuali per migliorare l'esperienza di assistenza clienti, rispondendo a domande frequenti e fornendo informazioni pertinenti in tempo reale. Queste applicazioni non solo consentono di risparmiare tempo e risorse, ma contribuiscono anche a una maggiore soddisfazione del cliente e a una migliore efficienza operativa.

Problemi etici e legali legati ai modelli di linguaggio

Nonostante i numerosi vantaggi, esistono anche problemi etici e legali che devono essere affrontati. Uno dei principali riguarda la raccolta e l'utilizzo dei dati che vengono utilizzati per la fase di addestramento. Spesso, i modelli di linguaggio vengono addestrati su enormi quantità di testo estratti dal web, il che può portare a violazioni della privacy e del copyright. In alcuni casi, le autorità di regolamentazione hanno bloccato l'accesso a servizi basati su modelli di linguaggio a causa di preoccupazioni sulla protezione dei dati.

Solo per fare alcuni esempi, quelle che seguono sono due importanti comunicazioni del Garante per la Protezione dei Dati Personali italiano.

Il ruolo delle istituzioni e della regolamentazione nell'evoluzione dei modelli di linguaggio

Affinché questi sistemi possano continuare a evolversi e a offrire benefici significativi, è necessaria una stretta collaborazione tra istituzioni, legislatori e sviluppatori.

La regolamentazione deve essere adeguata e tempestiva per garantire che le innovazioni tecnologiche non siano ostacolate, ma allo stesso tempo sia garantita la protezione dei dati e dei diritti degli individui.

Ad esempio, potrebbe essere interessante un progetto per creare un modello di linguaggio italiano, magari co-finanziato dallo Stato e/o da una rete di imprese. In Europa esistono altri esempi di iniziative di questo tipo.

Il futuro dei modelli di linguaggio: verso un'interazione più avanzata e personalizzata

Con l'avanzare della ricerca e dello sviluppo nel campo dell'intelligenza artificiale e dei modelli di linguaggio, è probabile che assisteremo a un'evoluzione nella qualità e nella personalizzazione delle interazioni digitali.

Progetti come Cheshire Cat sono solo l'inizio di un futuro in cui i modelli di linguaggio saranno integrati in una vasta gamma di applicazioni e servizi, offrendo soluzioni sempre più avanzate e rispettose della privacy.

L'obiettivo è quello di creare un'interazione digitale più intuitiva e umana, in cui l'intelligenza artificiale sia al servizio delle esigenze e delle preferenze individuali.

Potenzialità e rischi nell'utilizzo dei modelli di linguaggio

Nella parte finale del video, viene espresso un concetto sul quale vorrei porre attenzione.

Le istituzioni non si stanno minimamente rendendo conto di quanto sono grandi questi cambiamenti.. ma non solo dal punto di vista economico e di produzione: la quantità di implicazioni politiche, sociali, etiche è praticamente sterminata.

Mi rendo conto che sia difficile da comprendere.. in fondo parliamo di modelli che generano semplici output digitali, giusto?

Vorrei provare a spiegare cosa si intende con un esempio.

L'11 aprile, alcuni scienziati della Carnegie Mellon University hanno pubblicato un paper dal titolo "Emergent autonomous scientific research capabilities of large language models", in cui presentano un sistema basato su diversi modelli di linguaggio che consentono la progettazione, la pianificazione e l'esecuzione autonoma di esperimenti scientifici.

I due aspetti che mi hanno colpito maggiormente sono i seguenti.

- Le conclusioni. I modelli hanno dimostrato grandi capacità di ragionamento e progettazione sperimentale. I problemi sono stati affrontati efficacemente, generando codice di alta qualità.

- L'appello alla sicurezza. Gli scienziati si rivolgono alle big tech per promuovere controlli adeguati che garantiscano un utilizzo sicuro e responsabile di un potenziale così elevato.

Spero che l'esempio sia utile per capire meglio di che potenza parliamo e di che responsabilità abbiamo.

Nota sui contenuti di questo post

Il contenuto principale di questa pagina è stato realizzato attraverso GPT-4 generando un prompt che considera come dati di riferimento la trascrizione del video ottenuta attraverso Whisper.

Anche l'indice dei capitoli del video è stato generato utilizzando GPT-4 e un prompt che usa come contesto la trascrizione automatica di YouTube

Quelli che ho descritto sono due esempi di come questi sistemi possono essere utilizzati per elaborare un contesto "chiuso", senza attingere ad informazioni esterne, quindi con un rischio praticamente nullo di produrre allucinazioni.

Per approfondire

Nel seguente post di Linkedin ho scritto una lettera per il Garante della Privacy, in cui cerco di rendere più chiaro il funzionamento dei modelli di linguaggio e di esprimere concetti che possono aiutare a ragionare su di essi in relazione al trattamento dei dati. La riporto sotto.

La lettera al Garante della Privacy

Siamo difronte ad un "loop", ma per comprenderlo serve un'esplorazione che coinvolge diverse discipline. Un loop che ci fa rimbalzare tra l'efficienza dei modelli di linguaggio e la privacy (sacrosanta) degli utenti.

Dimentichiamoci per 10 minuti di ChatGPT, e proviamo a riflettere.

L'utilizzo davvero utile dei Large Language Model è quello in cui vengono usati per generare contenuti e risposte in linguaggio naturale in base all'elaborazione di dati che NOI estraiamo e mettiamo a disposizione degli algoritmi. Dati dei quali NOI abbiamo la responsabilità.

A nessuno interessa usarli sotto forma di chat per chiedere "chi è Alessio Pomaro", perché abbiamo a disposizione potenti motori di ricerca. Ovviamente, però c'è chi lo farà, ma ciò che esprimo in seguito riguarda anche questo aspetto.

Il problema è il seguente:

per scrivere in linguaggio naturale in maniera evoluta, i modelli hanno bisogno di enormi quantità di dati di training, ma che servono esclusivamente per apprendere probabilità di sequenze di caratteri. I dati degli utenti, fondamentalmente, non servono a nulla.

Quindi, una volta compresa la natura di questi sistemi, e considerata la loro potenzialità, nell'attesa che nascano nuove architetture, possiamo agire a monte (sui dati di training) o a valle del modello, con filtri per impedire che "allucinazioni" generino dati non reali che possono essere dannosi per le persone.

La prima soluzione la vedo abbastanza impraticabile e poco performante tecnicamente. Ma la seconda sarebbe sufficiente a livello di normativa per la protezione dei dati?

Questa, secondo me, è la vera discussione sulla quale ha senso aprire un tavolo a livello mondiale. Perché TUTTI i modelli di linguaggio funzionano in questo modo. E il ragionamento vale anche per la generazione di immagini e di altri output digitali.