In and Out the Black Box

I modelli di AI diventano sempre più performanti, ma allo stesso tempo compiono errori che sembrerebbero banali a chiunque. Qual è la direzione? Lo vedremo in un viaggio tra innovazione e consapevolezza, dentro e fuori dalla "black box".

Punti salienti

- Significato dell'Intelligenza Artificiale

L'intelligenza artificiale suscita aspettative diverse a seconda della sua definizione, che spazia tra apprendimento, adattamento e capacità emotive. - Distinzione tra AI Ristretta e Generale

Tradizionalmente, l'AI si distingue in ristretta e generale, ma strumenti come ChatGPT mostrano la necessità di nuove classificazioni. - Sfida della spiegabilità delle Black Box

Sebbene comprendiamo le dinamiche delle reti neurali, il volume di dati e la complessità richiedono metodi migliori per interpretarne i processi. - Capacità sovrumane e limiti banali

I modelli avanzati dimostrano capacità straordinarie su compiti complessi, ma falliscono su quelli semplici, evidenziando l'importanza di una miglior comprensione e controllo. - Nuove proiezioni per lo sviluppo dell'AI

Le reti Kolmogorov-Arnold, i sistemi neuro-simbolici, i fast weights e i modelli MatMul-free rappresenteranno le direzioni future (per migliorare efficienza, adattabilità e spiegabilità)? - Governance e Adattabilità dell'AI

Per governare l'AI occorre bilanciare sicurezza e innovazione, sviluppando trasparenza e misure adattive per guidarne l'evoluzione. - Benefici e sfide future dell'AI

L'AI è già in grado di abbattere barriere linguistiche e supportare settori cruciali, come la medicina e il cambiamento climatico, richiedendo però una crescente consapevolezza da parte degli utenti.

Quando i fratelli Wright iniziarono a sperimentare con una sorta di "macchina volante", di certo non sapevano come costruire un aereo.. ma chiunque, in quegli anni, conosceva il significato di “volare”. Ovvero, l’obiettivo era chiaro.

Nel caso dell’intelligenza artificiale, siamo in una situazione diversa.. infatti, diversi esperti, hanno intuizioni diverse sul significato di “intelligenza”.

Si tratta di apprendimento e adattamento? Sono coinvolte, in qualche modo le emozioni? O il fatto di possedere un corpo fisico?

E’ chiaro che, risposte diverse a queste domande portano ad aspettative nettamente diverse rispetto alla direzione della tecnologia e ai tempi di raggiungimento.

In and Out the Black Box - L'intervento integrale dal WMF 2024

Un piccolo esempio di quanto siamo confusi.. Per molto tempo abbiamo distinto l’AI in due macro aree:

- l’AI ristretta, addestrata per un compito specifico, ad esempio la raccomandazione delle serie TV da guardare su Netflix;

- e l’AI generale.. l’AGI (Artificial General Intelligence), che potrebbe compiere azioni come lo farebbe un essere umano.

Siamo di fronte a un divario che divide ciò che è realizzabile nella pratica, e ciò che sarebbe effettivamente intelligente.

..poi è arrivato ChatGPT (e simili)

Si tratta di un’AI ristretta? Oppure è un’AGI? Nessuna delle due!

Ha, di certo, uno scopo generale: può programmare, scrivere testi, analizzare problemi, "pensare" (in riferimento ai nuovi modelli o1), ecc., ma è un sistema ben lontano da poter agire come lo farebbe un essere umano.

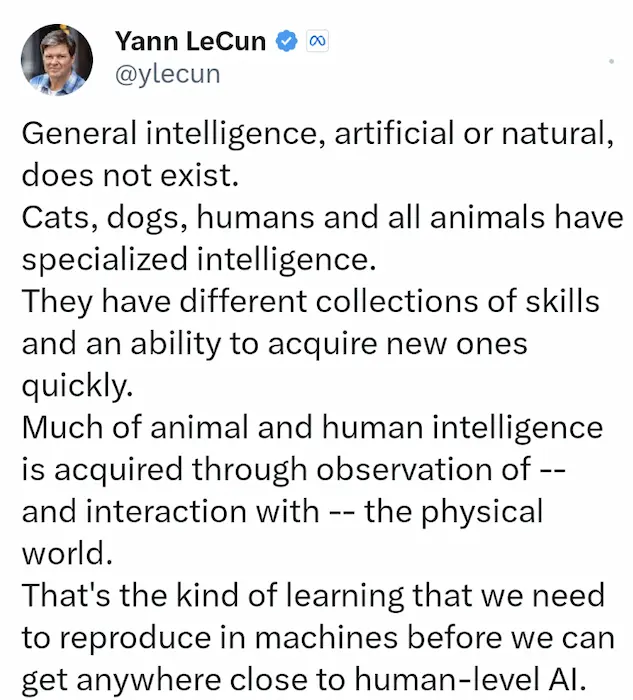

È chiaro, dunque, che servono nuovi livelli di categorizzazione dell'AI.. e, soprattutto, stanno nascendo nuove interpretazioni. Yann LeCun, in un post, afferma che non esiste un’intelligenza generale, perché anche quella degli esseri umani è l'insieme di più intelligenze ristrette, su diverse competenze, che crescono in base all’osservazione del mondo fisico. E secondo lui è proprio questa la direzione di sviluppo dell’AI.

Insomma.. com’era chiaro il significato di volare ai tempi dei fratelli Wright (l’obiettivo della loro sperimentazione), anche oggi, in ambito di AI, dovremo rendere chiaro ciò che stiamo andando a sviluppare.

Le misteriose black box

Oggi non comprendiamo chiaramente nemmeno i sistemi di AI che abbiamo a disposizione. Spesso, anche i ricercatori definiscono le reti neurali artificiali (la principale architettura degli algoritmi che usiamo oggi) come delle black box. Ma vorrei sfatare un mito. Non si intende che il funzionamento di questi sistemi sia “misterioso”, né che non possiamo guardare “dentro alla scatola”: in realtà conosciamo benissimo le dinamiche. Il problema è che se guardassimo nella “scatola”, vedremmo milioni, miliardi, trilioni di numeri, che vengono sommati e moltiplicati insieme. Troppi numeri per essere compresi! Non disponiamo ancora di buoni metodi per rappresentare e comprendere tutto questo.

Tuttavia, si stanno facendo progressi.

Questo, ad esempio, è uno studio di Anthropic che va proprio nella direzione della spiegabilità dei modelli, attraverso il quale il team tecnico condivide i tentativi di isolare le attivazioni della rete neurale di Claude 3 Sonnet su determinati argomenti.

Capacità sovrumane.. ed errori banali

Queste black box, tuttavia, dimostrano capacità sovrumane in ambiti inaspettati.. su attività molto “umane”. Alcuni esempi..

Alcuni studi sulle performance dei LLM a confronto con le capacità degli esseri umani

- [paper] GPT-4, con un obiettivo preciso, si è dimostrato più persuasivo rispetto agli esseri umani in fase di dibattito, con risultati schiaccianti.

- [paper] Lo stesso modello, può aiutare a rivalutare situazioni emotive difficili, battendo gli esseri umani su 3 delle 4 metriche di misurazione; una di queste è l’empatia percepita.

- [paper] GPT-4 può produrre idee di startup ritenute migliori di proposte fatte da studenti formati in business school, e lo fa in modo più veloce ed economico.

- [paper] Un modello di Google ha superato drasticamente i medici di base a livello tecnico, ma soprattutto anche sulla capacità di giudizio ed empatia.

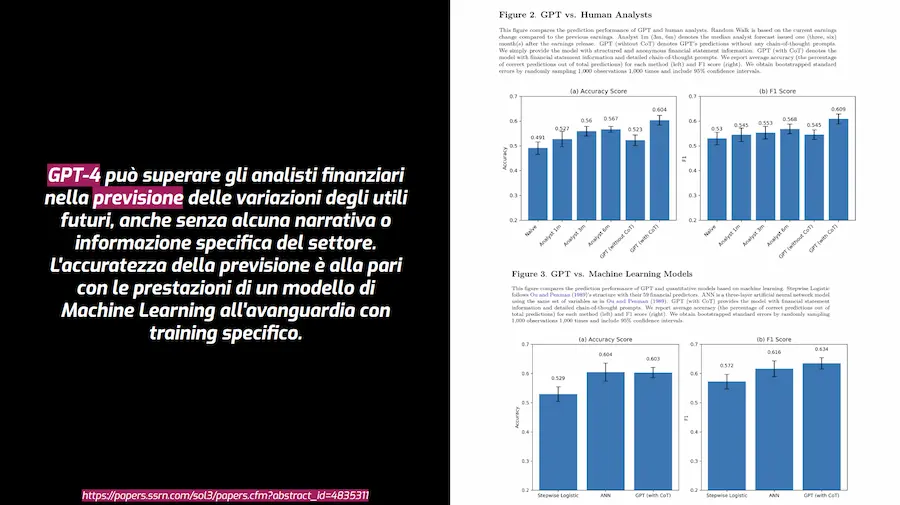

- [paper] GPT-4 ha superato gli analisti finanziari nella previsione.. e ha superato anche modelli di Machine Learning specifici su quell’attività.

- [paper] Questi modelli battono gli esseri umani anche su compiti creativi, come il pensiero divergente e la scrittura creativa.

Impressionante! Per non parlare della capacità espressiva nell'interazione vocale.

Demo di interazione vocale con ChatGPT

Tuttavia, dopo tutta questa eccellenza, gli stessi modelli possono "cadere" su attività in cui è richiesto un livello di ragionamento molto ridotto. Ho chiesto a GPT-4o : “devo parlare con l’unico fratello di mio fratello, come posso fare?”.. e ho ottenuto una risposta sintatticamente corretta, ma non molto sensata.

Mia figlia di 5 anni ha saputo rispondere, quasi deridendomi 😄

La stessa domanda in un altro momento, invece, ottiene una risposta migliore.

Come si evolveranno questi sistemi?

Per ora, siamo concentrati sulla scala: aumentano le dimensioni dei modelli, aumentano le dimensioni dei dataset di training, aumentano le risorse hardware necessarie.

Ma forse non basterà.. e il fatto che GPT-4 è ancora il riferimento potrebbe essere un segnale importante.

Anche Sundar Pichai sembra d’accordo (non solo lui, in realtà).

Vediamo 4 proiezioni di sviluppo interessanti.

1 - Kolmogorov-Arnold Networks (KANs)

Nell'architettura delle reti neurali che usiamo oggi (che vengono definite MLP - Multi-Layer Perceptron) ogni neurone esegue una funzione matematica, e le connessioni tra i neuroni rappresentano dei valori fissi (pesi o parametri) che vengono impostati in fase di training.

Nelle KAN (Kolmogorov-Arnold Networks), invece, le connessioni tra i neuroni sono delle funzioni matematiche messe a punto in fase di training, che successivamente possono adattarsi ai dati, rendendo la struttura più flessibile.

Questo porta a dei vantaggi enormi, in termini di accuratezza, spiegabilità, scalabilità, efficienza.. riuscendo ad avere performance elevate con meno dati. A fronte di una maggior complessità nell’architettura e nell’implementazione.

2 - Sistemi neuro-simbolici

Nella seconda proiezione, abbiamo i sistemi neuro-simbolici. Ovvero sistemi che uniscono le reti neurali artificiali (veloci e scalabili) ai sistemi simbolici, per rafforzare la componente di logica e ragionamento. Per creare modelli che mettono insieme una componente di intuizione e una di razionalità.

Un’interpretazione di questi sistemi è AlphaGeometry di Google DeepMind (che nel frattempo ha sviluppato la seconda versione), un sistema neuro-simbolico che risolve problemi di geometria complessi a un livello che si avvicina a quello di una medaglia d'oro alle Olimpiadi della Matematica.

3 - Fast weights

La terza proiezione inizia da questo esempio di Geoffrey Hinton, uno degli scienziati simbolo del Machine Learning che conosciamo..

Se dicessimo una parola inaspettata come “cetriolo”.. Se dopo 5 minuti ascoltassimo parole deboli in un ambiente rumoroso, saremmo più bravi a riconoscere quella parola, grazie ai cambiamenti temporanei nelle sinapsi.

Il concetto di “fast weight” va proprio a imitare questa caratteristica del cervello umano, con le connessioni delle reti neurali che possono cambiare temporaneamente in base agli input.

Con vantaggi come l’adattamento rapido, la memoria temporanea, e l’efficienza computazionale. Tutti elementi chiave per le future applicazioni in real-time basate sull'AI.

4 - Scalable MatMul-free Language Modeling

Un nuovo paper dimostra che è possibile ridurre in modo significativo la complessità e il consumo di risorse dei LLM, senza degradare le performance.

Per farlo è stata eliminata la moltiplicazione di matrici (MatMul), ovvero la principale causa del costo computazionale di questi sistemi.

Alcuni risultati:

- fino al 61% di memoria in meno durante il training e una riduzione di 10 volte in fase di inferenza;

- l'uso di un hardware personalizzato, ha permesso di processare modelli su scala di miliardi di parametri con un consumo energetico di 13W.

Governance

Come governiamo tutto questo?

Vorrei trasmettere due concetti.

Non lasciamoci intimidire dalla tecnologia.

Può creare confusione, ma non è magia. Ci sono alcune parti che comprendiamo già molto bene! E le parti opache non rimarranno tali per molto tempo (abbiamo già visto la direzione, con Anthropic, ad esempio).

Dobbiamo concentrarci sull’adattabilità, non sulla certezza!

Spesso il dialogo sul tema AI si divide in:

- “dobbiamo regolamentare l’AI in modo rigido, perché è molto rischiosa!”, e

- “..ma la regolamentazione ucciderà l’innovazione!”

Io credo che la questione non sia sono una

scelta tra frenare o accelerare.

Dovremmo provare a visualizzarla come guidare lungo una percorso, pieno di curve e svolte inaspettate. Dove abbiamo bisogno di due elementi:

- una visione chiara della strada, e

- un eccellente sistema di sterzo.

In ambito di AI, questo significa avere un quadro chiaro della direzione della tecnologia, e piani in atto per i potenziali scenari.

Per arrivare a questo, si dovranno migliorare i sistemi di misurazione delle capacità dei modelli (oggi sono rudimentali rispetto alla tecnologia stessa), e si dovrà pretendere trasparenza dalle big tech che sviluppano i sistemi, per conoscere potenzialità e rischi. Su questi punti, le istituzioni stanno già lavorando, ad esempio l’Europa con l’AI Act.

Tutto questo ci permetterà di avere un quadro chiaro, capendo se l’AI sta progredendo in direzioni pericolose.

Incertezze e disaccordi.. ma non solo!

Il mondo dell’AI, oggi, si presenta con incertezze e disaccordi. Ed è vero che queste tecnologie sono nelle mani di poche aziende, che le stanno già distribuendo, impattando le nostre vite.

Ma ricordiamoci che il potenziale che

abbiamo a disposizione va ben oltre.

L’AI oggi ci permette già di abbattere le barriere linguistiche, ci permette di prevedere la struttura delle proteine.. e questi sono alcuni esempi. L’AI potrà aiutarci in ambito di cambiamento climatico e di produzione di energia in modo migliore.. e molto altro.

NeuralGCM: il progetto di Google DeepMind dedicato al cambiamento climatico

Invito tutti ad essere più consapevoli di tutto questo, ricordandoci che ognuno di noi ha voce in capitolo, perché siamo utenti, siamo lavoratori, siamo cittadini.

..e non siamo solo fonti di dati per gli algoritmi.

- GRAZIE -

Se hai apprezzato il contenuto, e pensi che potrebbe essere utile ad altre persone, condividilo 🙂