GPT-4o: il più performante, multimodale, e.. gratuito!?

3 riflessioni sulle novità presentate da OpenAI durante lo Spring Update

Probabilmente siamo già saturi delle novità esposte da OpenAI durante lo Spring Update: ne ha già parlato ogni canale presente online.

Le sintetizzo brevemente nella seconda parte.. prima vorrei condividere 3 riflessioni.

1) Il miglior modello esistente gratuito

Il cambiamento radicale presentato da OpenAI riguarda l'accesso gratuito al miglior LLM esistente (GPT-4o) attraverso ChatGPT.

Da questo momento, chi pagherà un abbonamento per un modello inferiore della concorrenza?

Chiaramente, gli utenti ChatGPT Plus continueranno ad avere vantaggi (esempi: rate limit, priorità, voice), ma sarà sufficiente per evitare che molti di essi valutino di non mantenere la versione a pagamento? Probabilmente è una scelta strategica più orientata ai clienti business (API), mantenendo l'accesso gratuito alla versione Chat, anche se la prospettiva potrebbe cambiare rapidamente in vista del prossimo modello di nuova generazione (GPT-5 o quello che sarà).

Se questo modello di business funzionerà per OpenAI, di certo si tratta di una grande mossa per abbattere i competitor e le motivazioni verso sviluppi di soluzioni con tecnologia open source (al netto di esigenze specifiche).

2) La naturalezza dell'interazione

GPT-4o è un modello end-to-end nativamente multimodale. Questo significa che è in grado di elaborare testo, audio, voce, video e immagini contemporaneamente, in modo continuo.

Questa evoluzione era abbastanza prevedibile: di fatto, le interazioni tra esseri umani sono di questo tipo. Gemini Pro di Google, inoltre, ci ha già dato un assaggio di sistemi di questo tipo (un esempio).

Ma le interazioni vocali (e multimodali) viste durante la presentazione, mostrano una naturalezza alla quale non siamo abituati, soprattutto se abbiamo scagliato dalla finestra qualche dispositivo Google Home e/o Alexa.

Possiamo dire addio ai "turni della conversazione" scanditi da segnali acustici e il dover attendere che l'assistente termini la risposta:

quello che abbiamo visto è una "vera" conversazione, con la possibilità di intervenire mentre l'agente si esprime, ad un ritmo assolutamente paragonabile alla comunicazione tra esseri umani.

L'assistente è in grado di interagire con quello che "vede" in real-time attraverso la camera del dispositivo, e nella versione desktop con i contenuti presenti nello schermo.

Infine, un aspetto sbalorditivo riguarda il riconoscimento delle emozioni dell'interlocutore.

Tutto questo è sufficiente per un utilizzo naturale in ogni ambito? Probabilmente non ancora. Ma l'avvicinamento all'obiettivo e il distanziamento con ciò che conoscevamo in precedenza è davvero impressionante.

3) La natura di questi modelli.. reminder

Come ha detto Sundar Pichai in una recente intervista..

Sarei sorpreso se i LLM fossero l'unica cosa di cui abbiamo bisogno per fare progressi.

Un modello di linguaggio può essere talmente performante da darci perfettamente la sensazione di “comprensione” e “ragionamento” (e su questo ci siamo quasi), ma non ha basi logiche solide e affidabili. Questo dobbiamo tenerlo sempre presente.

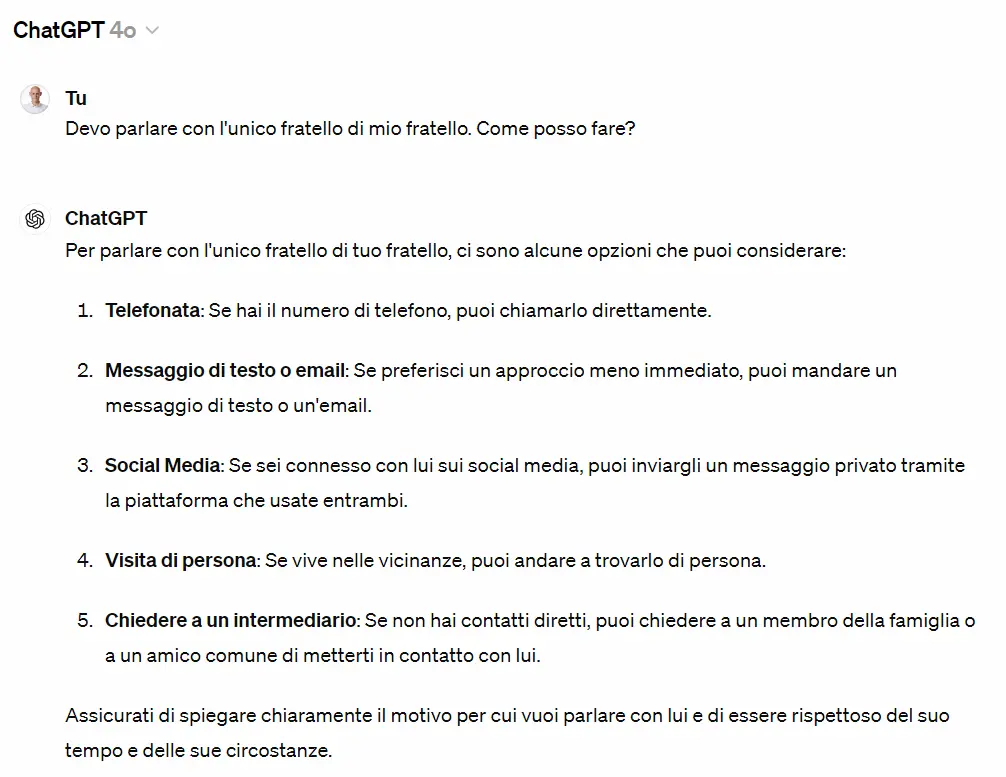

Nell'esempio che segue, vediamo due risposte di GPT-4o alla domanda "devo parlare con l'unico fratello di mio fratello. Come posso fare?". La prima è completamente fuori luogo, mentre la seconda rappresenta una buona interazione.

Un test di GPT-4o

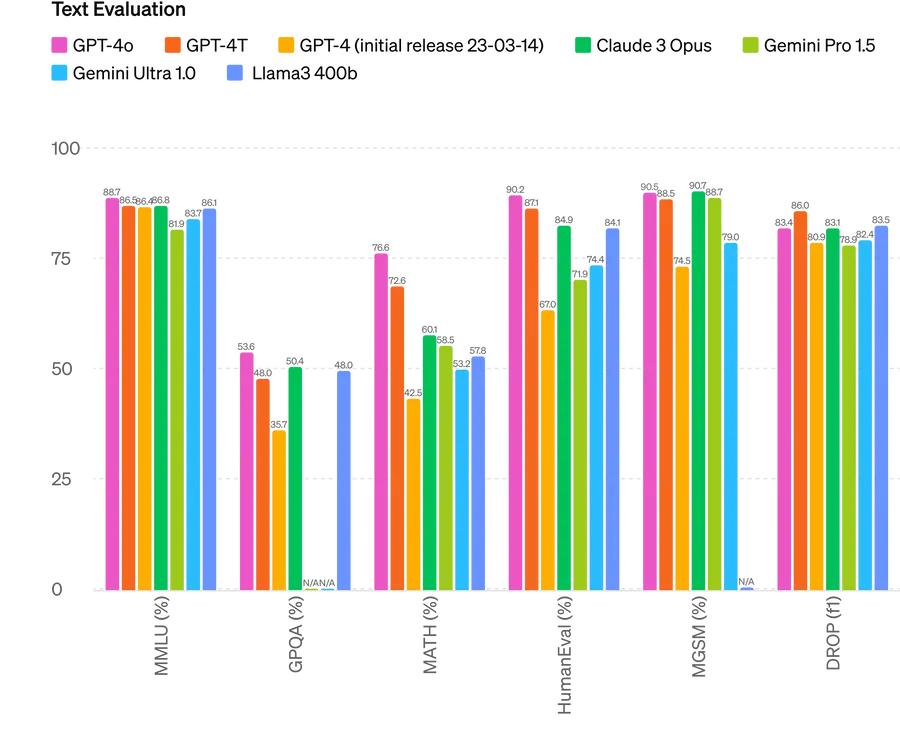

Questi modelli ottengono punteggi impressionanti su molti benchmark, superano esami in modo più brillante della media delle persone, ma “cadono” su domande che richiedono ragionamenti che a chiunque sembrerebbero banali.

Questo rappresenta un problema? No, se ne abbiamo la consapevolezza e li usiamo laddove possono darci dei reali vantaggi. Questi sistemi, in un certo senso, si comportano in modo intelligente pur non essendo intelligenti.

Una sintesi delle novità presentate da OpenAI

Durante la tanto attesa live di OpenAI, programmata esattamente 24 ore prima dell'I/O 2024 di Google, Mira Murati (Chief Technology Officer di OpenAI) ha presentato diverse novità interessanti.

OpenAI Spring Update

Le vediamo in una rapida sintesi.

- GPT-4o ("o" = "omni") è il nuovo flagship model di OpenAI, che sarà disponibile via ChatGPT (anche nella versione gratuita) e via API. Chiaramente è anche il modello più performante esistente.

it is a very good model (we had a little fun with the name while testing) pic.twitter.com/xKIwhKyRGt

— Sam Altman (@sama) May 13, 2024

- 2 volte più veloce, con un costo inferiore del 50%, e con un rate limit di 5 volte superiore rispetto a GPT-4 Turbo.

- Un modello nativamente multimodale, che fonde testo, audio, voice e vision.

- Durante la live, sono state fatte diverse interazioni con l'assistente vocale di ChatGPT, dimostrando una naturalezza impressionante, eliminando il concetto dei "turni della conversazione", riconoscendo le emozioni dell'utente e modificando il tono del dialogo su richiesta.

- È stata presentata una versione desktop di ChatGPT, che può rimanere aperta in background, dialogare con l'utente, e interagire con gli elementi dello schermo.

Se OpenAI chiudesse davvero l'accordo con Apple e riuscisse a implementare un GPT-4o distillato sul dispositivo per sostituire Siri..

beh, ne vedremo delle belle 🙂

- GRAZIE -

Se hai apprezzato il contenuto, e pensi che potrebbe essere utile ad altre persone, condividilo 🙂