Generative AI: novità e riflessioni - #1 / 2024

Un appuntamento per aggiornarsi e riflettere sulle tematiche che riguardano l'intelligenza artificiale e la Generative AI.

Spesso mi vengono chiesti dei suggerimenti per mantenere un livello di aggiornamento adeguato sulle tematiche che riguardano l'Intelligenza Artificiale. Non è semplice, vista l'accelerazione, lo so bene.

Proprio per questo, ho ideato una rubrica che ripercorre le novità più rilevanti con qualche riflessione, e questo è il primo appuntamento.

Buon aggiornamento,

e buone riflessioni..

Le novità dalla Generative AI e qualche riflessione

OpenAI ha rivoluzionato il settore un anno fa, e nell'ultima conferenza per sviluppatori ha mostrato delle possibilità incredibili che andranno a cambiare per sempre la creazione di contenuti, la UX, e non solo. Ma OpenAI è solo una parte dello scenario.

Quello che segue è il mio intervento alla Bologna Tech Week (Search Marketing Connect) di dicembre, in cui cerco di dare una visione e un ordine su tutti questi aspetti.

Search Marketing Connect 2023

AI ACT + Azione del Garante della Privacy nei confronti di OpenAI

Condivido due risorse interessanti per chi vuole aggiornarsi, chiarire e riflettere su due tematiche "calde" legate all'intelligenza artificiale.

AI ACT

Luciano Floridi e diversi ospiti intervengono e dialogano sulla regolamentazione dello sviluppo che riguarda l'intelligenza artificiale.

"Ogni scoperta porta con sé grandi inquietudini collettive, ma altrettante opportunità".

Notifica del Garante della Privacy a OpenAI: l'atto di contestazione per le violazioni alla normativa privacy

Matteo Flora e l'avv. Giuseppe Vaciago chiariscono il tema e discutono sulla recente azione.

Il Garante ancora contro ChatGPT? - Matteo Flora

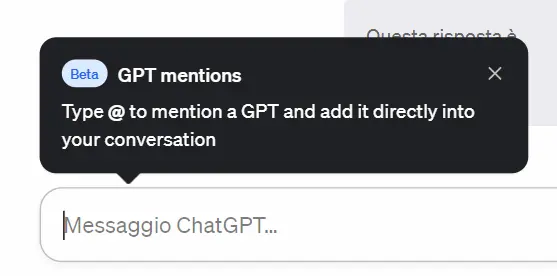

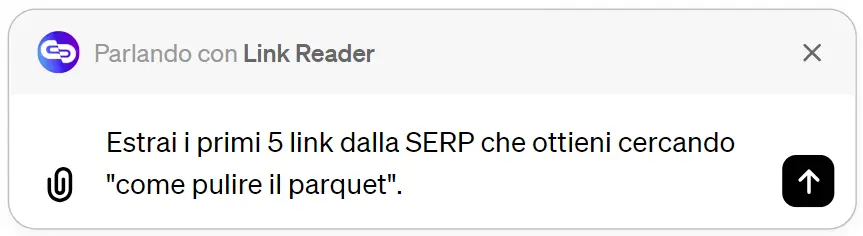

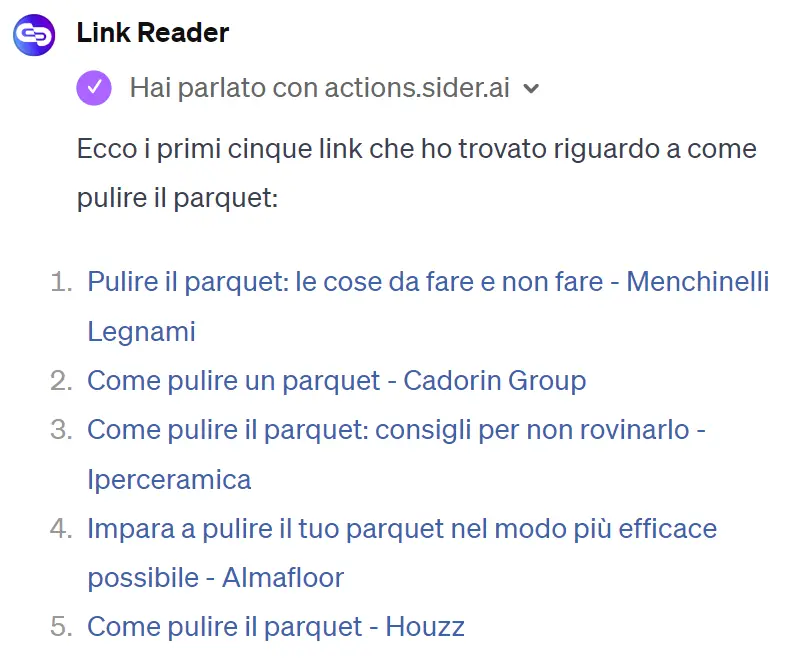

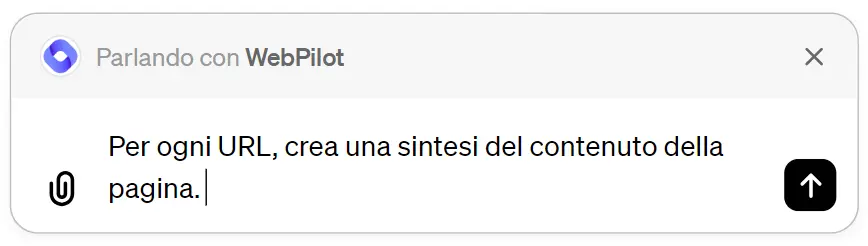

Come usare diversi GPTs nella stessa chat di ChatGPT

Come possiamo usare diversi GPTs che elaborano i dati nella stessa chat su ChatGPT? Semplicemente taggando il GPT che ci serve nel prompt con il carattere "@".

Nell'esempio, uso il GPT di "Link Reader" per estrarre link dalla SERP, e successivamente quello di "WebPilot" per elaborarne il contenuto.

Il mio dubbio sui GPTs è stato risolto. Direi che ora sono sovrapponibili ai plugin, i quali non dureranno a lungo.

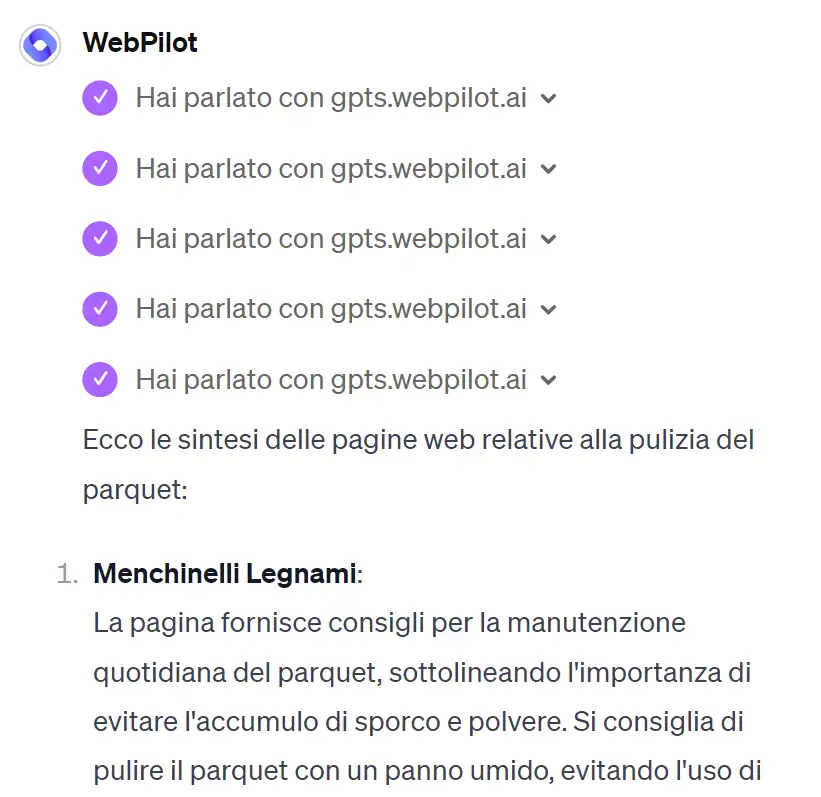

Il futuro dell'AI è neuro-simbolico?

Durante il WMF 2023 dissi che forse una via per l'AI del futuro sarà il ricongiungimento delle due teorie dalle quali ha preso vita: le reti neurali e i sistemi simbolici. Per puntare a un'AI veloce, scalabile e in grado di astrarre, ma anche solida nel rappresentare i fatti e il ragionamento.

AlphaGeometry, il sistema che recentemente ha risolto difficili problemi matematici (livello scuola superiore), è esattamente questo: un sistema "neuro-simbolico".

La combinazione del ragionamento speculativo neurale con la conoscenza logica strutturata promette sistemi integrati che pensano in modo flessibile e rigoroso. Questa fusione offre un percorso solido per coltivare un ragionamento automatizzato a tutto tondo, simile a quello umano.

Code Llama 70B

Meta ha rilasciato Code Llama 70B: un nuovo sistema più performante per la generazione di codice basato su LLM.

Ha una versione specifica per Python, e le prestazioni sono tra le più elevate rispetto agli altri modelli di questo tipo.

Ottiene un punteggio di 67,8 su HumanEval.

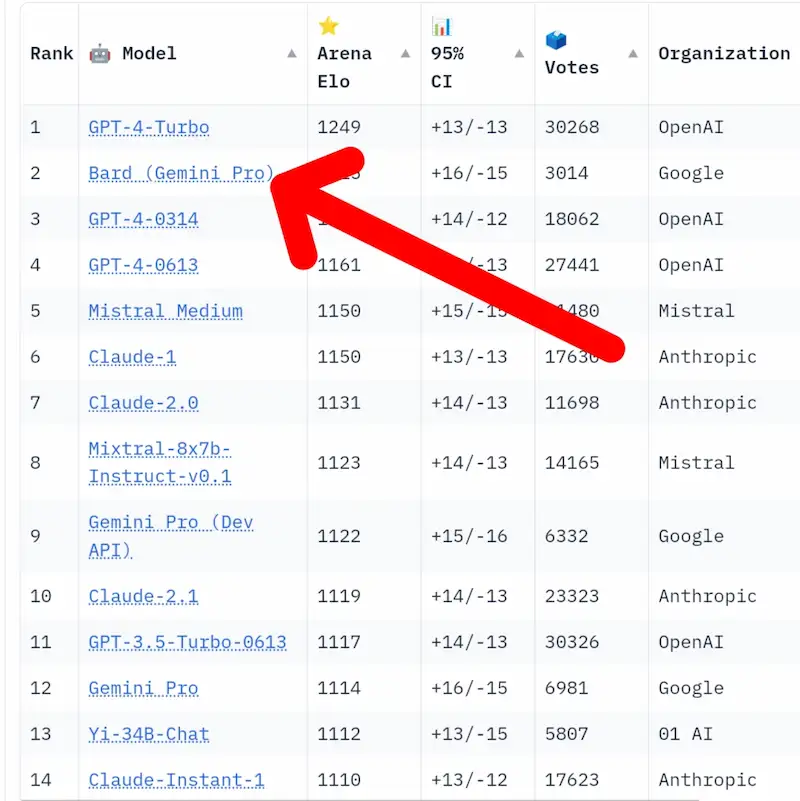

Google Bard (Gemini Pro) migliora

Non me lo sarei mai aspetto, ma Bard, equipaggiato con Gemini Pro, balza al secondo posto della "LLM Arena Leaderboard" (una delle classifiche più attendibili per i modelli).

Ho fatto alcuni test ultimamente, con prompt evoluti che uso con GPT-4 e ho ottenuto risposte ottime e veloci.

Fino a qualche giorno fa, in questa classifica, OpenAI era nelle prime 3 posizioni. Sono contento che Google rientri in pista.

Cosa dovremo aspettarci dalla versione Ultra? Gli altri non staranno a guardare, comunque.

InstantID: generazione di immagini preservando i tratti delle persone

InstantID è una nuova soluzione per la generazione delle immagini preservando i tratti delle persone, analizzando una sola immagine facciale.

Si basa su un modello di diffusione, e si integra con modelli pre-addestrati, come Stable Diffusion XL.

Supera le tecniche precedenti in termini di fedeltà e adattabilità dello stile, senza richiedere un'intensa messa a punto.

Modelli di linguaggio: cosa sono, perché se ne parla tanto e che futuro avranno

In un'intervista su La Repubblica racconto i modelli di linguaggio (LLM).

Che impatto avranno? Quali sono i rischi? Perché l'open source rappresenta una via interessante? Che differenza c'è tra i vecchi chatbot e le nuove tecnologie?

"..i modelli generativi offriranno strumenti sempre più avanzati integrati nei flussi operativi per la ricerca e l’elaborazione dei dati, e per ottenere automazioni sempre più profonde".

Novità importanti per OpenAI

OpenAI introduce nuovi sviluppi che riguardano i modelli e le API.

- GPT-3.5 Turbo migliora e verranno ridotti i costi (-50% per i token in input e -25% per l'output).

- Finalmente arrivano 2 nuovi modelli di embeddings, più performanti e a costi minori.

- GPT-4 Turbo ottimizza la generazione del codice e la tendenza alla "pigrizia".

- Migliorano le API di moderazione.

- Finalmente il monitoraggio del consumo delle API è stato ampliato: ora è possibile controllare i costi per progetto.

Segnali di maturità dello stack tecnologico e di obiettivi di miglioramento non solo orientato alle performance.

26 principi per migliorare le performance dei Large Language Model (LLM)

Come si possono migliorare le performance di un LLM fino al 50%? Questo nuovo paper mostra 26 principi da seguire.

I test sono stati eseguiti su LLaMA-1/2 (7B, 13B e 70B) e GPT-3.5/4.

Basta per ottenere ottimi risultati? NO, serve tanta sperimentazione. E la prova è il fatto che nei prompt delle automazioni in produzione che usiamo in azienda, applichiamo già quasi tutti questi principi con dei precisi schemi, ottenuti grazie a una grande quantità di test.

Va ricordato, inoltre, che i dati di contesto sono un elemento determinante per ottenere performance elevate.

La Generative AI nel video editing

Un esempio di editing video in cui vengono inseriti elementi crearti attraverso l'AI Generativa. Tutto il processo avviene con After Effects. Midjourney e Runway Gen 2 vengono usati per creare Voldemort nella parte finale e per il cielo.

L'AI Generativa, integrata nei processi di produzione, permette di mantenere il focus nelle parti principali, generando il contorno (che comunque richiederebbe grande effort).

Editing: Eric Del Aguila.

La Generative AI nel video editing

LLM-as-a-Judge

Gli approcci attuali, comunemente, addestrano modelli di ricompensa dalle preferenze umane. E questi modelli non migliorano durante il training.

In questo studio, viene usato il LLM come "giudice" per stabilire le ricompense durante il training.

Questo approccio su Llama 2 70B produce un modello che supera diversi sistemi molto noti (Claude 2, Gemini Pro e GPT4 0613) nella classifica AlpacaEval 2.0.

Si tratta di uno studio preliminare, ma si aprono nuove porte.

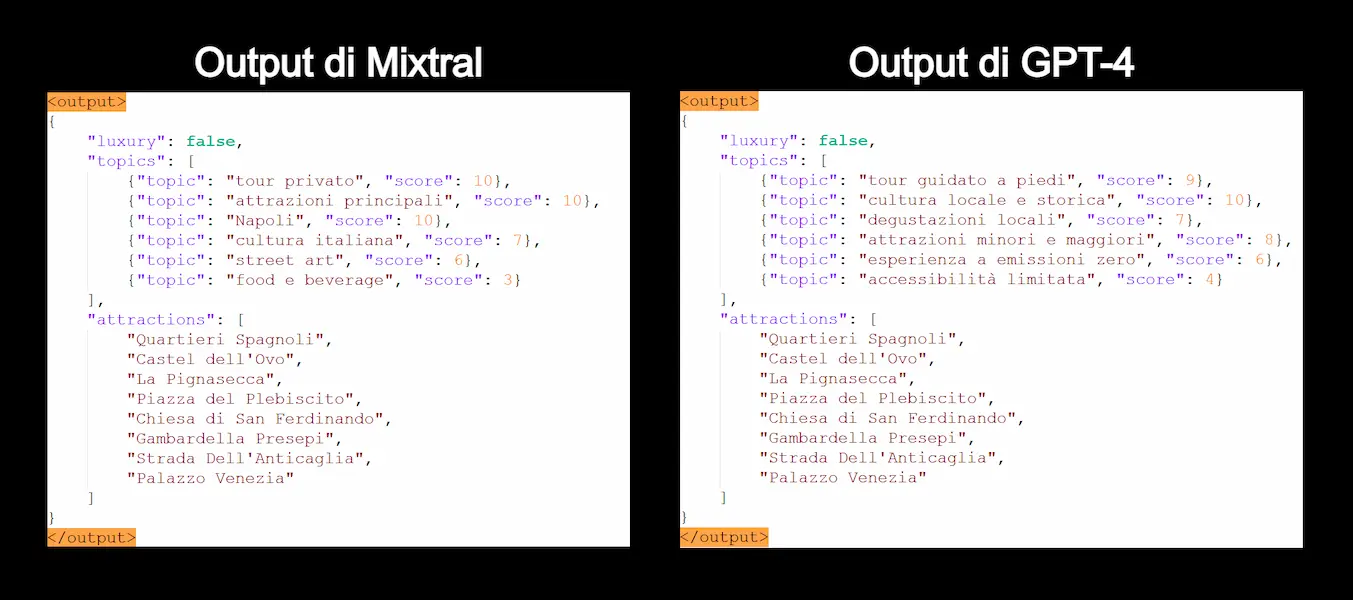

Un test di Mixtral 8x7b in confronto a GPT-4

Come si comporta Mixtral 8x7b rispetto a GPT-4 su un task di classificazione di contenuti e labeling?

I due output a confronto mostrano come Mixtral si difende benissimo, rispettando il formato dell'output e estraendo dati allineati al contenuto (una scheda di un tour guidato).

Mixtral è in esecuzione in locale, quindi, per un lavoro ampio, potrebbe rappresentare un buon risparmio sui costi.

Chiaramente i topic estratti sono diversi perché i modelli non hanno istruzioni specifiche su questo.

Finalmente un progetto italiano per la creazione di un LLM

Ne parlavamo proprio durante il Search Marketing Connect a dicembre.

Mi fa davvero piacere. Ho alcuni dubbi sulle performance a confronto con i competitor noti. La questione AI Act (in riferimento al post de Il Sole 24 Ore) è interessante e importantissima, ma le prestazioni..

Ma questo lo scopriremo insieme.

Stable LM 2 1.6B di Stability AI

Un equilibrio tra velocità e prestazioni..

Stability AI ha lanciato Stable LM 2 1.6B, un LLM di piccole dimensioni open source dalle performance elevate.

Saranno disponibili anche i dettagli sui dati, che saranno a disposizione per altri modelli.

Grazie a questi modelli, le aziende potranno sviluppare sistemi custom di qualità a costi ridotti, ma attenzione alla sicurezza!

Gemini a servizio di Google Ads

Google mette a disposizione Gemini per un assistente che potrà aiutare a creare campagne su Ads.

Un chatbot in piattaforma che può generare headlines, description e immagini in base agli URL di riferimento.

L'AI Generativa è sempre più integrata nelle piattaforme, su applicazioni semplici, ma che possono ridurre sensibilmente l'effort e migliorare le performance.

Mamba: un nuovo approccio più efficiente e scalabile

Dopo la fase crescita, forse è

arrivato il tempo dell'efficienza.

Mamba rappresenta un significativo passo in avanti nel campo dell'AI, offrendo un approccio più efficiente e scalabile per l'elaborazione di sequenze di dati.

Perché è innovativo? A differenza dei modelli Transformer, che tendono a trattare ogni parte di una sequenza come egualmente importante, Mamba può selezionare le parti più rilevanti.

Questo lo rende efficiente anche su sequenze molto lunghe.

L'evoluzione dei modelli significa performance migliori, ma anche riduzione dell'effort computazionale e dei consumi.

L'innovazione di Rabbit R1

Sto leggendo molti commenti su Rabbit R1. Un aspetto, secondo me, non è passato in modo esaustivo.

La vera innovazione non è l'assistente personale più evoluto. È il fatto che usa la "visione" per apprendere l'utilizzo di qualunque software!

La UI diventa il mezzo per far usare i sistemi ai modelli. Questo è inaspettato e straordinario.

Lasciate stare il device nelle considerazioni: si tratta di un'appendice (molto interessante, però). Potrebbe essere sostituita da un'app? Secondo me sì, ma è il concetto l'aspetto innovativo.

Prompt Generator for Images

In occasione della seconda edizione del seminario "AI per Agenzie e Team Digital" ho creato un GPT Custom in grado di guidare alla creazione di prompt per la generazione di immagini.

Puoi provarlo e usarlo gratuitamente.

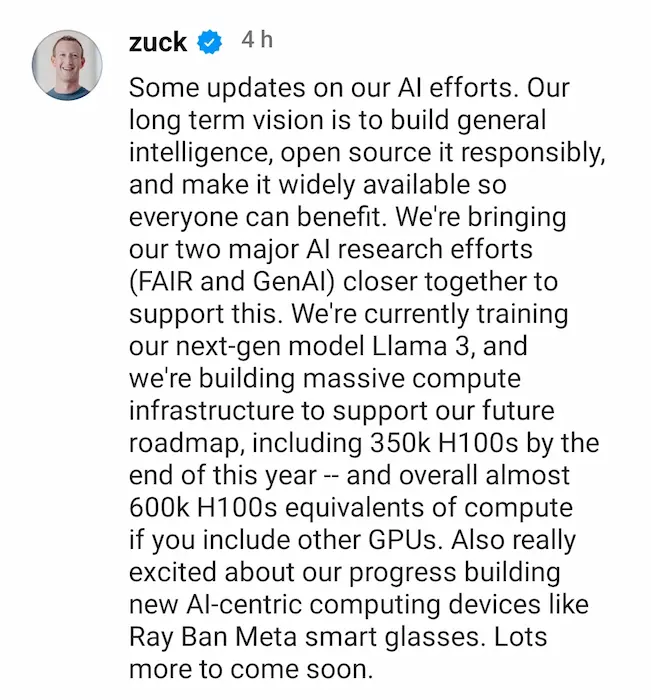

La direzione di Meta in ambito AI

Zuckerberg parla della direzione di Meta in ambito di AI: creare una general intelligence e renderla open source in modo responsabile, in modo che tutti possano trarne vantaggio.

Stanno addestrando Llama3 e creando un'infrastruttura di elaborazione impressionante: arriverà ad avere 600k H100 (GPU Nvidia).

Un progetto ambizioso, soprattutto per il fatto che viene messo in chiave open source.

Perplexity e Rabbit: una nuova partnership

Mancava solo l'ufficialità della partnership tra Perplexity e Rabbit. Eccola!

Perplexity alimenterà le risposte di Rabbit R1, il sistema che probabilmente è stata la rivelazione del CES 2024.

We're thrilled to announce our partnership with Rabbit: Together, we are introducing real-time, precise answers to Rabbit R1, seamlessly powered by our cutting-edge PPLX online LLM API, free from any knowledge cutoff. Plus, for the first 100,000 Rabbit R1 purchases, we're… pic.twitter.com/hJRehDlhtv

— Perplexity (@perplexity_ai) January 18, 2024

Gemini Pro di Google sul nuovo Samsung S24

L'AI Generativa verrà integrata su ogni piattaforma.. l'ho detto spesso ultimamente. Ed ecco Gemini Pro di Google sul nuovo Samsung S24.

Applicato a nuovi modi di effettuare ricerche, sintesi automatiche delle comunicazioni mentre si è alla guida e delle registrazioni vocali, editing delle immagini.

Mentre Microsoft porta Copilot su Windows, Google è pronta allo stesso passo su Android.

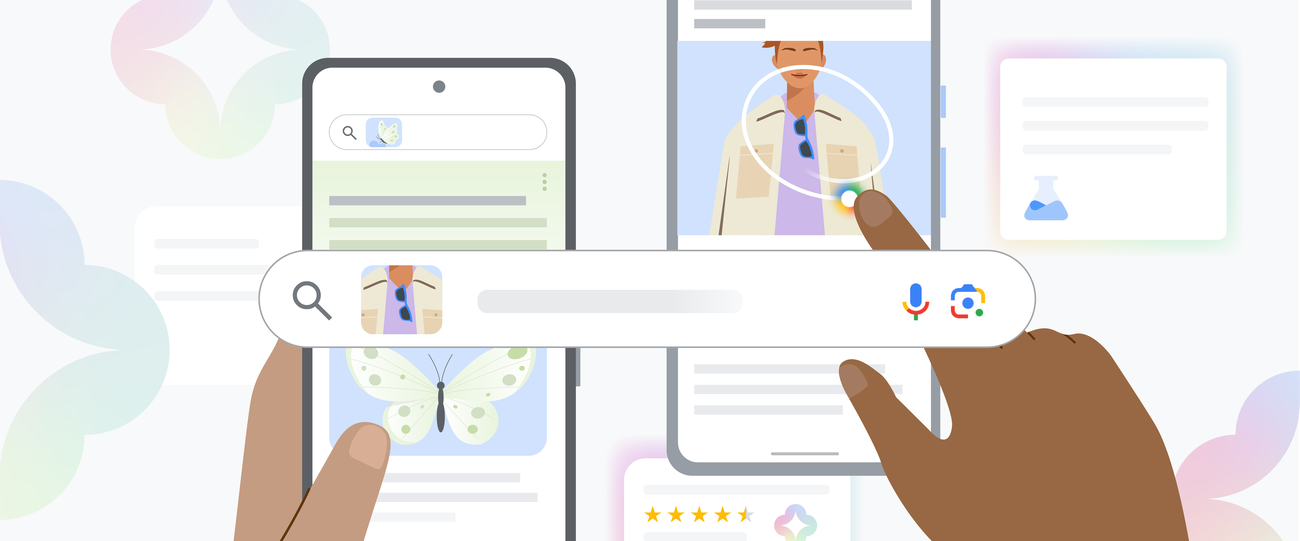

Circle to Search e AI-Powered Multisearch di Google

Google presenta due nuove modalità di ricerca: Circle to Search e AI-Powered Multisearch.

In qualunque schermata, su Android, sarà possibile cerchiare un elemento e avviare una ricerca per quell'elemento.

Alla ricerca multimodale di Multisearch viene aggiunta SGE (Search Generative Experience) nelle risposte.

La multimodalità è la direzione verso la quale tutte le interfacce si stanno dirigendo. Di fatto consente esperienze non attuabili in altre modalità.

La direzione dello sviluppo di OpenAI

In che direzione sta andando lo sviluppo di OpenAI? Altman lo racconta a Gate.

Non ci sono grandi sorprese..

- Multimodalità (inclusi input audio e video),

- Miglioramento del "ragionamento" e dell'affidabilità,

- Interazione con dati degli utenti (e-mail, calendari, ecc.) per personalizzare l'esperienza.

Due elementi importanti emergono oltre i tecnicismi: la necessità di regolamentazione (non è importante solo per gli utenti, ma anche per chi sviluppa i modelli) e la proiezione di riduzione dei costi dei modelli e dei servizi.

GPT-5 in arrivo?

Bill Gates e Sam Altman

LLM e sicurezza

Un interessante studio di Anthropic mostra come un modello può essere addestrato ad essere ingannevole.

È abbastanza chiaro: il modello "genera" seguendo delle istruzioni, e se le istruzioni sono precise, verranno eseguite.

Se si sperimenta con i GPTs e con i system prompt si può toccare facilmente con mano la resistenza nel rispettare il training. Di fatto, l'obiettivo è proprio questo.

È sempre più chiaro che servono sistemi per mettere in ordine e governare tutto questo.

I modelli Text-To-3D

I modelli Text-To-3D si evolvono costantemente. Nel video si vede un mio test usando Genie di Luma Labs.

Il sistema usa una rete neurale in grado di trasformare un prompt testuale in un oggetto 3D, scaricabile in diversi formati modificabili con qualunque editor.

Questi sistemi potrebbero avere risvolti importanti in settori come l'e-commerce e l'AR.

Genie di Luma Labs

L'intelligenza artificiale può essere creativa?

Gli algoritmi possono aiutarci a uscire dai nostri schemi, perché possono agire privi dei bias che ci condizionano.

Se questo rientra nel concetto di "creatività", allora sì, l'AI può essere creativa.

Questo è straordinario e facilmente comprensibile in ambito scientifico. Ma andiamo in tilt quando dal concetto di creatività scivoliamo nell'ambito artistico.

Propongo un ulteriore esperimento oltre a quelli descritti nel post de Il Sole 24 Ore.

Supponiamo che esca un nuovo disco di Elvis Presley generato dall'AI. Tecnicamente migliore di tutti quelli creati dall'artista.

I fan lo amerebbero? Probabilmente NO.

Perché l'arte non è solo nell'estetica dell'output, ma è anche nella consapevolezza del percorso che fa arrivare all'output.

Audiobox di Meta

Meta ha pubblicato una demo di Audiobox, il modello dedicato alla generazione di audio.

Il sistema produce gli output partendo da una combinazione di input vocali e testuali.

Siamo arrivando a livelli altissimi anche nel mondo audio.

Midjourney V6 + Runway Gen 2 + Live Action

In questo video, Dave Clark fa un uso dell'AI generativa che rispecchia la mia interpretazione di questo strumento (oggi).

Il video, infatti è realizzato in un mix di Midjourney V6, Runway Gen 2 e Live Action.

Immaginiamo solo di ridurre anche una piccola parte delle scene senza attori di un film o su un lavoro video di adv. Ovvero le scene meno importanti, ma che comunque costano.

Solo questo sarebbe un enorme risparmio, inoltre gli algoritmi consentono di fare una grande quantità di sperimentazione a basso costo.

Made a movie using Midjourney V6 + @runwayml and Live Action. The time is now for AI to push our creative at any level. Here is the teaser for a short and feature screenplay that I wrote. #ai #AIArtCommuity #aifilm #aiartwork #filmmaking #runwayml pic.twitter.com/wIbuQjLb2v

— Dave Clark (@Diesol) December 22, 2023

GPT Store e Piano Team di Open AI

Benvenuto al GPT Store. Ora è possibile cercare e usare i GPTs pubblici. Rimaniamo in attesa della monetizzazione.

Nel frattempo puoi provare il mio GPT.

È disponibile il piano "Team" per ChatGPT, come upgrade della versione Plus, con funzionalità estese.

La parte più interessante riguarda il fatto che i dati delle conversazioni non verranno usate per il training del modello.

Rabbit R1: una delle novità più interessanti del CES 2024

Al CES è stato presentato un concetto davvero interessante, definito LAM (Large Action Model).

Si tratta di un sistema che comprende l'intento dell'utente (attraverso un LLM) ed è in grado di apprendere l'interfaccia di qualunque software per mettere in azione quell'intento, indipendentemente dalla piattaforma.

Hanno anche creato un sistema operativo (Rabbit OS) basato su questo concetto e addirittura un dispositivo dedicato, ad interazione vocale, in grado di rispondere a domande e di interagire con qualunque servizio.

La modalità di apprendimento delle operazioni custom è impressionante.

Se questo è il primo passo verso una nuova generazione di assistenti virtuali multimodali, beh.. sono molto colpito.

Qualche anno fa, quando sviluppai una Google Action che usava un LLM per dare risposte, pensai che questo sarebbe stato il futuro degli assistenti personali.. mancava solo una tecnologia adeguata. Anche oggi di certo è ancora acerba, ma.. diciamo che la via sembra promettente.

Rabbit R1: la presentazione

Modelli di linguaggio e dati: un discusso post del The Guardian

Ho letto diversi commenti a questo post del The Guardian..

- Prima di tutto, il tema è la quantità di dati che questi modelli necessitano in fase di training per ottenere performance, quindi attenzione a interpretare bene il titolo.

- Inoltre trovo che manchino sempre le domande fondamentali da porsi su questo tema.

- Il problema è che l'output del modello generativo può violare il copyright? Oppure è anche il fatto che dati coperti da copyright vengono trattati per addestrare il modello a "comprendere" la semantica" degli input e a "scrivere" output sintatticamente corretti? Dati che comunque non vengono immagazzinati, ma sono solo utili ad affinare delle rappresentazioni vettoriali.

- E se i modelli riproducono contenuti che violano il copyright, qual è la fonte? Il New York Times di turno, o il Common Crawl di turno? Oggi non è possibile rispondere a questa domanda.

- E ancora.. infrange il copyright il modello che genera per mio conto un contenuto, o la responsabilità è mia se pubblico un contenuto creato dal mio "stagista-assistente"?

- E ancora.. non riesco a immaginare un caso d'uso professionale che mi porterebbe a usare un LLM che genera un contenuto che riproduce un articolo del NYT (è solo un esempio). Esistono utilizzi molto più utili per i quali ha senso usare questa tecnologia.

Continuo a dirlo: è fondamentale trovare risposte a queste domande e trovare linee condivise globalmente per creare, addestrare e usare questi modelli e le architetture più evolute che verranno.

Un motore di ricerca sfruttando Vertex AI

Come si può creare un motore di ricerca interno con Vertex AI Search?

È abbastanza semplice..

- Si crea un'app all'interno del pannello di Vertex AI Search.

- Si specificano gli URL sui quali effettuare la ricerca.

- Si crea una pagina web con il widget all'interno.

- Si distribuisce, localmente o pubblicamente attraverso un Cloud Storage Bucket.

Il post presenta una guida per eseguire gli step, ed è una soluzione davvero interessante.

Mixtral 8x7b su un Colab gratuito.. quanto sarebbe performante?

Ho provato a farlo, e nel video si può vedere la velocità: ho generato circa 330 token in poco più di 5 minuti.

Direi che è abbastanza lento, ma non è male per un sistema gratuito!

NOTA: nel Colab non uso le API, ma clono il modello che funziona direttamente nell'ambiente.

Il modello: https://mistral.ai/news/mixtral-of-experts/

Per fare dei test: https://github.com/dvmazur/mixtral-offloading

Mixtral 8x7b su un Colab gratuito

La discussione tra OpenAI e il Times continua

Secondo OpenAI, l'addestramento di modelli di AI utilizzando dati disponibili al pubblico nel web, inclusi articoli come quelli del Times, sarebbe "fair use".

"We view this principle as fair to creators, necessary for innovators and critical for U.S. competitiveness".

Tra quanto diventerà chiaro che non basta un tribunale per delineare la strada per il futuro di questa evoluzione tecnologica?

AI Generativa e copyright: sarà un campo minato? Certo che sì!

E tutti sapevano che prima o poi avremmo dovuto attraversarlo.

Gary Marcus e Reid Southen stanno facendo un grande lavoro di documentazione e riflessione su questa tematica.

- Il problema sollevato: i LLM sono in grado di riprodurre fedelmente contenuti protetti da copyright, anche senza prompt specifici.

- Manca trasparenza sui dati di training da parte dei brand che sviluppano i modelli.

- Si potrebbero ri-addestrare i modelli senza dati che violano il copyright, ma con quali costi?

- Si potrebbero filtrare le richieste, ma sarebbe insufficiente e impreciso.

È davvero necessario affrontare queste sfide prima possibile per poter governare al meglio questa tecnologia.

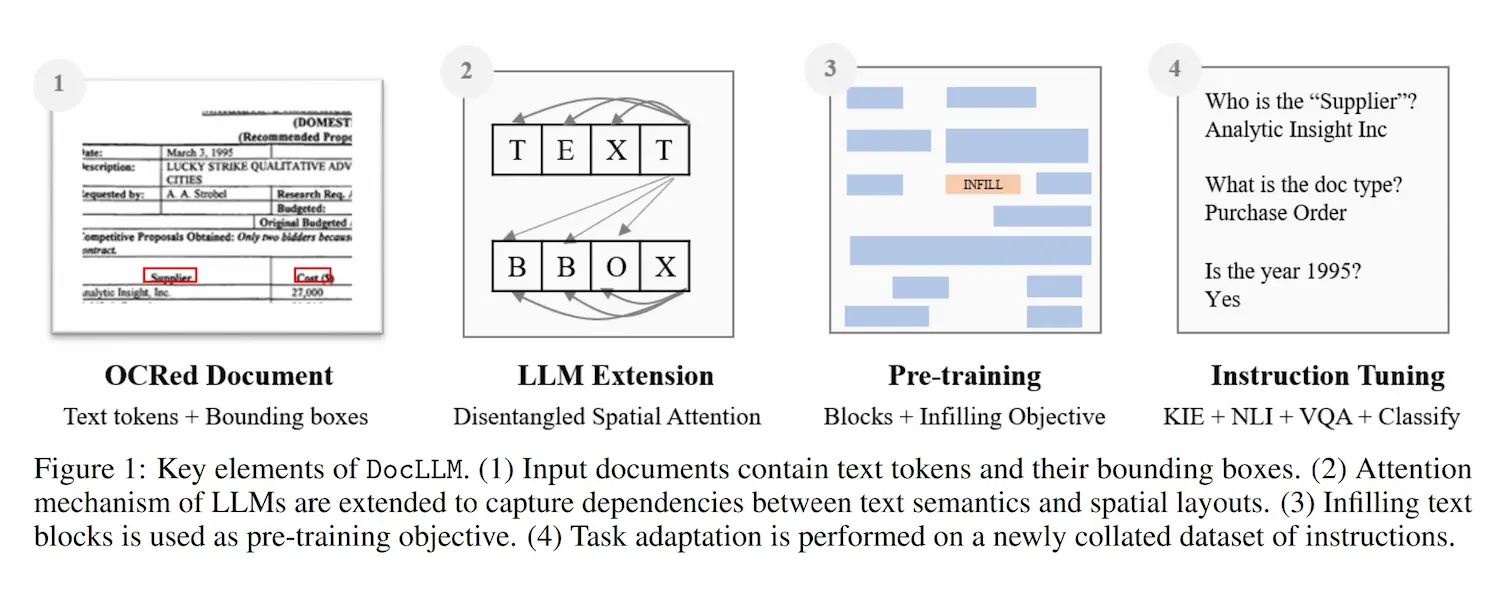

DocLLM: il modello di linguaggio di JPMorgan

JPMorgan ha lanciato DocLLM, un LLM in grado di elaborare documenti, fatture, documenti finanziari e contratti.

Il modello è in grado di elaborare sia gli elementi testuali che la disposizione spaziale nei file, consentendo due vantaggi:

- evita l'uso di costosi codificatori di immagini;

- riesce a elaborare strutture di documento eterogenee.

Le performance rilevate sono molto elevate.

Il paper: https://arxiv.org/abs/2401.00908

OpenVoice: un modello open source per la clonazione della voce

OpenVoice è il nuovo modello open source dedicato alla clonazione della voce sviluppato da MIT, Tsinghua University e MyShell.

Il processo è quasi istantaneo, con un controllo granulare del tono, dall’emozione all’accento, al ritmo, alle pause e all’intonazione. Il tutto con un piccolo clip audio in input.

Si basa su due modelli di Deep Learning complementari: un text-to-speech (TTS) e un “convertitore di tono”. Il primo è stato addestrato su 30k frasi audio, annotando ogni campione con emozioni, intonazione e ritmo. Il secondo è stato allenato su oltre 300k campioni vocali. In entrambi i casi, l’audio originale è stato scomposto in fonemi, i suoni distintivi del linguaggio, e rappresentato tramite vettori (embeddings) processabili da un algoritmo.

Il paper: https://arxiv.org/abs/2312.01479, ma il modello è già usabile su HuggingFace.

OpenVoice: un modello open source dedicato alla clonazione della voce

Ferret: il modello generativo di Apple

E anche Apple entra nella corsa frenetica dell'AI Generativa con Ferret, un modello multimodale open source presentato in sordina a ottobre.

Sì, "Apple" e "open source" nella stessa frase.. Una campagna per promuovere un'AI etica? Una tattica per ottenere un vantaggio competitivo? La consapevolezza che si tratta dell'unica via possibile? Forse la verità combina tutte queste le componenti.

Resta il fatto che si tratta di un modello potente, con approcci innovativi e con intuizioni per sfruttare un hardware meno potente.

Ci sarà un assistente virtuale all'avanguardia nel prossimo iPhone?

- Sembra avere performance elevate in ambito visivo. Superiori a Vision di OpenAI, pur essendo molto più piccolo. Come?

- Oltre a processare l'intera immagine, può concentrarsi su elementi dell'immagine stessa, in modo da conoscerne il contenuto in modo rapido ed efficiente.

- Lavora come farebbe un essere umano che guarda una foto: non processa i singoli pixel, ma riconosce determinati elementi, e grazie a questi ha subito la conoscenza del contenuto.

L'evoluzione di questi sistemi è sempre più affascinante.

Infinity: un nuovo database per sistemi RAG

Il concetto di RAG (Retrieval-Augmented Generation) mette insieme un LLM e un archivio di informazioni per ottenere estrazione ed elaborazione di dati in modo performante.

Infinity è una nuova tipologia di database progettato appositamente per questi sistemi.

Non si tratta di un database vettoriale, ma di un concetto che combina la ricerca full-text, la ricerca vettoriale (anche su più colonne) e su dati strutturati.

È estremamente veloce, e fornisce diverse interfacce (es. API Python e SQL).

Non solo i LLM si evolvono velocemente, ma anche le strutture dati per generare il contesto.

Che tipo di bolla è l'AI?

Titolo provocatorio, ma anche un saggio che tutti coloro che si occupano di Intelligenza Artificiale dovrebbero leggere.

Su diversi passaggi non sono pienamente allineato, ma fa capire quanto è importante guardare oltre, e implementare soluzioni agili, ancorate a processi solidi che vengono accelerati e ampliati grazie alla tecnologia.

La funzionalità "Realtime Gen" di Leonardo AI

Anche Leonardo AI sta lavorando al concerto di generazione di immagini in real time.

Nel video una piccola dimostrazione della nuova funzionalità denominata "Realtime Gen", che genera l'immagine mentre scrivo il prompt.

Sembra un esercizio di stile, ma pensiamo a come cambierà la UX delle piattaforme quando l'esperienza potrà cambiare in tempo reale in base ai dati degli utenti.

"Realtime Gen" di Leonardo AI

Google presenta VideoPoet: un modello generativo dedicato ai video

Google ha recentemente presentato VideoPoet, un modello in grado di generare/editare video a partire da prompt multimodali.

Questo non stupisce più, ma si tratta di un sistema non basato sulla diffusione. È una generazione video prodotta da un singolo LLM.

Una nuova tecnica che non implica componenti addestrati separatamente, e specializzati in ciascuna attività.

I sistemi migliorano, e diventano più efficienti, introducendo diversi vantaggi.

- GRAZIE -

Se hai apprezzato il contenuto, e pensi che potrebbe essere utile ad altre persone, condividilo 🙂