Generative AI: novità e riflessioni - #1 / 2025

Il panorama degli AI Agents si arricchisce. OpenAI lancia o3-mini, Operator e DeepSearch, mentre DeepSeek R1 fa scalpore online. Nvidia presenta Cosmos, Autogen si aggiorna e Google introduce Mariner, Titans e Chain-of-Agents. Test su Qwen 2.5 Max e novità per immagini e video.

Buon aggiornamento, e buone riflessioni..

I miei interventi al Search Marketing Connect

In chiusura del 2024 ho tenuto due interventi durante il Search Marketing Connect a Bologna. I seguenti video riportano i contenuti integrali.

L'evoluzione della ricerca online potenziata dall'AI: come cambiano le esperienze online?

I modelli di linguaggio (LLM) stanno cambiando la ricerca online, unendo le caratteristiche dei motori di ricerca a processi basati sull'intelligenza artificiale. Come funzionanoquesti sistemi? Come si stanno evolvendo? Verso quale direzione ci stanno conducendo? Un viaggio per capire i cambiamenti in atto e per prepararsi a essere protagonisti delle nuove esperienze di ricerca che stanno trasformando l'accesso alle informazioni.

Search Marketing Connect 2024 - Alessio Pomaro

I sistemi ibridi, che uniscono i LLM ai motori di ricerca, miglioreranno. Crescerà l'accuratezza nel determinare i contenuti rilevanti, grazie a sistemi come il "reranking". Aumenterà la qualità dell'inferenza, grazie al "reasoning" e a implementazioni multi-agent. I modelli, in generale, si evolveranno.

Capitolo 2: “reasoning” e sistemi multi-agente

L'AI generativa si è evoluta grazie all'aumento delle dimensioni dei modelli, ma oggi i maggiori progressi si stanno ottenendo grazie all'aumento della qualità dell'inferenza. Due esempi: i sistemi di "reasoning" (es. i modelli "o" di OpenAI) e i sistemi multi-agente. Facciamo chiarezza su questo cambiamento, con esempi pratici di applicazioni.

Search Marketing Connect 2024 - Alessio Pomaro

I workflow basati sugli AI Agent rappresenteranno un enorme progresso per le applicazioni basate sull'AI. Forse più della prossima generazione di modelli.

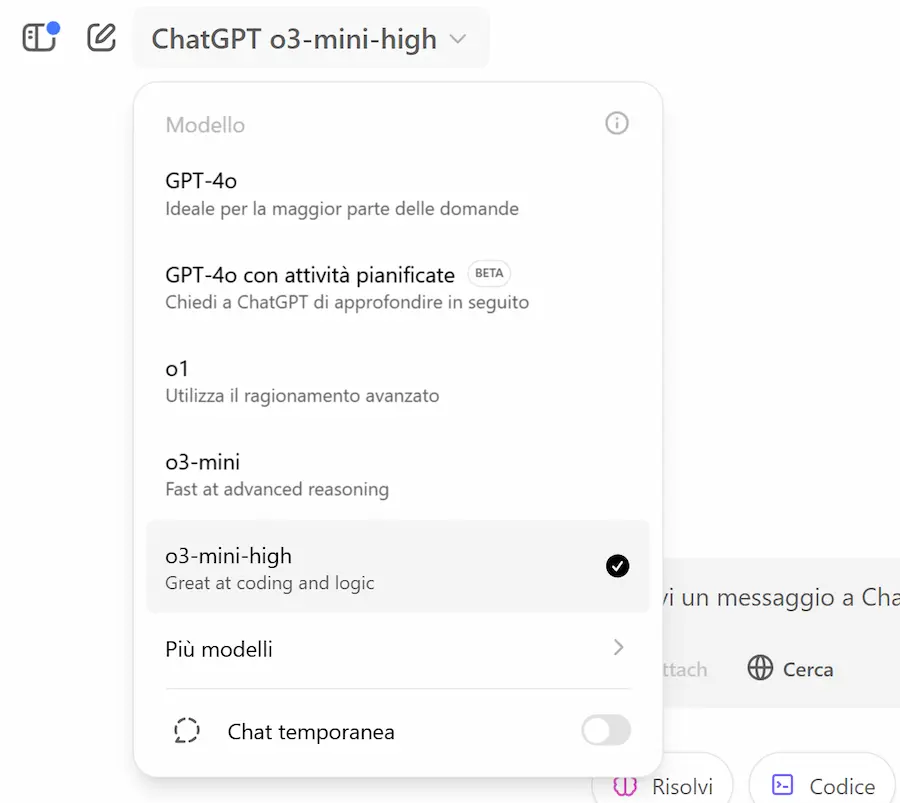

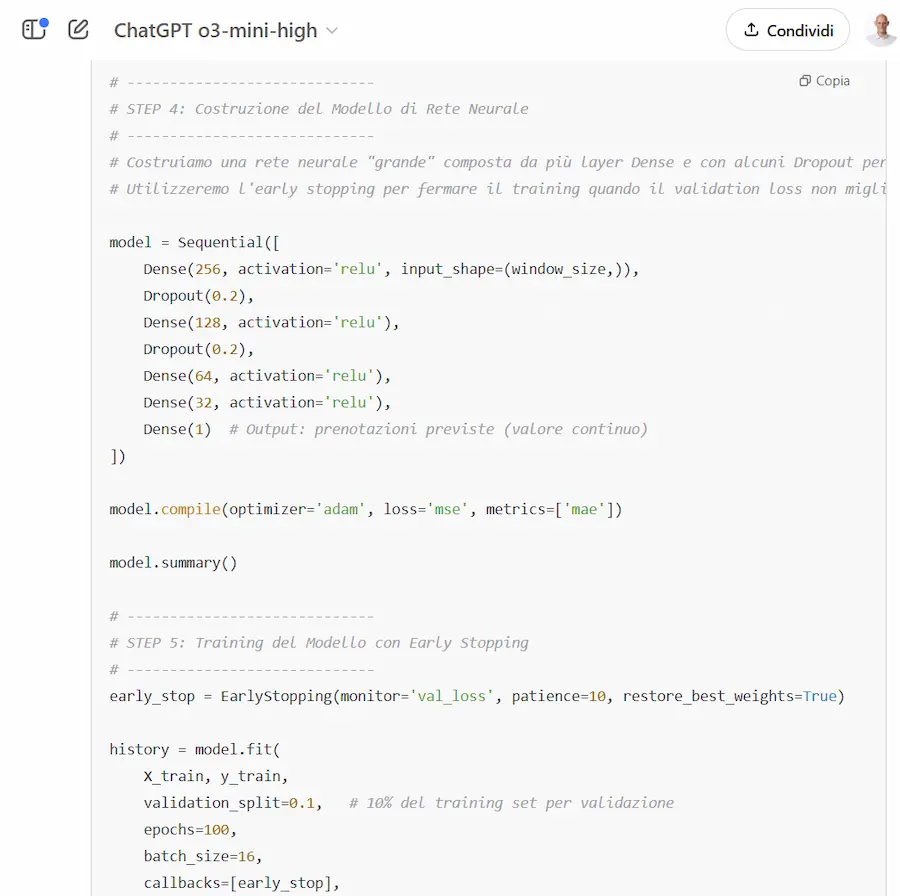

o3-mini di OpenAI

o3-mini è stato rilasciato, e disponibile su ChatGPT e via API.

Prezzo? 4,40$/1M token (o1 costa 60$/1M token, DeepSeek costa 2,19$/1M token).

- Più veloce e preciso, con efficienza paragonabile a o1.

- Reasoning effort regolabile.

- Supporta function calling e output strutturati.

- Disponibile anche per gli utenti "free", usando l'opzione "Reason" (effetto DeepSeek R1?).

- Supera o1-mini in matematica e coding, con miglioramenti significativi in diversi benchmark.

- Più veloce del 24% rispetto a o1-mini.

L'ho provato su diversi task, su logica e coding.

Un test di o3 di OpenAI

È chiaramente una soluzione molto interessante.

Gli agenti di OpenAI

OpenAI, sta arricchendo ChatGPT con una serie di agenti che estendono le potenzialità del sistema. Gli agenti rappresentano lo sviluppo del layer di integrazione: strumenti basati su LLM che eseguono autonomamente operazioni specifiche.

Lo step successivo sarà la possibilità di creare dei workflow multi agente? Un framework più avanzato per sviluppare agenti personalizzati?

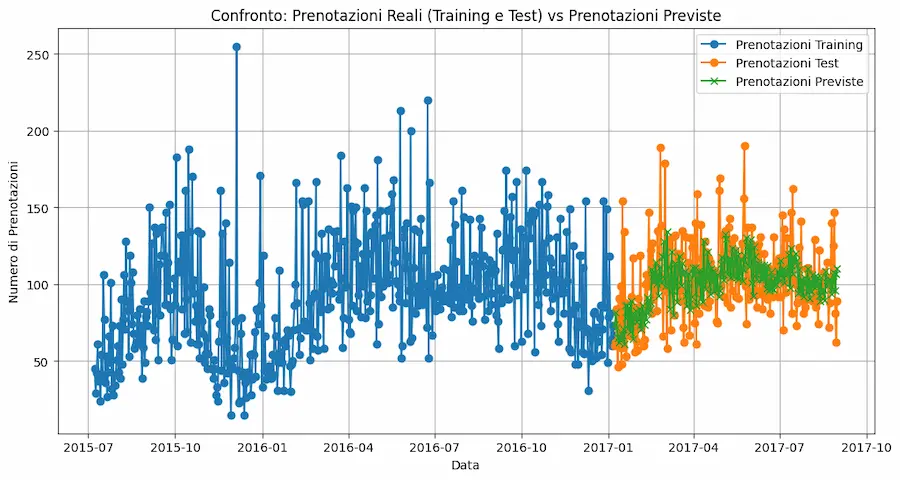

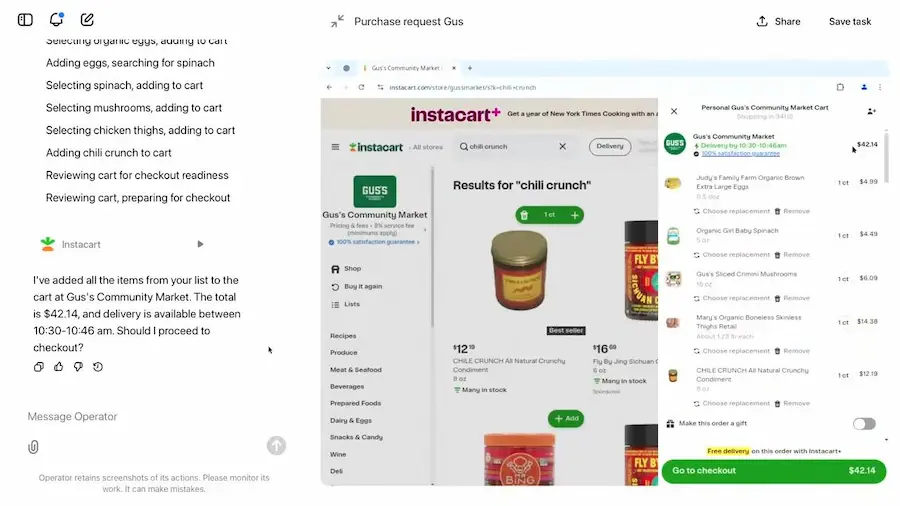

Operator

OpenAI ha presentato il progetto Operator, un AI Agent in grado di utilizzare un browser web autonomamente per svolgere compiti complessi. Sfruttando il modello Computer-Using Agent (CUA), basato su GPT-4o, Operator rappresenta una delle prime implementazioni di agenti AI capaci di interagire con interfacce grafiche proprio come farebbe un essere umano.

Un esempio di interazione con Operator

Operator è progettato per eseguire attività quotidiane in modo indipendente, offrendo un’esperienza intuitiva e versatile. Ad esempio, può prenotare ristoranti in piattaforme come OpenTable, fare la spesa online su siti come Instacart, anche interpretando liste scritte a mano, prenotare biglietti per eventi, ecc..

Garantisce il pieno controllo agli utenti con conferme esplicite, modalità takeover per interventi su dati sensibili (es. login o pagamenti), protezioni avanzate contro siti malevoli e comportamenti sospetti.

Raggiunge risultati promettenti in benchmark come WebArena e OSWorld, ma è in continuo miglioramento per gestire flussi di lavoro più complessi e situazioni impreviste.

Per ora, è disponibile solo negli USA e con account Pro.

Questo progetto rappresenta un passo verso agenti autonomi sempre più avanzati, che semplificheranno processi quotidiani e trasformeranno il nostro rapporto con la tecnologia.

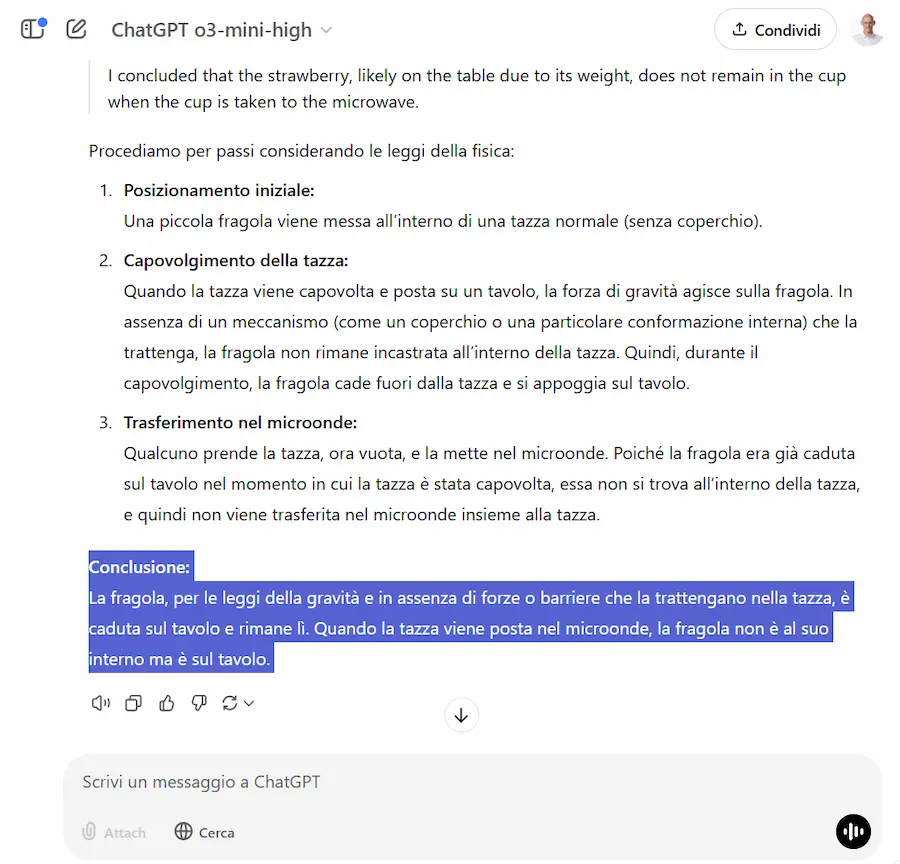

Deep Research

Dopo Operator, viene introdotto Deep Research: un nuovo agente che unisce il "reasoning" alla ricerca.

Un sistema in grado di effettuare ricerche online approfondite e multi step sintetizzando i contenuti e ragionando autonomamente su di essi.

Crea un piano d'azione, l'utente può confermarlo o modificarlo, e procede estraendo le fonti ed elaborandole.

Non ha limiti di latenza, quindi può impiegare anche 30 minuti per fornire risposte di qualità superiore.

Deep Research di OpenAI

In pratica, funziona come l'omonimo agente in casa Google (Gemini 1.5 Pro with Deep Research): secondo me, quello più utile e interessante.

Inizialmente sarà solo per utenti Pro.

La natura e la direzione del concetto di AI Agent

Il keynote di Jensen Huang al CES, scremato dai vari "effetti wow", traccia una traiettoria che permette di capire meglio la natura e la direzione del concetto di AI Agent.

Un concetto di cui si parla ovunque, ma che non credo sia compreso completamente.

Credo che il passaggio che descrive il CEO di Nvidia, tra AI Agentica e AI Fisica sia utile a comprendere meglio il potenziale in gioco. Sì, perché fa capire che..

la differenza tra l'interazione di più agenti per scrivere l'articolo di un blog o un blocco di codice, e l'interazione tra robot per gestire un magazzino è solo negli obiettivi, nelle istruzioni e negli attuatori (o tool, o skill) a disposizione dagli agenti stessi.

Forse, con questi esempi, diventano anche più chiari i timori di cui ha parlato spesso Geoffrey Hinton dicendo: una volta che verrà dato un obiettivo a un sistema autonomo, quanto saranno controllabili le azioni intermedie che compirà per raggiungerlo?

Il keynote di Jensen Huang al CES

Torniamo sempre allo stesso concetto: più aumenta il potenziale di una tecnologia, più gli attuatori che colleghiamo ad essa diventano potenti, e più diventa urgente un controllo, una regolamentazione e un lavoro cooperativo a livello globale per gestirne l'utilizzo e l'impatto.

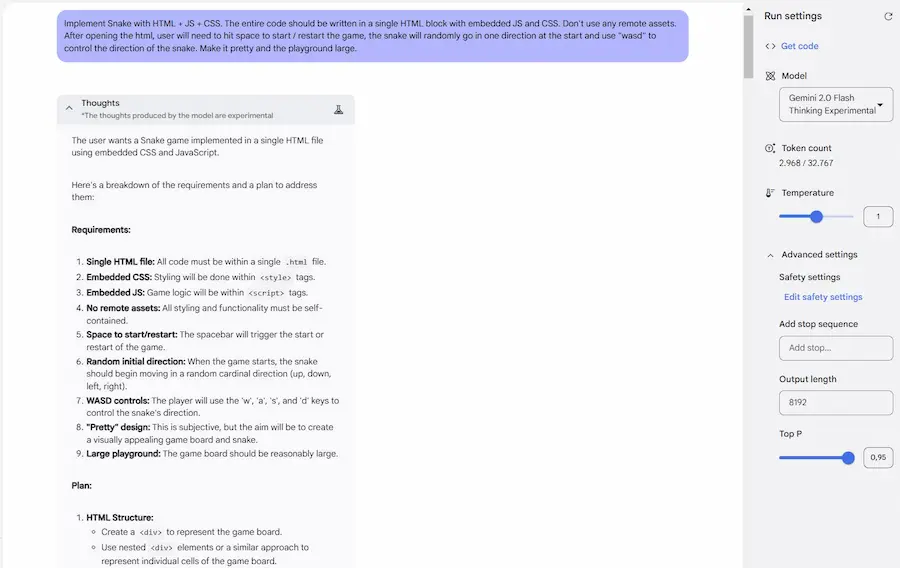

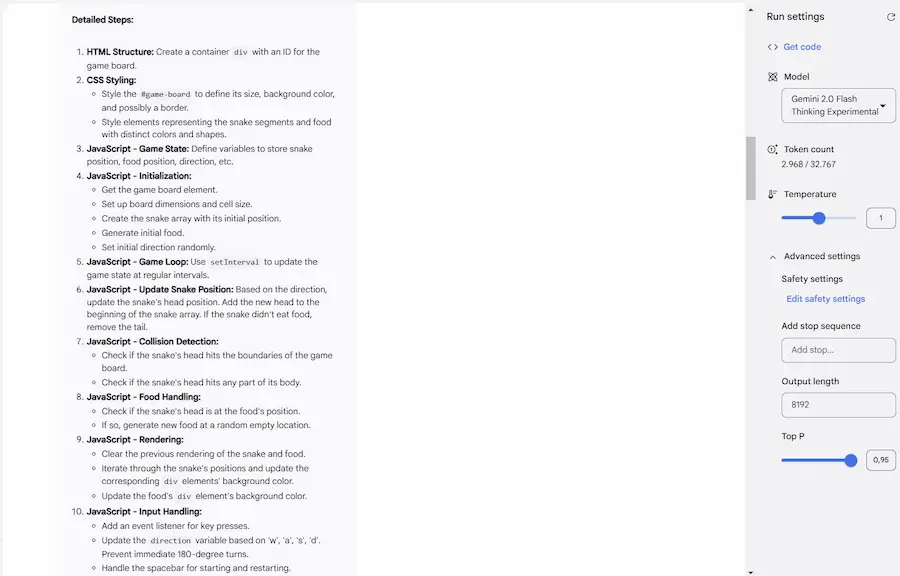

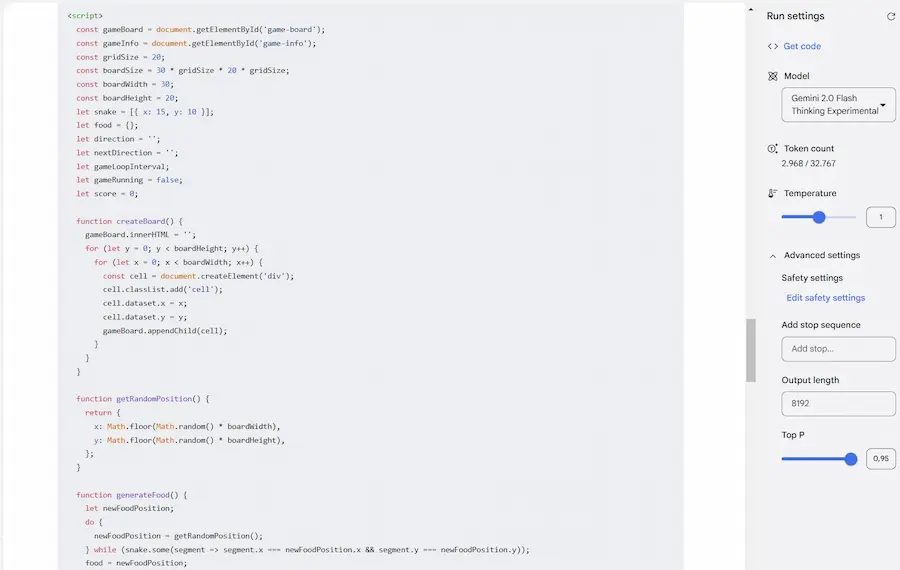

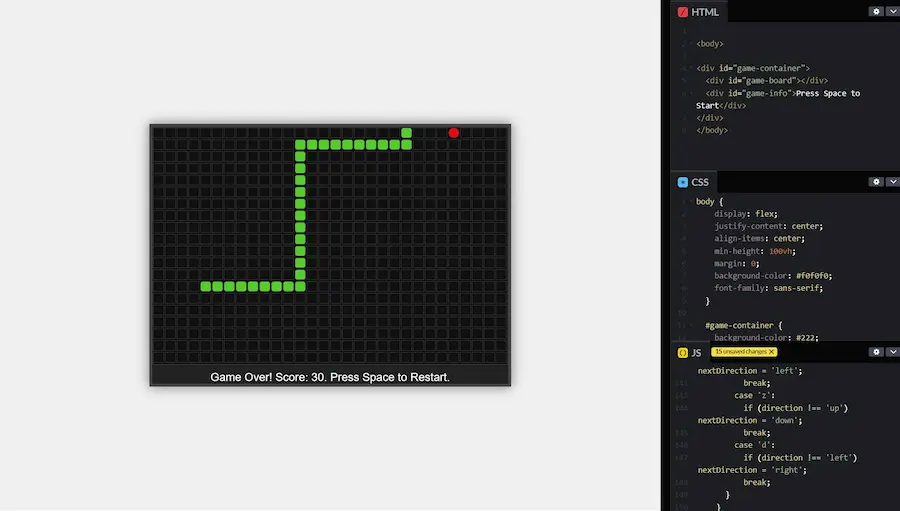

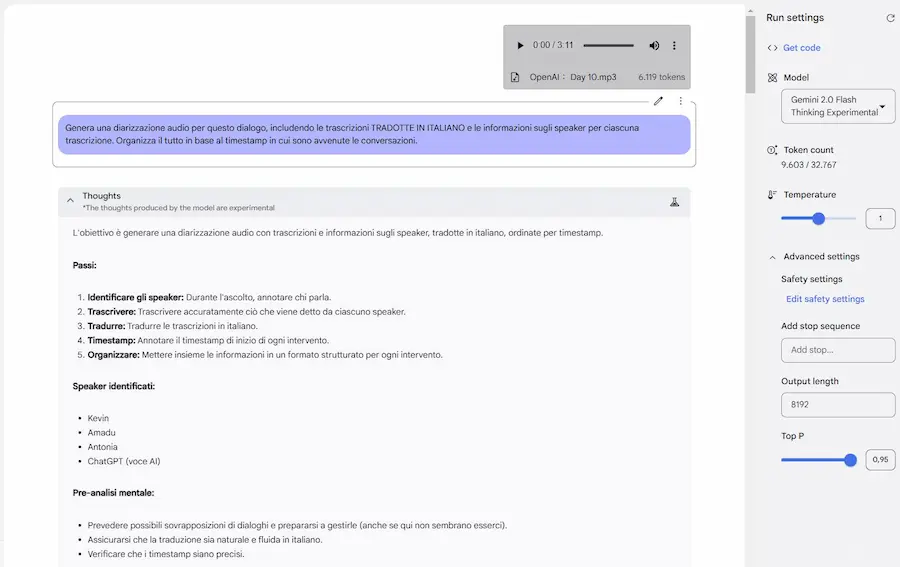

Gemini 2.0 Flash Thinking

Alcuni esempi del modello di "reasoning" di Google: Gemini 2.0 Flash Thinking. Sono rimasto colpito dal potenziale.. e non a caso, nel momento in cui sto scrivendo questo contenuto è al primo posto della Chatbot Arena LLM Leaderboard.

Un test di Google Gemini 2.0 Flash Thinking

L'ho provato su un task di coding e uno multimodale, in cui il sistema elabora un file MP3 di un dialogo, trascrivendolo con la suddivisione degli speaker.

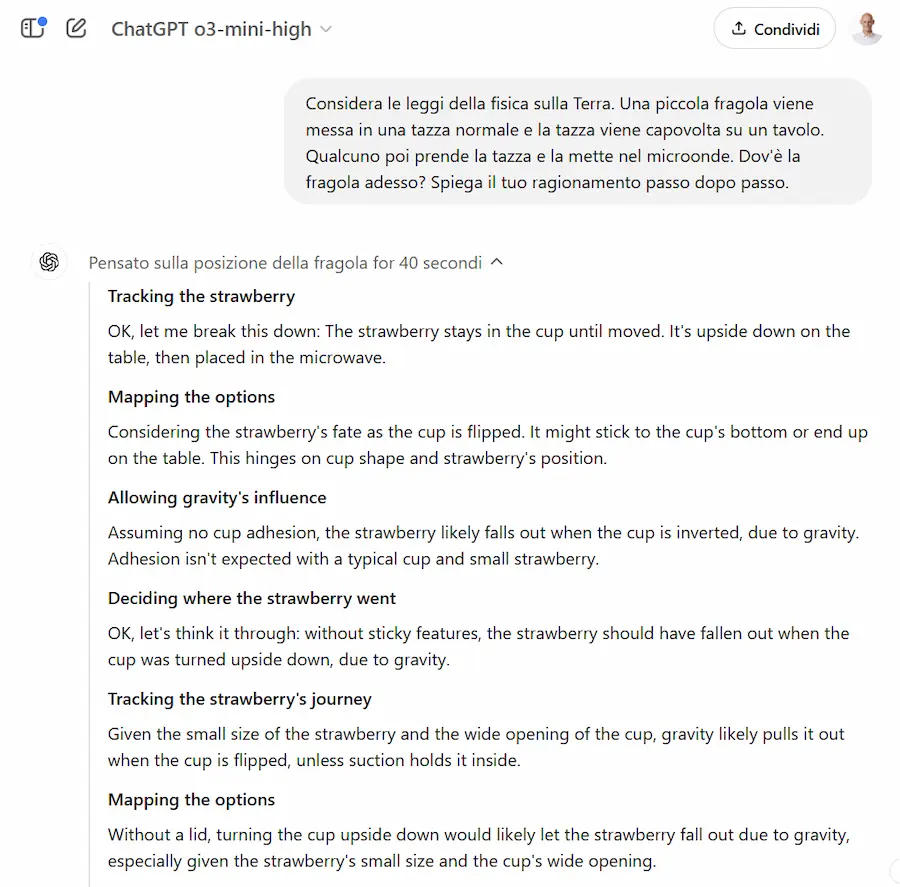

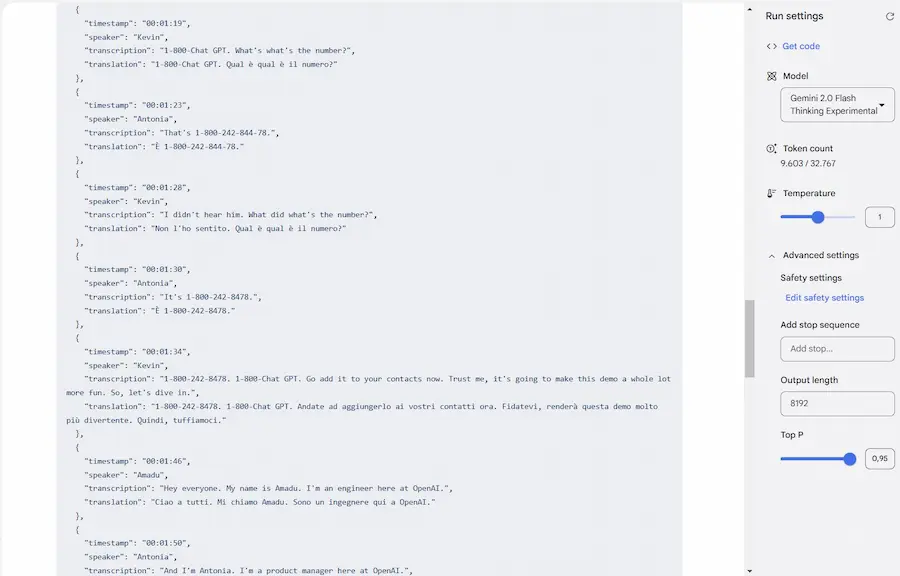

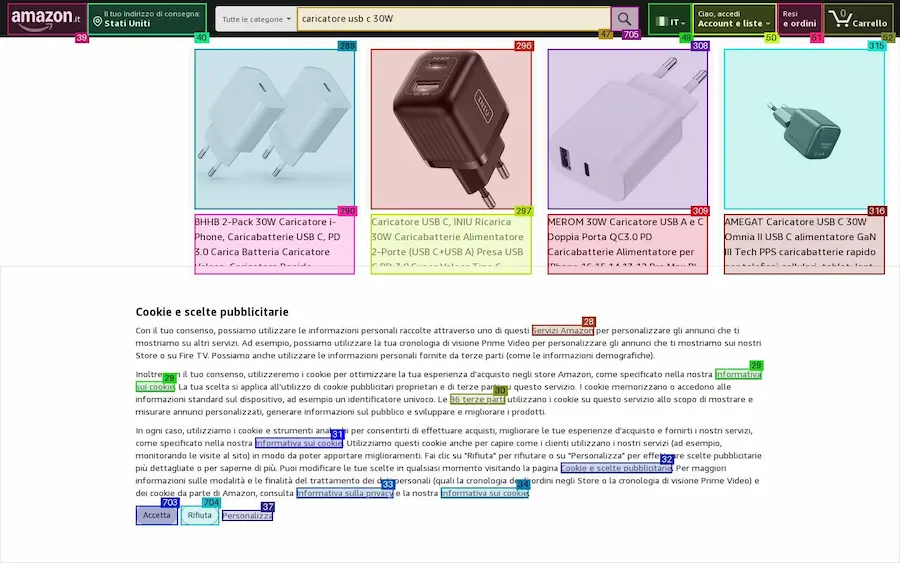

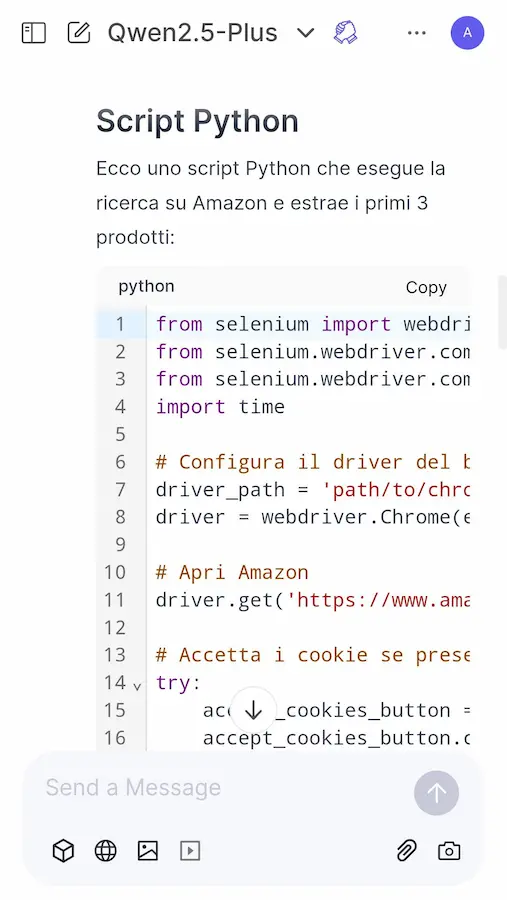

DeepSeek R1: navigazione web + reasoning

DeepSeek R1 permette un'azione che mi ha davvero stupito, non realizzabile con o1 di OpenAI: unisce la ricerca online al "reasoning".

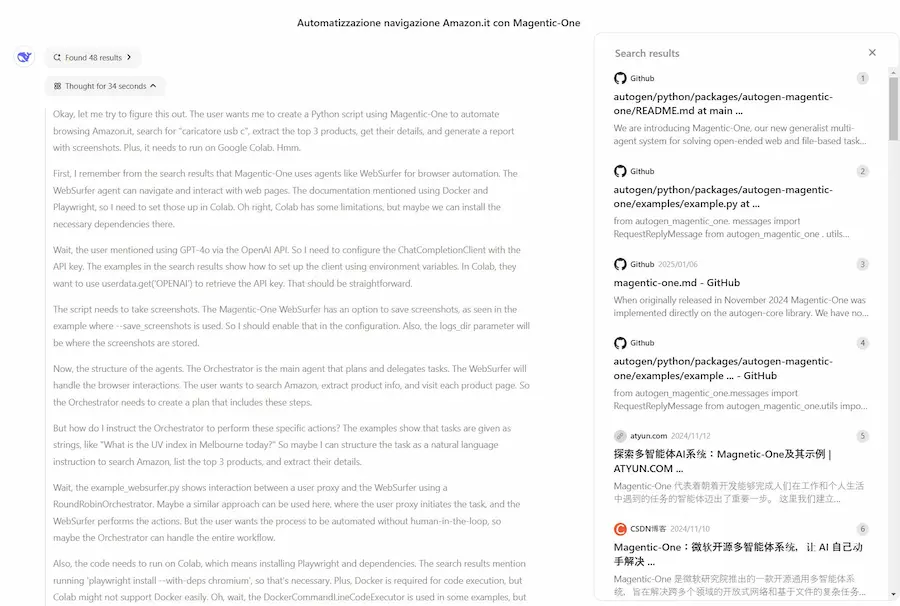

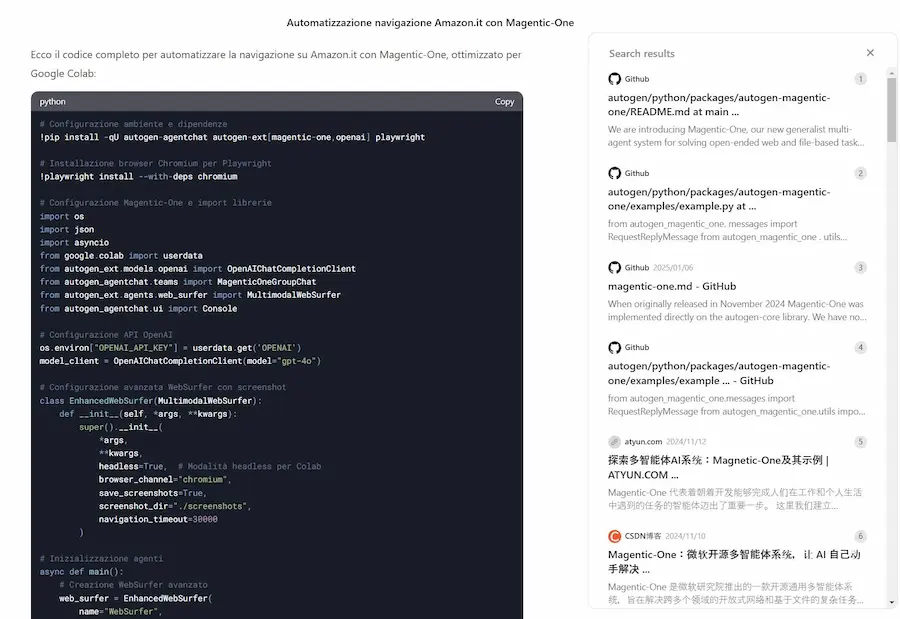

Nel prompt dell'esempio, chiedo al modello di cercare online la documentazione di Magentic-One (un AI agent per l'automazione del browser), e di implementare un sistema che cerca su Amazon un prodotto e genera un report, mostrandomi anche gli screenshot di navigazione.

DeepSeek diventa un modello di "reasoning" evoluto, in grado di "documentarsi" online per sviluppare.

Nelle immagini si vede anche l'esecuzione del codice su Colab, con il risultato e gli screenshot.

DeepSeek R1: navigazione web + reasoning

Le fasi di prototipazione e di ottimizzazione possono avere degli interessati benefici.

DeepSeek R1 in locale, sul mio laptop

Ho provato DeepSeek R1 in locale, sul mio laptop.

La versione è la 8B, basata su architettura LLaMA, con quantizzazione a 4 bit (Q4_K_M).

I task di test sono semplici (classificazione e sintesi), ma, pur essendo quantizzato a 4 bit la qualità è sorprendente.

La velocità non è grandiosa, ma con l'hardware che ho usato è tutto come da aspettative. Però è chiaro che, con l'aumento della qualità dei modelli open source, con un discreto supporto di GPU (che consente di usare LLM più grandi e quantizzazioni meno severe), e magari con architetture basate su sistemi multi-agente, ormai si possono ottenere ottimi risultati in locale.

DeepSeek R1 in locale, sul mio laptop

Questo tipo di sperimentazione, inoltre, fa ragionare meglio sulla potenza dei modelli che usiamo in base ai task da compiere. Queste ottimizzazioni, in ottica di applicazioni multi agente, possono migliorare le infrastruttura e ridurre i costi.

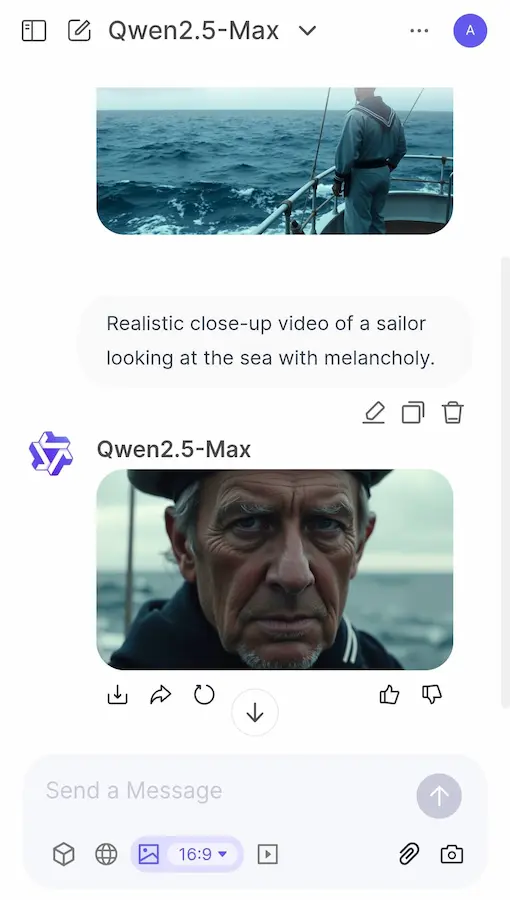

Qwen 2.5 Max

Siamo in un momento in cui i modelli della stessa classe hanno prestazioni sempre più simili. Anche il prezzo per token generale, secondo me, tenderà a ridursi drasticamente (a zero). Il tutto renderà i LLM delle vere e proprie commodity, e ciò che farà davvero la differenza sarà l'integrazione e l'architettura che li saprà sfruttare meglio.

Durante il "frastuono" DeepSeek, infatti, Alibaba ha rilasciato diversi modelli, tra cui Qwen 2.5 Max.

È basato su Mixture-of-Experts (MoE), addestrato su oltre 20 trilioni di token e perfezionato con tecniche avanzate come Supervised Fine-Tuning (SFT) e Reinforcement Learning from Human Feedback (RLHF).

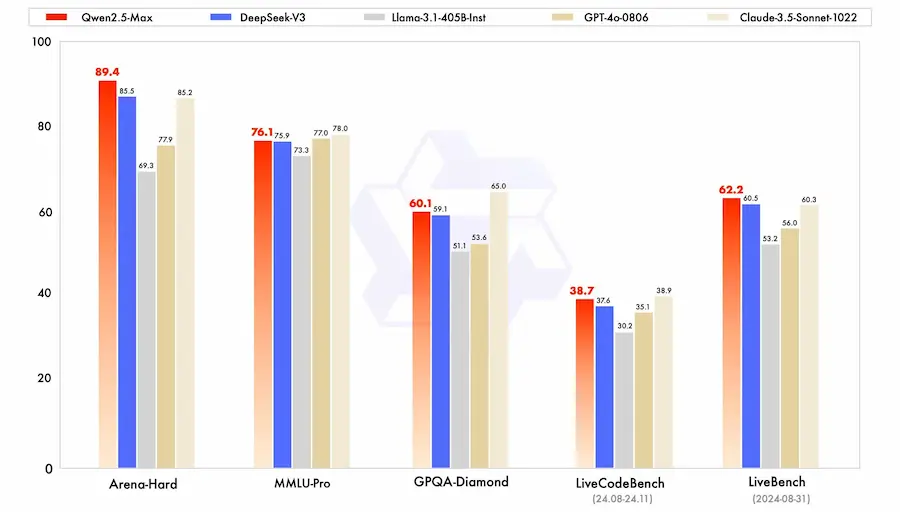

L'ho provato in diversi task, ed è indubbiamente evoluto. Dai dati, batte diversi modelli in diversi benchmark, tra cui DeepSeek V3.

Alcuni test di Qwen 2.5 Max

L'integrazione? Ormai le chiamate API sono intercambiabili: basta cambiare un parametro per provare qualunque modello.

Il progetto Mariner di Google

Il progetto Mariner di Google è un esempio di unione tra i concetti di AI Agent, multimodalità, e reasoning.

Si tratta di un sistema agentico basato su Gemini 2.0 in grado di automatizzare processi nel browser interagendo con l'utente.

Il progetto Mariner di Google

Per ogni task crea un piano attraverso catene di ragionamento, descrive le operazioni e le esegue.

Nella demo viene specificato che non lavora in background, per sottolineare il concetto di "human in the loop" e di "co-working".

Tuttavia, è possibile realizzare sistemi simili completamente autonomi e automatizzati, con framework come Autogen e tool che eseguono la navigazione attraverso il browser.

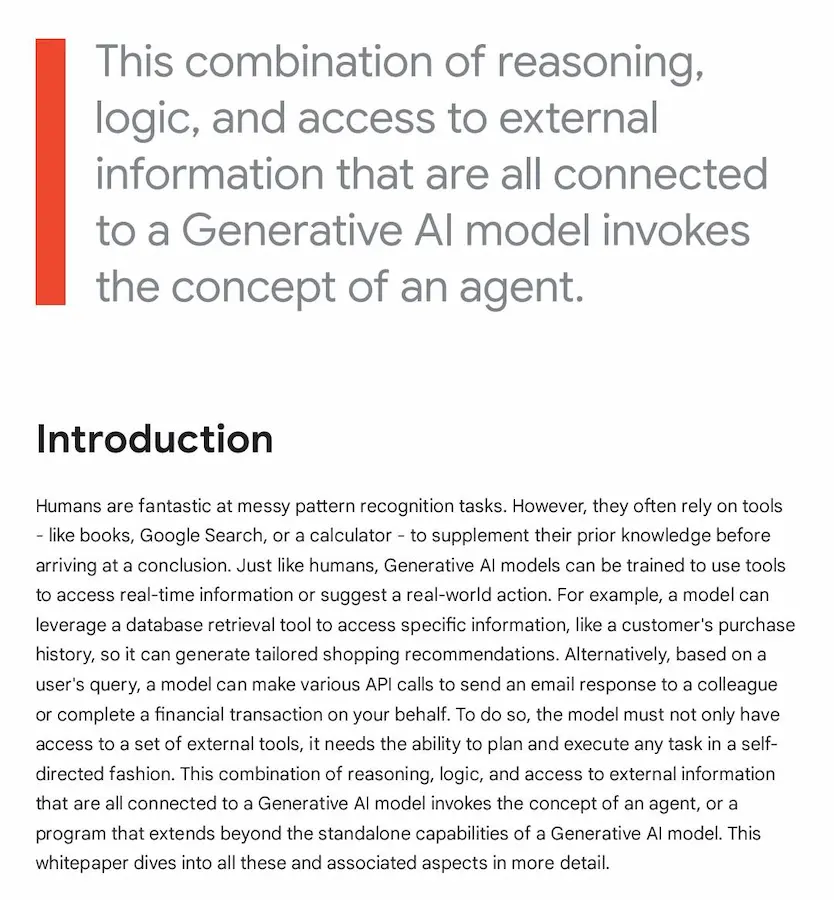

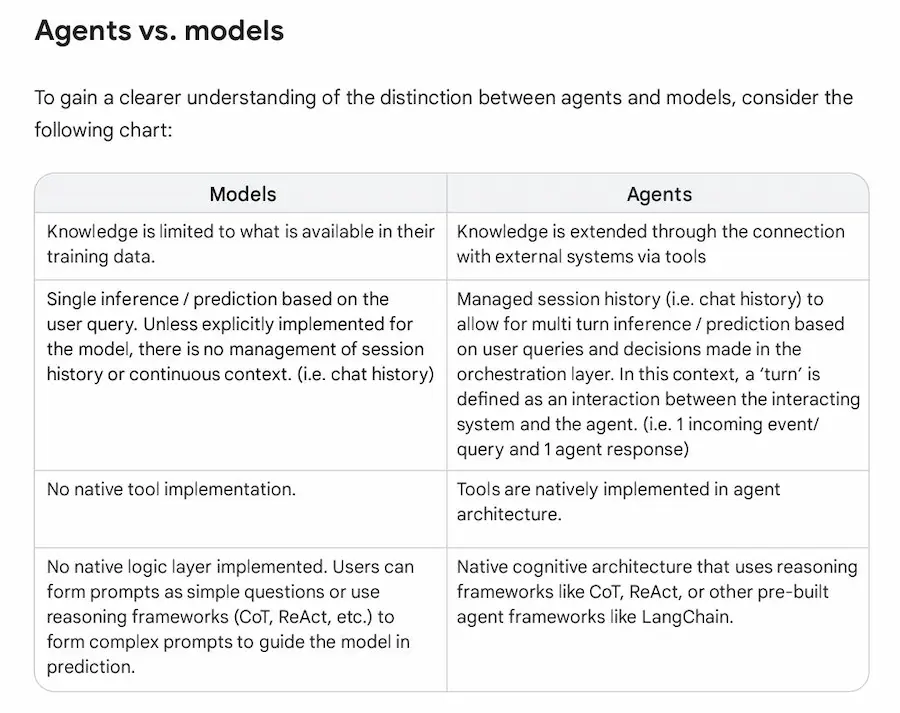

Agents: un paper di Google dedicato ai sistemi agentici

Google ha pubblicato un paper sullo sviluppo di sistemi basati su AI Agent.

Gli agenti rappresentano un passo avanti per l'intelligenza artificiale generativa, permettendo ai LLM di andare oltre la semplice elaborazione del linguaggio.

Grazie a strumenti come API Extensions, Data Stores e framework di ragionamento avanzati (es. ReAct, Chain-of-Thought), gli AI Agent possono interagire con il mondo reale, prendere decisioni autonome e completare task complessi.

Agents: un paper di Google dedicato ai sistemi agentici

Punti chiave

- Autonomia. Gli agenti combinano ragionamento, logica e accesso a dati esterni per eseguire azioni in modo indipendente.

- Strumenti avanzati. L'uso di Extensions e Data Stores li rende capaci di accedere a informazioni in tempo reale e integrarsi in sistemi esistenti.

- Applicazioni. Dallo sviluppo di tool con LangChain alla gestione end-to-end tramite Vertex AI, le opportunità sono immense.

Il futuro? L’adozione di architetture collaborative, come il “mixture of agent experts”, promette di affrontare con successo problemi complessi, offrendo soluzioni sempre più scalabili e innovative.

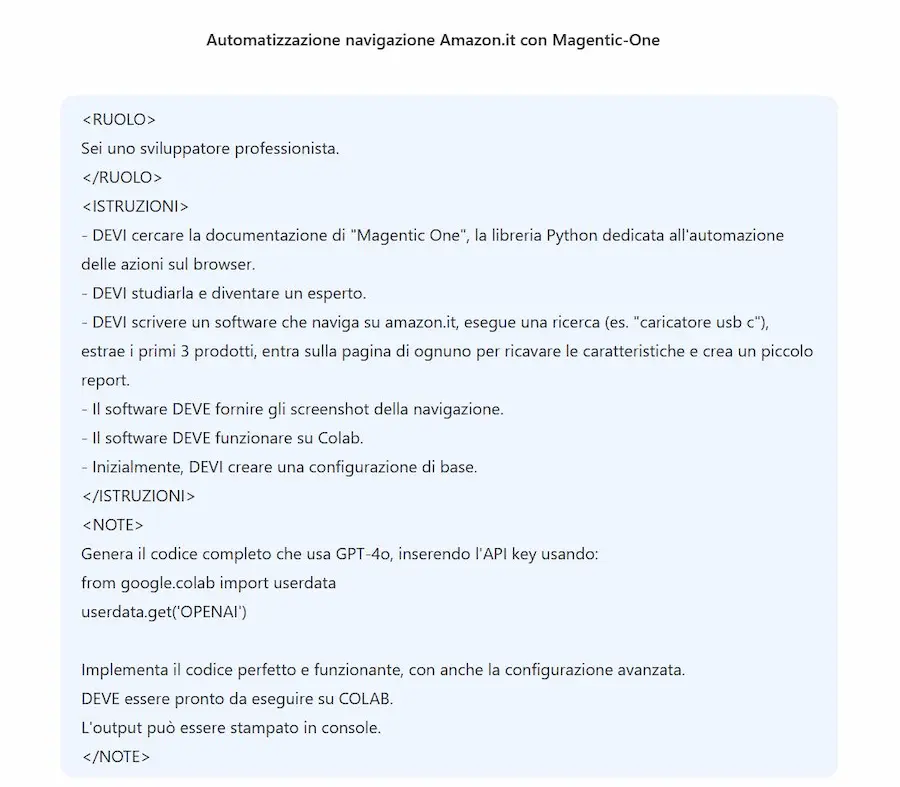

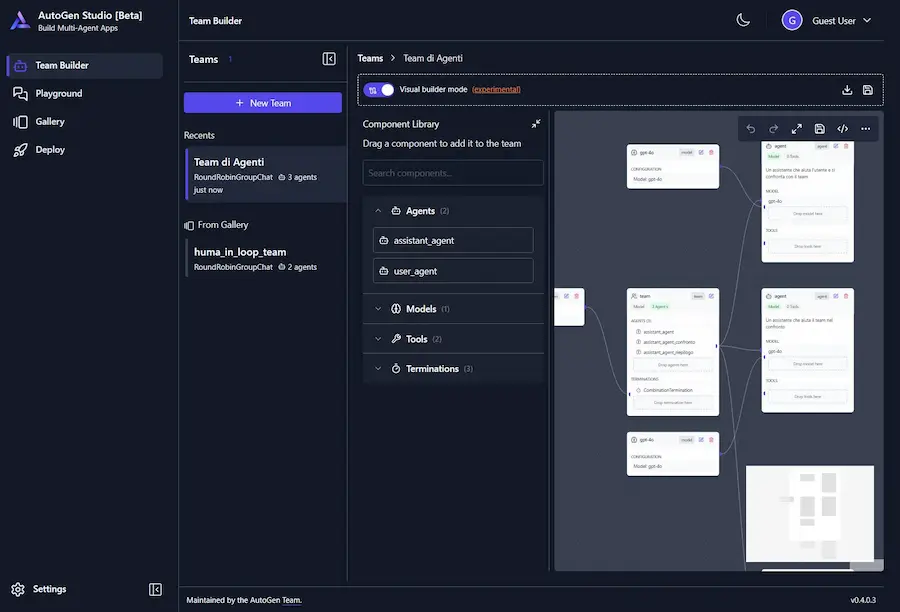

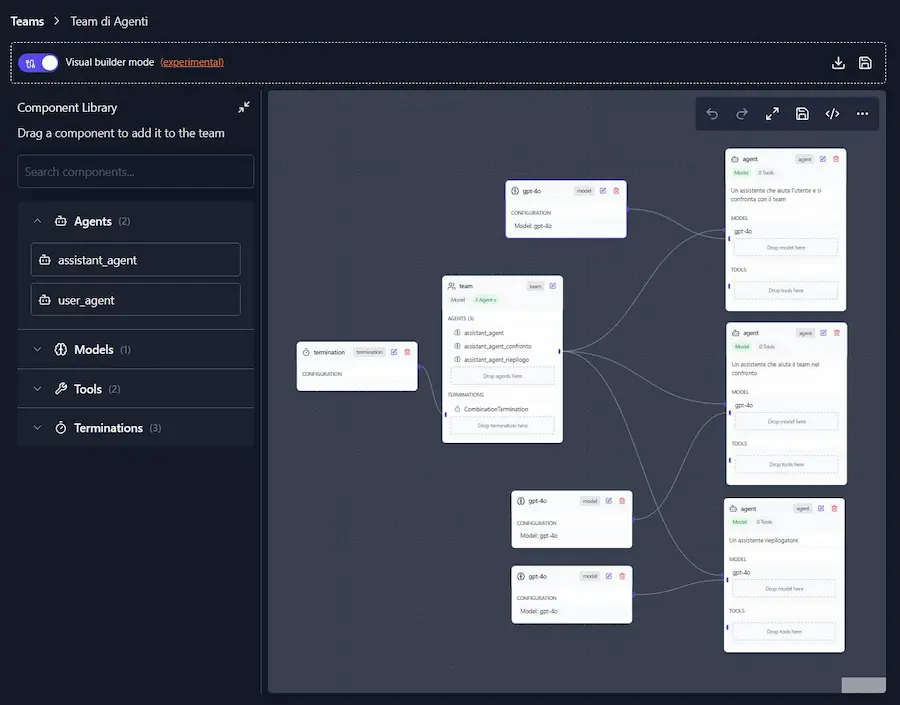

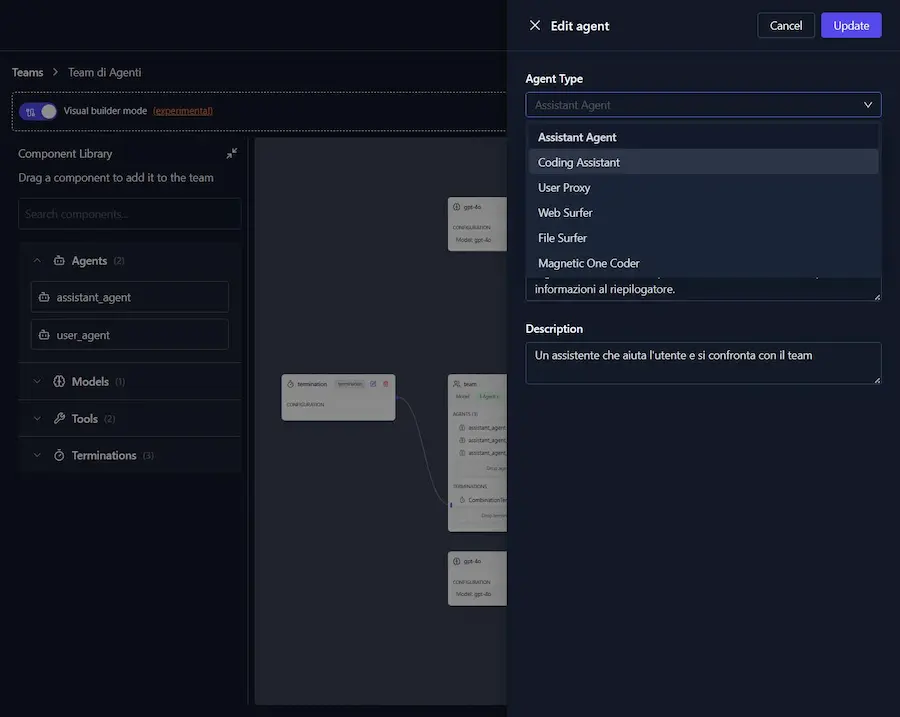

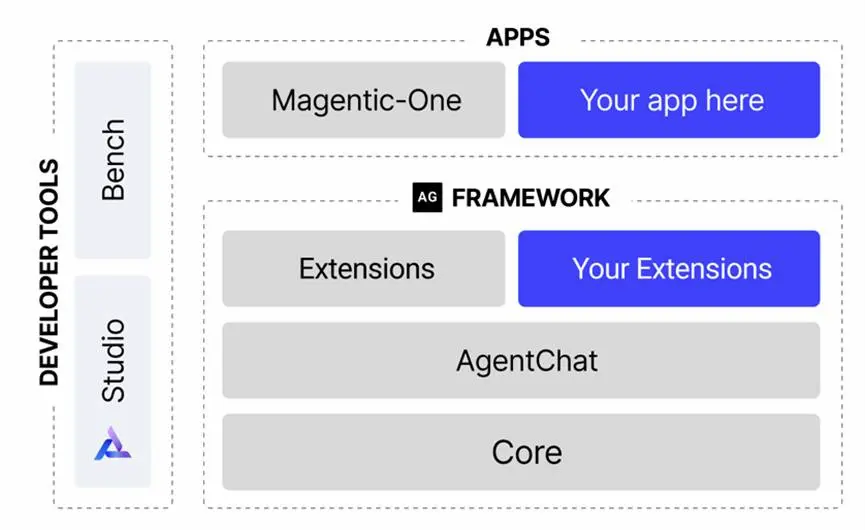

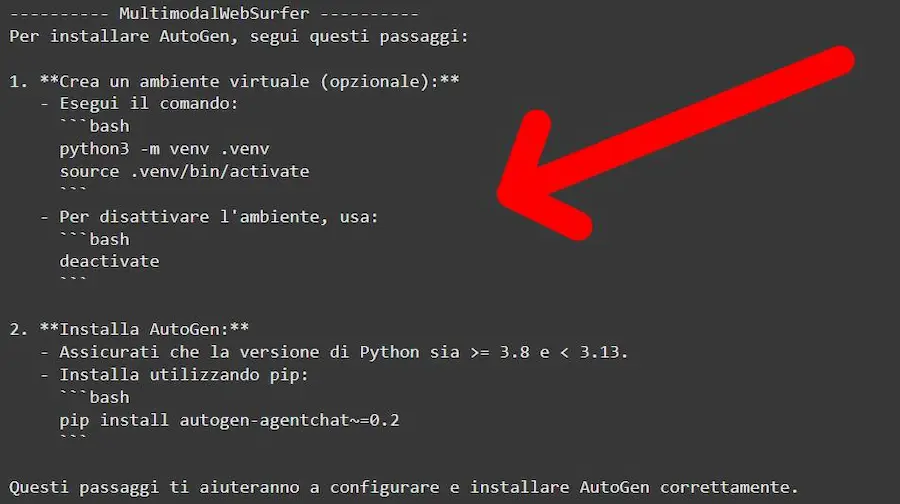

La nuova versione di Autogen di Microsoft

Microsoft rilascia la versione 0.4 "stable" di Autogen (il noto framework per applicazioni multi-agent), e il nuovo Autogen Studio.

L'aggiornamento migliora scalabilità, robustezza e flessibilità, affrontando le limitazioni delle versioni precedenti grazie a un'architettura asincrona e basata su eventi.

Le novità

1️. Scambi asincroni. Supporta interazioni dinamiche e scalabili tra AI Agent.

2️. Modularità. Gli utenti possono personalizzare agenti, strumenti, memoria e modelli, rendendo il sistema adattabile.

3️. Osservabilità e debugging. Metriche integrate, tracciabilità e supporto OpenTelemetry per monitorare e controllare i flussi di lavoro.

4️. Supporto multi linguaggio. Interoperabilità tra agenti scritti in Python, .NET (e presto altri).

5️. Strumenti migliorati. AutoGen Bench per il benchmarking delle performance degli agenti, e AutoGen Studio, un'interfaccia low-code per prototipare agenti AI, con funzioni come controllo in tempo reale e visualizzazione dei messaggi. Nelle immagini, si può vedere proprio un sistema che ho realizzato con questo sistema.

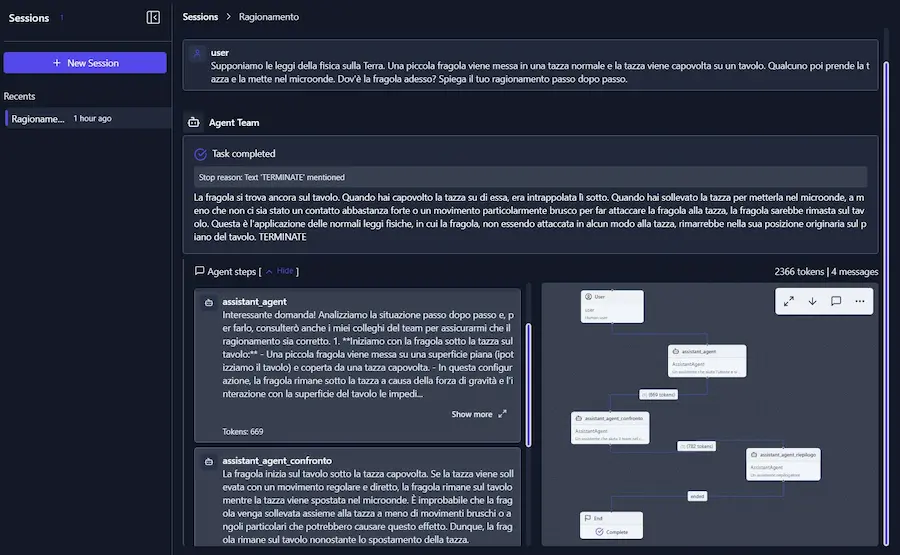

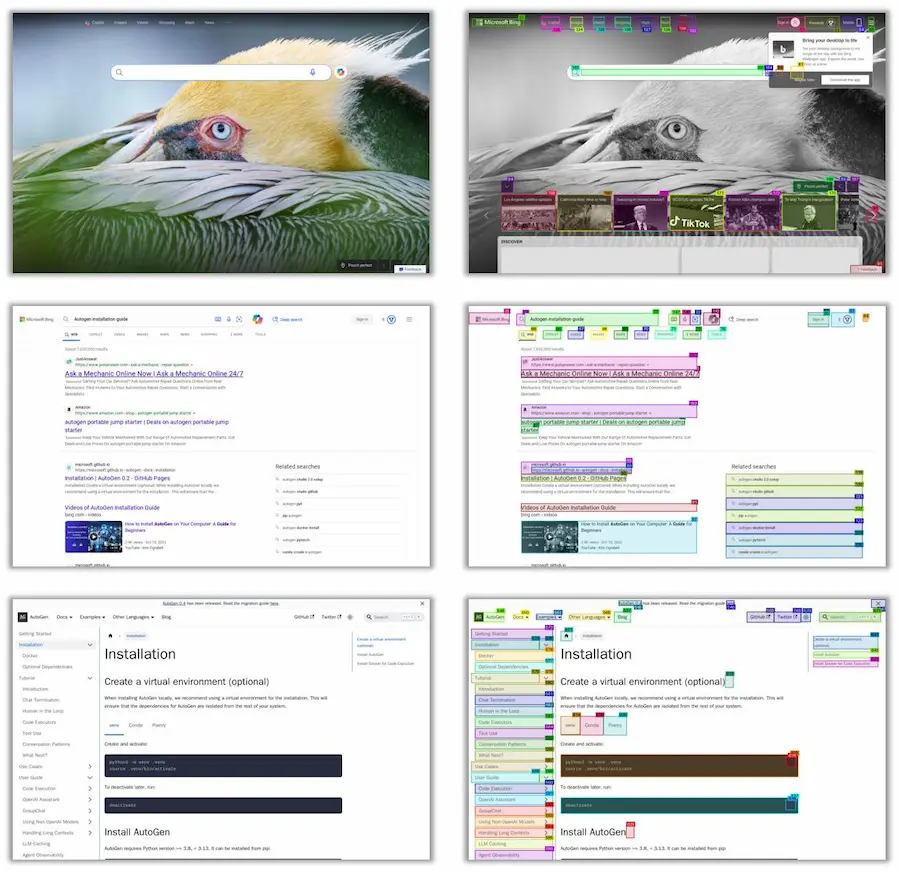

Esempi di utilizzo di Autogen Studio e Magentic-One

Tra le applicazioni, è disponibile Magentic-One, che permette dei flussi multi-agent già impostati per coding, ricerca web e ricerca tra i file. Nelle immagini è possibile vederne un'esecuzione dalla console Python: il sistema fa una ricerca online per eseguire il mio task.

Lo sviluppo di architetture multi-agent migliora, e migliorano le potenzialità e le performance delle applicazioni. Autogen Studio lo trovo ancora troppo acerbo, ma l'inizio è notevole.

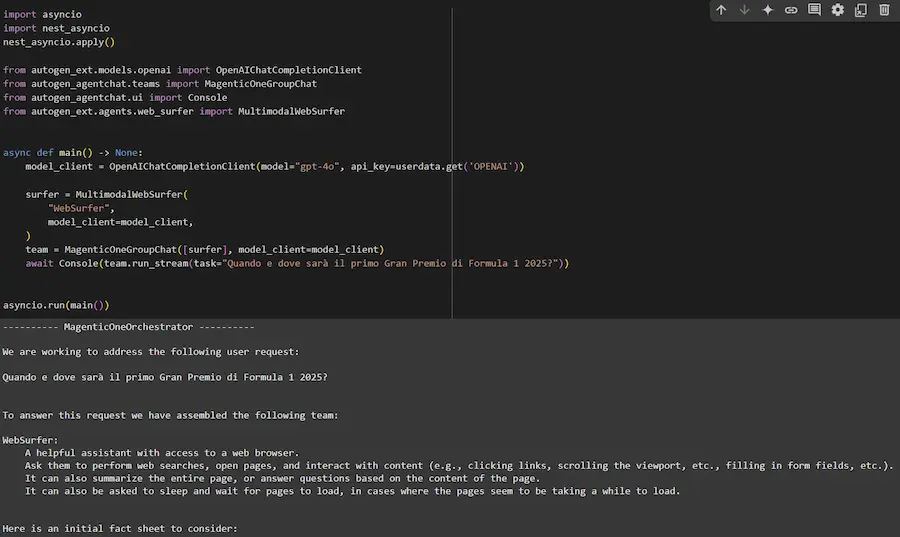

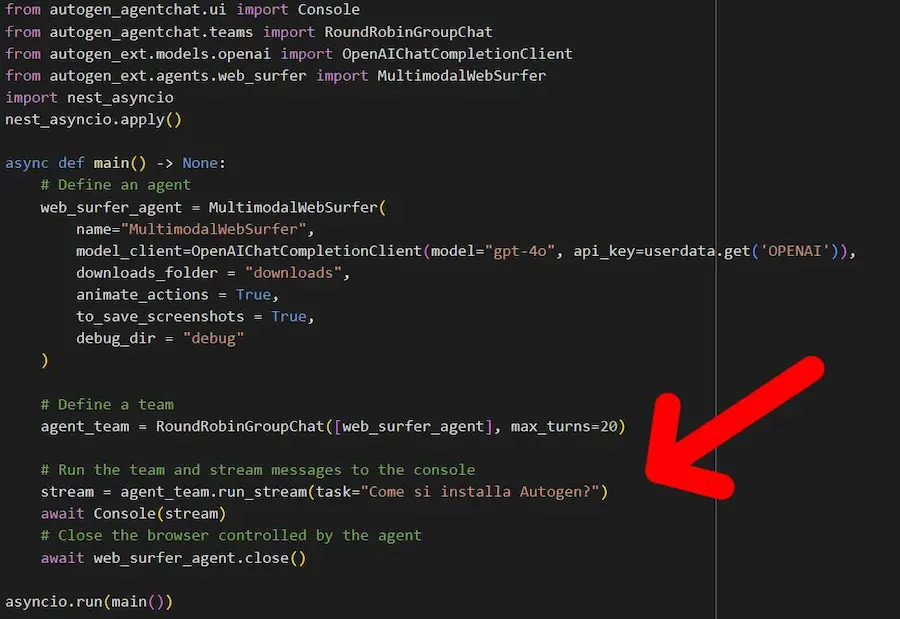

Un test di Magentic-One

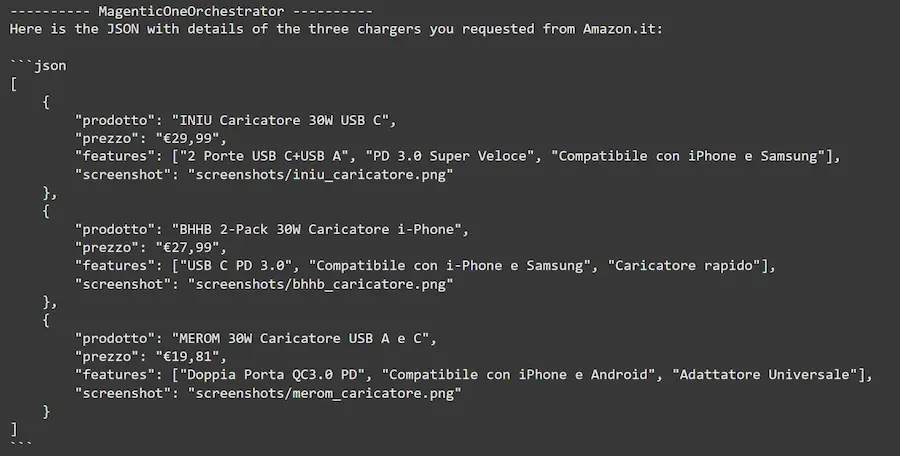

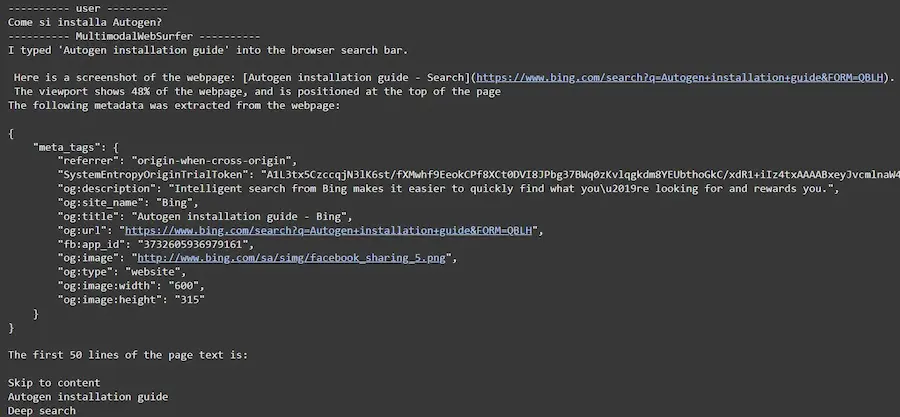

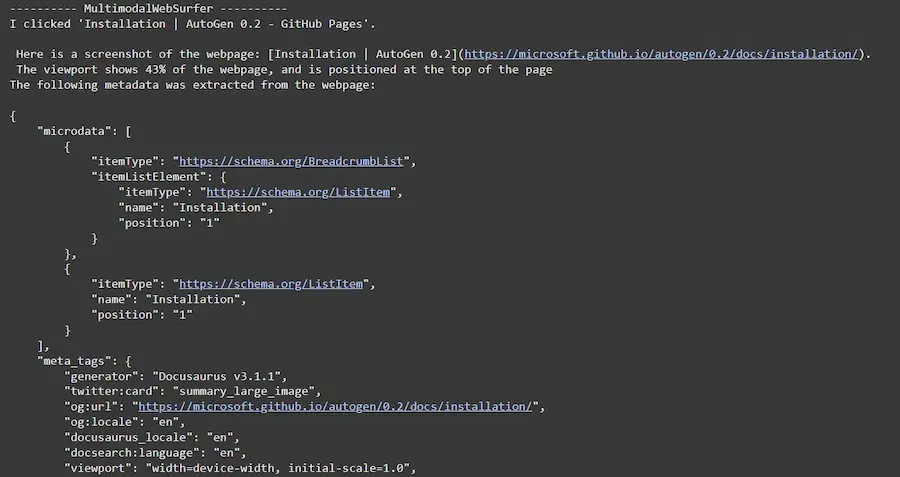

In questo test basato su Magentic-One, ho usato il componente MultimodalWebSurfer.

Un test di Magentic-One

Naviga online per eseguire una richiesta, mostrando anche gli screenshot delle pagine che processa. Infine completa il task rispondendo alla mia domanda.

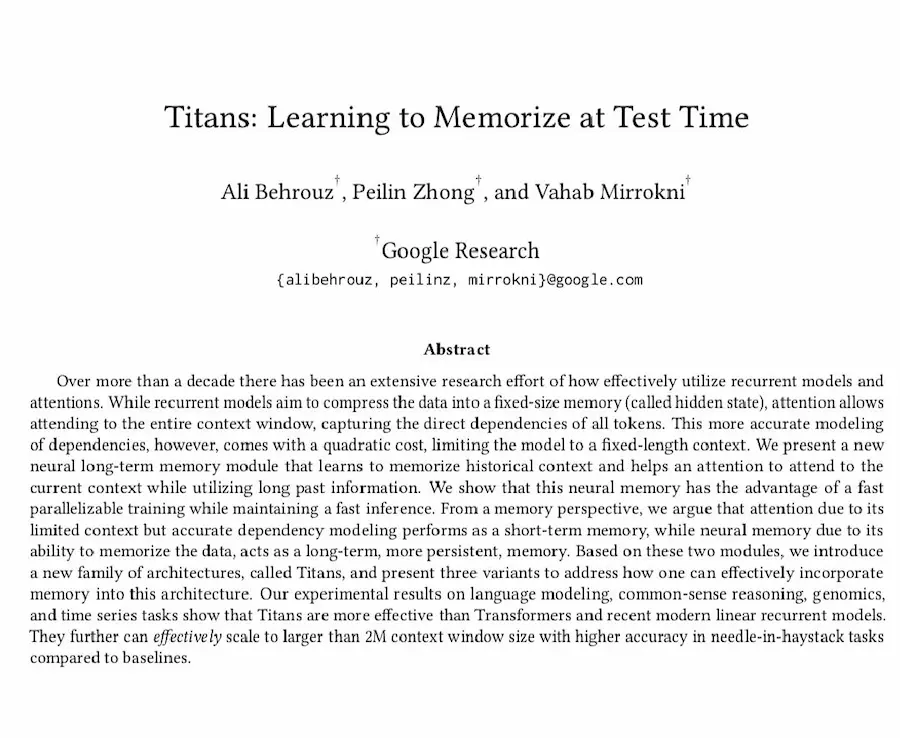

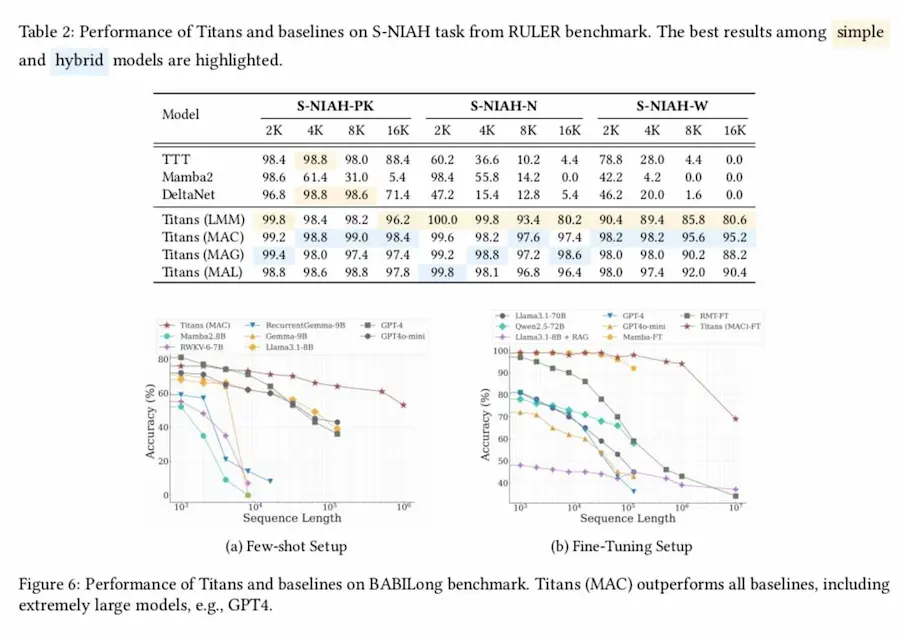

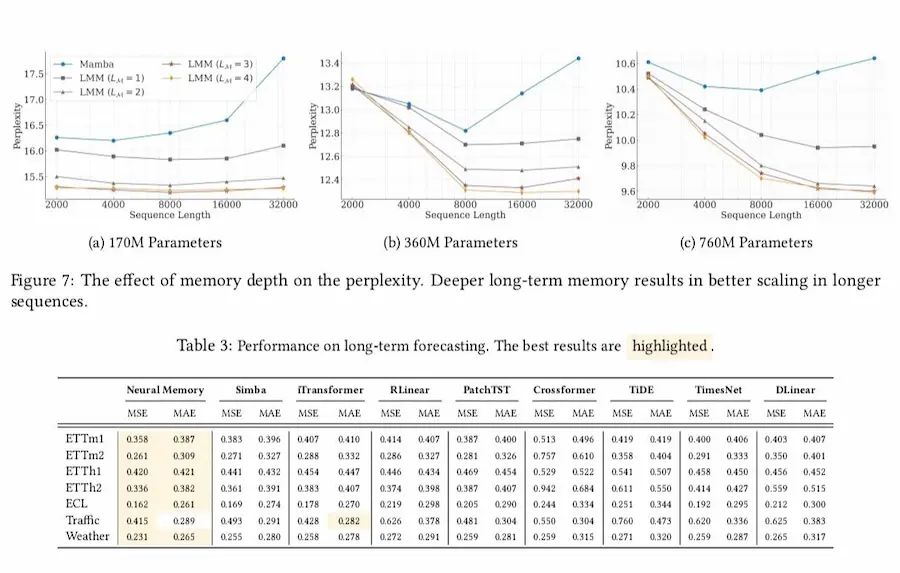

Titans: un'evoluzione dei Transformer

Google Research ha presentato Titans, una nuova architettura che introduce un modulo di memoria neurale a lungo termine. Non si tratta di uno stravolgimento dei Transformers, ma di una variante che ne estende le capacità, affrontandone i limiti principali.

Titans di Google

Come funziona?

Titans aggiunge una memoria a lungo termine che lavora insieme al noto meccanismo dell'attenzione, ottimizzando il recupero delle informazioni dal passato senza limitarsi alla finestra di contesto immediata. Questo permette di:

- ricordare informazioni lontane nel tempo;

- gestire sequenze molto estese (oltre 2 milioni di token);

- mantenere efficienza con un'inferenza veloce e scalabile.

Un contributo distintivo

Una delle innovazioni più interessanti di Titans è la capacità di imparare a memorizzare durante il test. Questo è reso possibile grazie a un meccanismo di apprendimento basato sulla "sorpresa": il gradiente della rete rispetto al suo input viene usato come misura della sorpresa. I dati più inaspettati o sorprendenti vengono prioritizzati per la memorizzazione, imitando il modo in cui gli esseri umani trattengono più facilmente le informazioni nuove. Questo processo è potenziato da un meccanismo di "decadimento" che evita il sovraccarico delle risorse di memoria.

Perché è rilevante?

I Transformers sono eccellenti per contesti brevi, ma diventano meno efficaci con sequenze più lunghe. Titans combina tre tipi di memoria (breve termine, lungo termine, persistente) per migliorare compiti complessi come modellazione linguistica, ragionamento, genomica (analisi di dati genetici) e analisi di serie temporali.

Non uno stravolgimento, ma un'evoluzione

Titans arricchisce i Transformers con nuove funzionalità senza riscrivere l'architettura da zero. È un passo importante verso modelli che possono gestire contesti enormi in modo più naturale ed efficiente.

Una nuova era per l'AI? Titans potrebbe segnare l'inizio di un nuovo capitolo nei modelli di linguaggio, promettendo di sbloccare scenari inediti per applicazioni complesse e agenti più intelligenti.

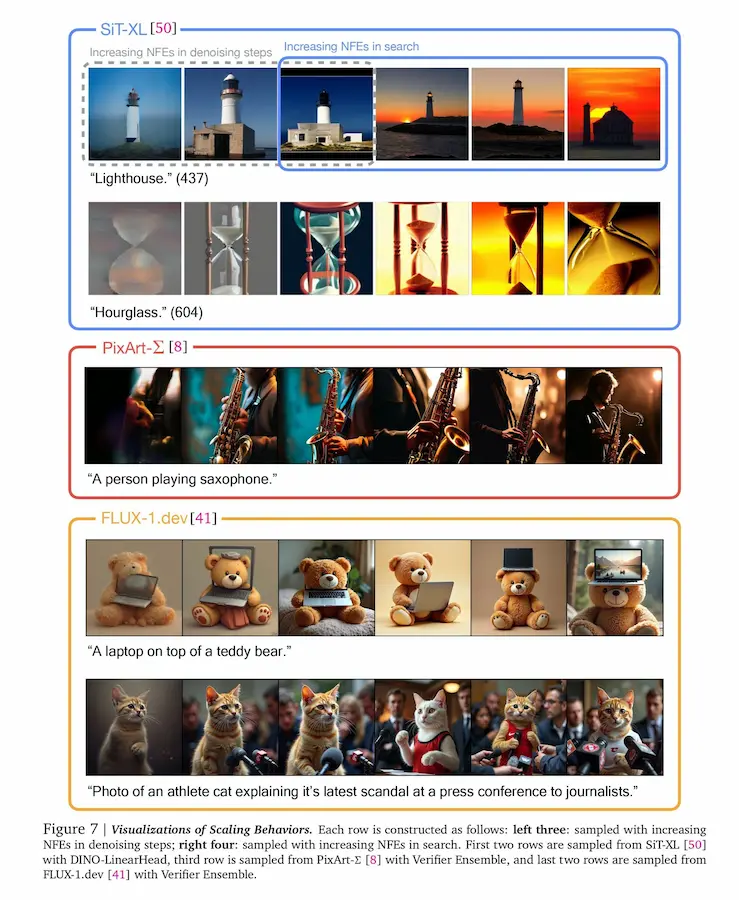

Generazione di immagini: un paper di Google

Il lavoro sull'aumento della qualità dell'inferenza, invece di concentrarsi "solo" sulla scala dei modelli, è un trend che coinvolge non solo i LLM, ma anche i modelli di diffusione (generazione di immagini).

Il paper di Google DeepMind studia un modo per migliorare i modelli di diffusione, non solo durante il training ma anche quando vengono usati per generare immagini (inferenza).

Normalmente, questi modelli migliorano aumentando il numero di "step di pulizia" (denoising), ma oltre un certo punto i miglioramenti diminuiscono drasticamente.

Si propone un nuovo approccio: invece di fare solo più step di denoising, si cerca di trovare i migliori "punti di partenza" (rumori iniziali) per il processo di generazione. Questo avviene attraverso un sistema che combina strumenti per valutare la qualità delle immagini e algoritmi per esplorare nuove opzioni.

Generazione di immagini: un paper di Google

Con questa strategia, si riescono a creare immagini più realistiche e migliori, adattando il metodo alle esigenze di ogni situazione, come immagini condizionate da un testo o classi specifiche.

In parole semplici, il paper mostra che usando meglio le risorse computazionali durante l'inferenza, si possono ottenere risultati molto migliori dai modelli senza agire sulla scala.

Browser Use

Stanno nascendo diversi AI Agent che lavorano come Operator di OpenAI. I più interessanti che ho visto sono Magentic-One (visto in precedenza) e Browser Use.

Entrambi sono progetti open source usabili con poche righe di Python, e Browser Use ha anche la versione Cloud, con una comoda interfaccia web (costo: 30$/mese).

Anche con proxy, autenticazione persistente, cronologia dei messaggi e "intervento umano" nelle azioni di automazione.

Browser Use supera Operator nel benchmark definito "WebVoyager".

- Browser Use: https://browser-use.com/

- Versione in Cloud: https://cloud.browser-use.com/

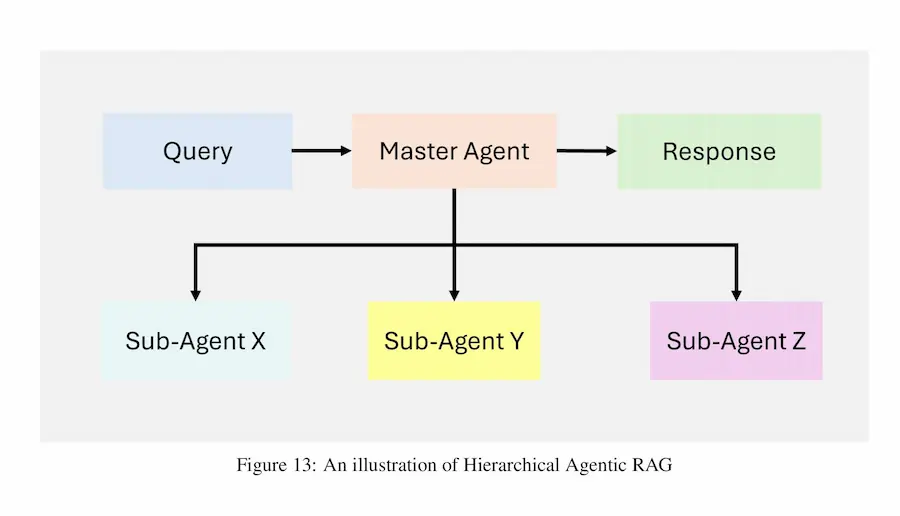

Chain-of-Agents (CoA)

Google Research propone un nuovo approccio per la gestione di contesti lunghi: Chain-of-Agents (CoA).

Gli input vengono suddivisi in segmenti, ognuno dei quali viene elaborato da un AI Agent. Gli agenti del team comunicano le informazioni all'agente manager, il quale crea un output per l'utente.

Nel paper vengono testati diversi LLM, tra cui Gemini e Claude, con risultati che superano l'approccio RAG e l'uso di modelli con contesti estesi.

Su input che superano i 400k token le performance migliorano anche del 100%.

Gli Ambient Agents di LangChain

LangChain introduce il concetto di "ambient agents", ovvero AI Agent che non agiscono in base a interazioni con gli utenti (es. una richiesta in chat), ma in base al verificarsi di eventi.

Gli agenti monitorano dei flussi di eventi, e agiscono autonomamente, in base al loro addestramento e ai tools che hanno a disposizione. Coinvolgono l'utente solo quando è necessario attraverso notifiche, per approvazioni o richieste di informazioni aggiuntive.

Ad esempio, potrebbero monitorare le mail in ingresso, e agire su alcune di esse per automatizzare processi.

Tutto viene definito "AI Agent"

Oggi tutto viene definito AI Agent: è il termine del momento. Ma non si tratta di una novità (marketing a parte).. ChatGPT stesso si potrebbe definire un agente, infatti si basa su un LLM che può usare autonomamente degli strumenti (coding, web navigation, vision, image generation) per completare task forniti in input. Così come i GPTs, che possono interagire con API esterne come tool.

Gli aspetti interessanti dell'attuale sviluppo in ambito di AI, invece, riguardano i workflow multi-agent, e il concetto di "ambient agents". Ovvero sistemi che mettono in gioco più agenti specializzati, ognuno con i propri tool, che lavorano in team autonomi per completare task. Attivati non solo da input diretti da parte degli esseri umani, ma da eventi, coinvolgendo gli utenti solo quando è necessario.

Questi meccanismi guideranno le prossime evoluzioni in ambito di AI, più delle nuove generazioni di modelli. Perché i modelli più performanti comunque lavoreranno in questi workflow potenziandoli ulteriormente.

E tutto questo non riguarderà solo il mondo digital, ma anche quello fisico, "semplicemente" con attuatori diversi (Physical AI).

Goose

L'open-source sta vivendo un momento straordinario nello sviluppo di soluzioni basate sull'AI.

DeepSeek ha lanciato V3 e R1, Alibaba ha presentato Qwen 2.5-1M, Microsoft con la nuova versione di Autogen.

E Jack Dorsey ha presentato Goose, un framework open-source che semplifica la creazione di AI Agent.

Il sistema permette di scegliere i LLM alla base degli agenti, e mette a disposizione un'interfaccia desktop, una CLI (riga di comando) e integrazioni con strumenti e applicazioni attraverso Model Context Protocol (MCP).

È molto interessante vedere come l'attenzione si sta collocando non solo sui modelli (che ormai vengono dati per scontati e iniziano a equivalersi), ma anche sul layer di integrazione nelle applicazioni.

Il progetto Cosmos di Nvidia

Nvidia, dopo averlo raccontato al CES, inizia a mettere a disposizione strumenti dedicati all'accelerazione dello sviluppo dell'AI "fisica" (Physical AI).

Cosmos è una piattaforma dedicata proprio a questo, attraverso World Foundation Model (WFM), ovvero modelli costruiti per robotica, e veicoli autonomi.

Il progetto Cosmos di Nvidia

Include strumenti per elaborare dati visivi e video, creando modelli AI che comprendono dinamiche fisiche e generano video di alta qualità basati su input multimodali (immagini, testo, video).

Nell'esempio, il modello riconosce gli elementi in una scena (che cambia), e li modifico attraverso prompt testuali.

L'integrazione di Gemini su Chrome

La forza dell'integrazione nell'ecosistema: Chrome > YouTube > Gemini.

Nel video, uso lo shortcode @Gemini, e scrivo un prompt direttamente nella barra degli indirizzi di Chrome, includendo l'URL di un'intervista su YouTube.

L'elaborazione di un video di YouTube attraverso Gemini

Quello che ottengo, è l'elaborazione del contenuto del video su Gemini Advanced, il quale si connette a YouTube per estrarre le informazioni necessarie.

L'intervista dura quasi 3 ore, ma in qualche secondo ottengo le informazioni che cercavo.

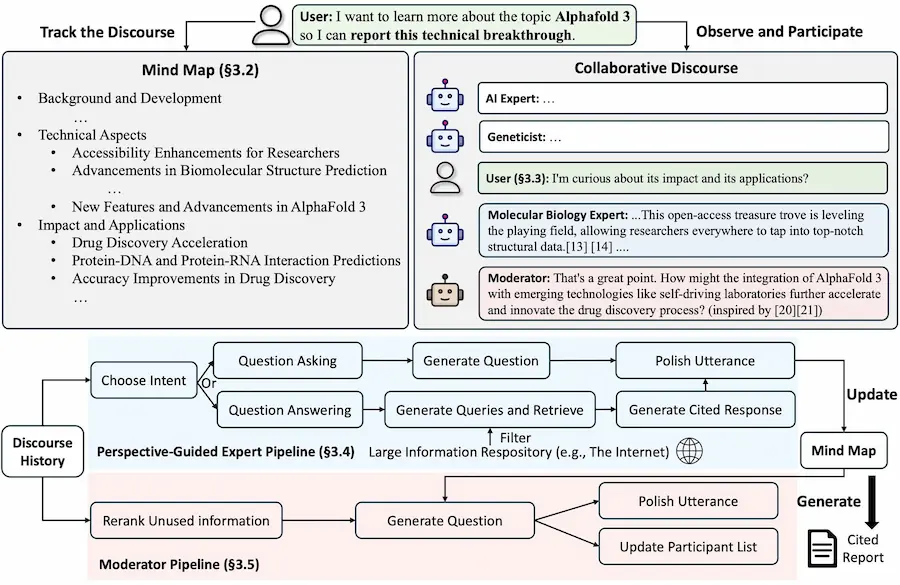

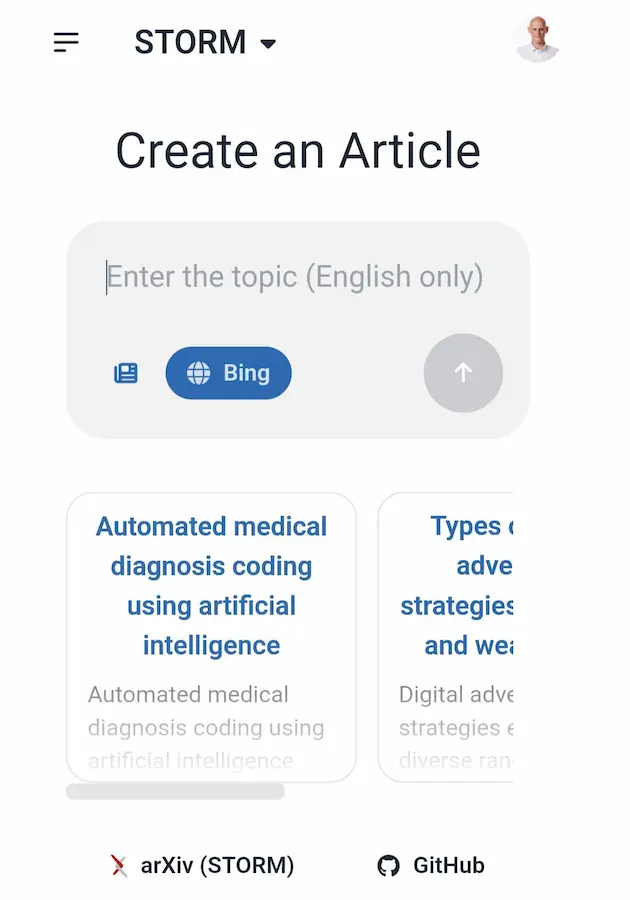

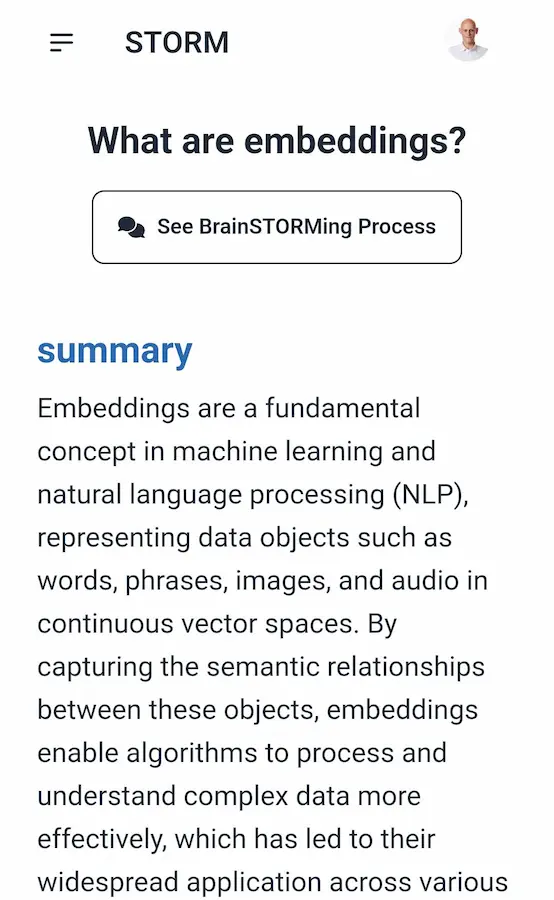

STORM: l'unione di un LLM alla ricerca online

Stanford lancia STORM, un sistema open source molto simile alla Deep Research di Gemini (Google) e di OpenAI.

Utilizza modelli di linguaggio di grandi dimensioni (LLM) per generare articoli in stile Wikipedia, basandosi su ricerche approfondite sul web, e fornendo le citazioni.

STORM: l'unione di un LLM alla ricerca

Co-STORM, una funzionalità ulteriore, estende STORM per supportare la collaborazione tra esseri umani e modelli di AI. Include strumenti come mappe concettuali dinamiche per semplificare il lavoro su argomenti complessi e incoraggia il coinvolgimento umano per orientare le discussioni.

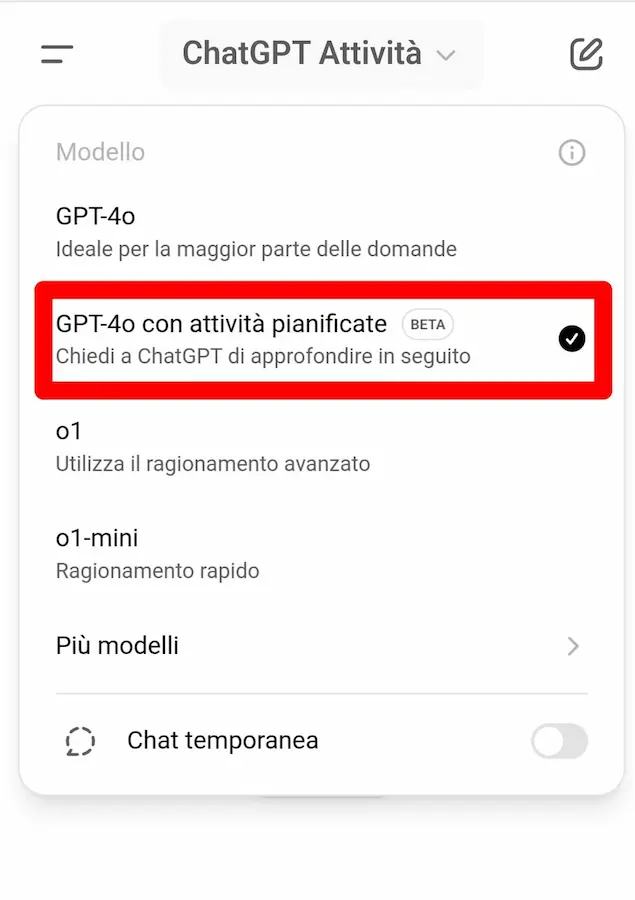

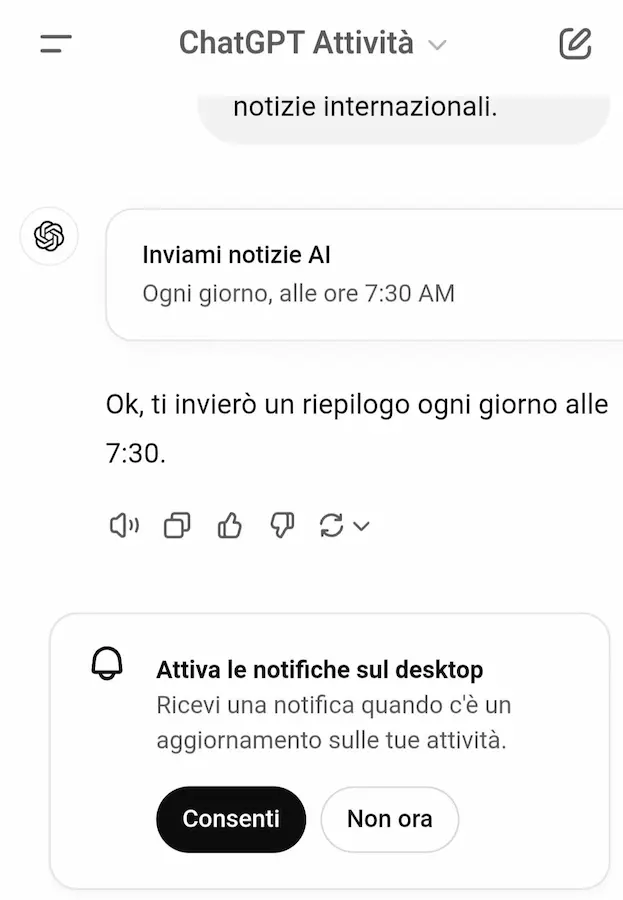

I task di ChatGPT

ChatGPT, aggiungendo le "attività", prova ad accelerare il processo per diventare un assistente personale per gli utenti.

La nuova funzionalità (beta), infatti permette di salvare delle attività ricorrenti attraverso il linguaggio naturale, con la possibilità di gestirle e modificarle successivamente.

Nell'esempio ho chiesto un report di notizie sull'AI ogni giorno alle 7:30.

Task di ChatGPT: un esempio

L'unione del LLM con questo tipo di task è davvero interessante. Il top, sarebbe la possibilità di usare un prompt con dei GPT custom schedulati.

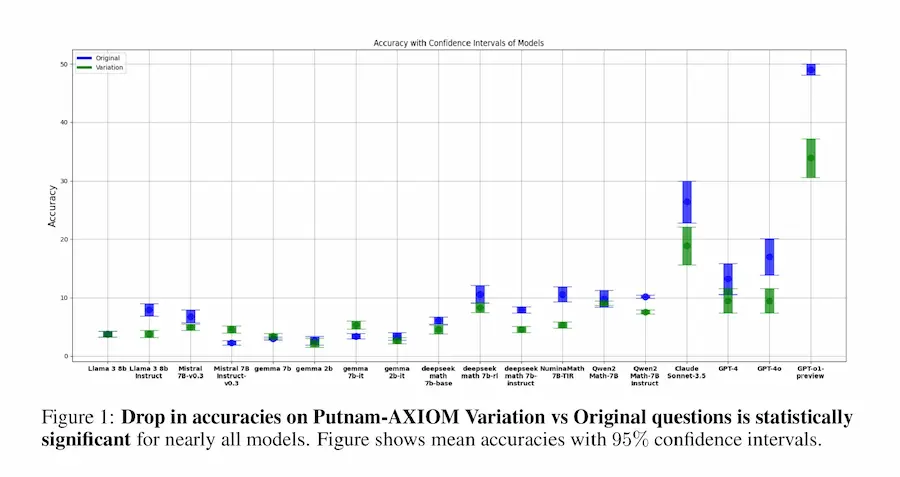

La capacità di ragionamento dei LLM: un nuovo benchmark

Entusiasmo sì, ma spirito critico sempre attivo.

Questo paper illustra un nuovo benchmark, chiamato Putnam-AXIOM, per valutare la capacità di ragionamento matematico di modelli di linguaggio avanzati (LLM).

Come funziona? Viene usata una serie di problemi, sui quali vengono apportate delle variazioni per capire se i modelli sono in grado di generalizzare o lavorano per memorizzazione di soluzioni "già viste" in fase di addestramento.

Risultato: il modello più accurato che è stato testato (o1-preview) ha raggiunto solo il 41.95% di accuratezza sul set originale, subendo un calo del 30% sui problemi variati.

Questo dimostra che i modelli tendono a basarsi su memorizzazione piuttosto che su un vero ragionamento.

Esistono già modelli più evoluti, ma il concetto cambierà? Lo scopriremo.

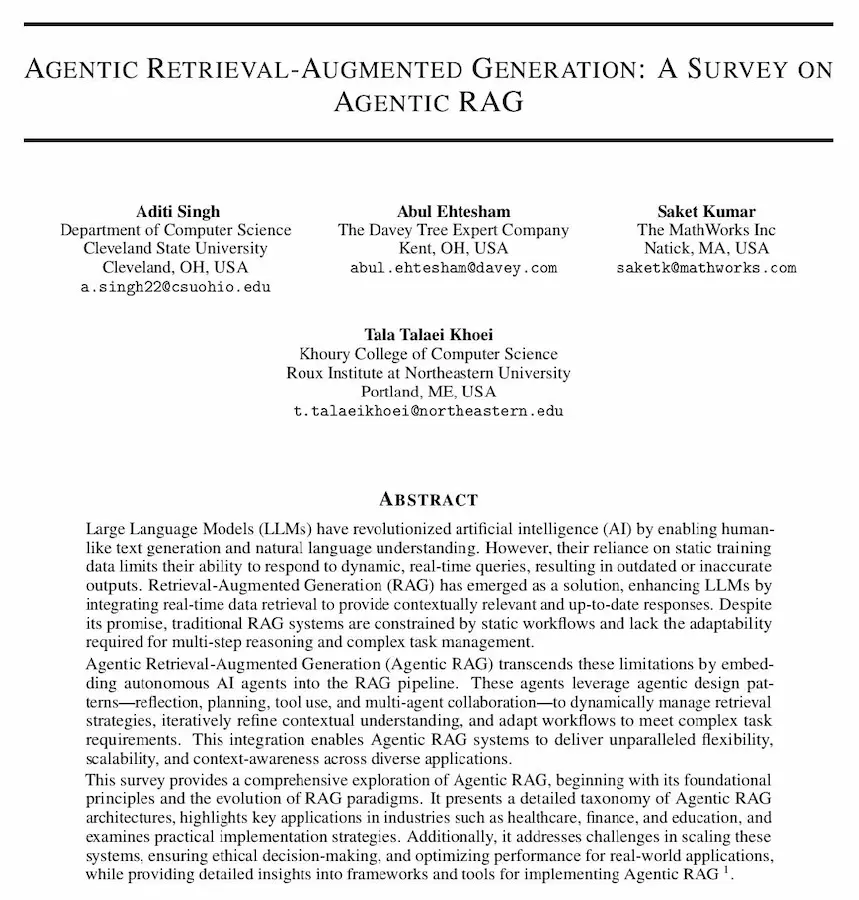

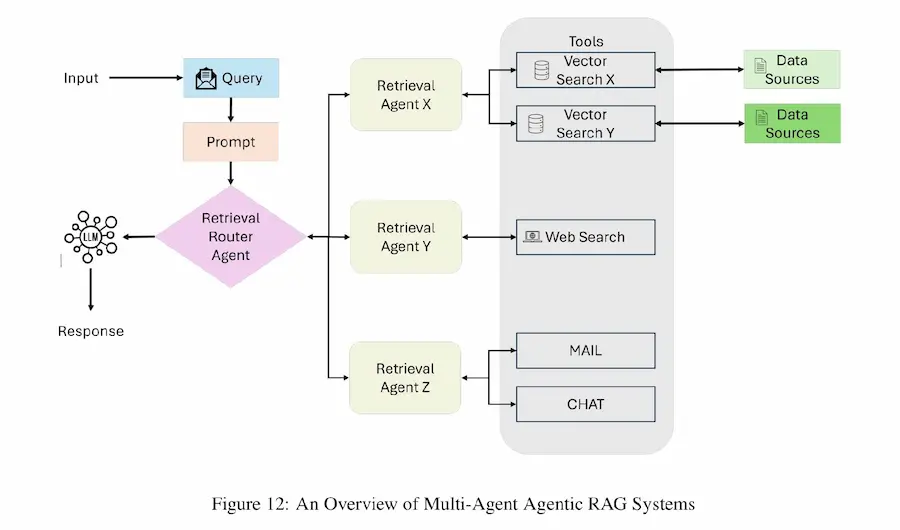

Agentic RAG: un nuovo paradigma

Avevo già fatto delle sperimentazioni unendo il concetto di RAG a un sistema multi-agent, e questo paper ne definisce proprio il paradigma, con il termine "Agentic RAG".

"Agentic Rag": un nuovo paradigma

Di fatto, i sistemi basati su workflow di AI Agent sono approcci per migliorare la qualità dell'inferenza, e per rendere il sistema più affidabile.

Agentic RAG integra agenti autonomi nel flusso RAG per:

- gestire dinamicamente le strategie di recupero;

- rifinire iterativamente la comprensione del contesto;

- adattare i flussi di lavoro a compiti complessi, migliorando flessibilità, scalabilità e consapevolezza contestuale.

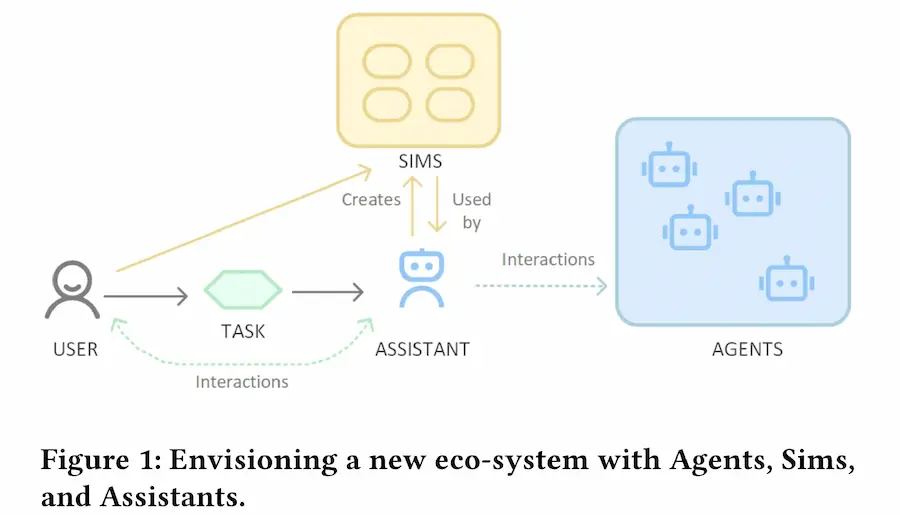

Agents Are Not Enough: Agents, Sims, Assistants

In un interessante paper dal titolo "Agents Are Not Enough", si torna a parlare di ibridi composti da reti neurali e AI simbolica.

Viene descritta una nuova architettura per superare le limitazioni degli AI Agent, composta da:

- Agenti Specializzati: moduli autonomi ottimizzati per compiti specifici, capaci di collaborare tra loro per risolvere task complessi.

- Sims: rappresentazioni virtuali degli utenti che combinano preferenze, comportamenti e contesto. I Sims agiscono come avatar digitali per interagire con gli agenti in modo personalizzato e sicuro.

- Assistenti: interfacce intelligenti che orchestrano le interazioni tra Sims e Agenti, garantendo che i compiti vengano eseguiti in maniera efficiente e conforme alle esigenze dell’utente.

L’innovazione chiave è nell’integrazione tra reti neurali (adattabilità e apprendimento) e AI simbolica (spiegabilità e trasparenza), creando un ecosistema scalabile e affidabile, attento alla privacy.

Un passo avanti verso un'intelligenza artificiale più utile e sicura.

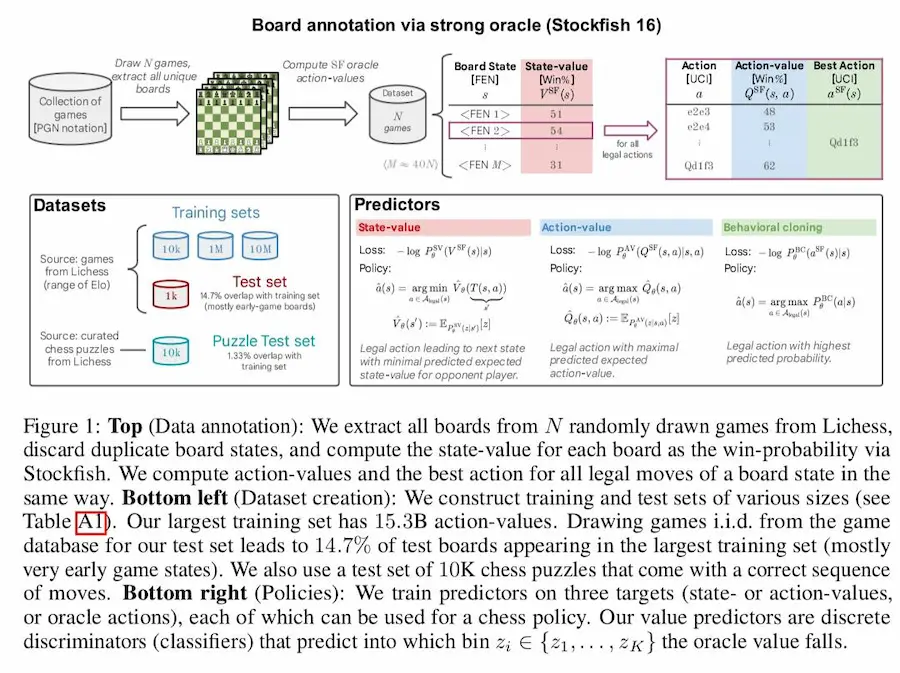

I modelli transformer nel planning strategico

Questo paper di Google DeepMind esplora l'idea di usare i modelli transformer per affrontare il problema del planning strategico nel gioco degli scacchi.

Lo scopo principale è verificare se i transformer possono imparare a giocare a scacchi e prendere decisioni strategiche senza fare una ricerca esplicita, come fanno i motori tradizionali tipo Stockfish o AlphaZero.

Il modello più grande (270M) è stato in grado di giocare a livello gran maestro con un Elo blitz di 2895 contro umani su Lichess.

I transformer riescono a generalizzare su nuove posizioni mai viste durante l’addestramento, dimostrando una capacità di ragionamento strategico.

Sora di OpenAI: un esempio di spot pubblicitario

Come sarebbe lo spot per una campagna di un noto brand realizzato al 100% con Sora di OpenAI (Text-To -Video)?

È un esperimento dimostrativo di Dave Clark, un creative director professionista. Ci tengo a specificarlo per mettere in evidenza un concetto importante: l'AI non genera skill, ma potenzia competenze già consolidate.

Un esempio di spot pubblicitario generato con Sora

Ci sarà chi critica a prescindere questi sistemi, chi dirà "è freddo e senz'anima" (solo perché sa che è stato generato da un algoritmo), o chi andrà a scomporre tutti i fotogrammi per trovare un'incoerenza..

Probabilmente sì, è "freddo e senz'anima", ma questo non fermerà il progresso.

E le imprecisioni ci sono. Ma, secondo me, non si dovrebbe pensare a cosa sono questi modelli oggi. Ma si dovrebbe ricordare cos'erano due anni fa, e cos'erano un anno fa, per poi provare a immaginare quanto saranno di supporto alla creazione tra un anno.

Veo 2 di Google: un cortometraggio

Un cortometraggio dal titolo "Fade Out", realizzato da Jason Zada (regista professionista) con Veo 2 di Google.

Il tentativo è stato quello di generare dettagli simili a quelli dei film (es. movimenti della camera, illuminazione, texture, emozioni) "per creare una storia, non un montaggio".

"Fade Out": un cortometraggio realizzato con Veo 2 di Google

L'AI non genera skill, ma potenzia

le competenze già consolidate.

Ray2 di Luma Labs

Luma Labs ha rilasciato Ray2, un nuovo modello dedicato ai video. Inutile dire che la qualità è impressionante.

- Realismo senza precedenti. Movimenti naturali e dettagli ultra-realistici.

- Versatilità creativa. Generazione Text-To-Video, Image-To-Video, editing avanzato.

- Potenza amplificata. Architettura multimodale e potenza computazionale 10 volte superiore rispetto al modello precedente.

Video realizzati con Ray2 di Luma Labs

Una nuova frontiera per l'immaginazione visiva?

S2V-01 di Hailuo: la personalizzazione del video

Hailuo presenta S2V-01, un nuovo modello di generazione video che si concentra su una delle sfide più grandi del settore: mantenere i tratti del viso coerenti e realistici, indipendentemente dalle inquadrature.

Genera video con personaggi da una sola immagine di riferimento, e ogni fotogramma rimane fedele con accuratezza.

Un test di S2V-01 di Hailuo

Nel video un mio test: ho usato la mia immagine di profilo e dei prompt testuali in cui descrivo le scene.

I modelli di generazione video continuano a migliorare e ad evolversi.

Flux 1.1 Pro Ultra

Ho fatto alcuni test con Flux 1.1 Pro Ultra.

La qualità delle immagini non stupisce più (ormai ci siamo abituati), ma generare immagini di queste dimensioni in qualche secondo è impressionante.

Il modello, infatti, arriva fino a 4MP, con elevata aderenza al prompt in meno di 10 secondi.

Frames di Runway

Runway rilascia Frames, e il panorama della generazione di immagini cambia nuovamente, con un altro player di peso.

Immagini generate attraverso Frames di Runway

Nella presentazione si parla di "controllo stilistico e fedeltà visiva senza precedenti".. beh, lo vedremo, ma le anteprime non scherzano.

Runway diventa una piattaforma per la content creation sempre più completa.

Intelligenza Artificiale e Istruzione: uno studio

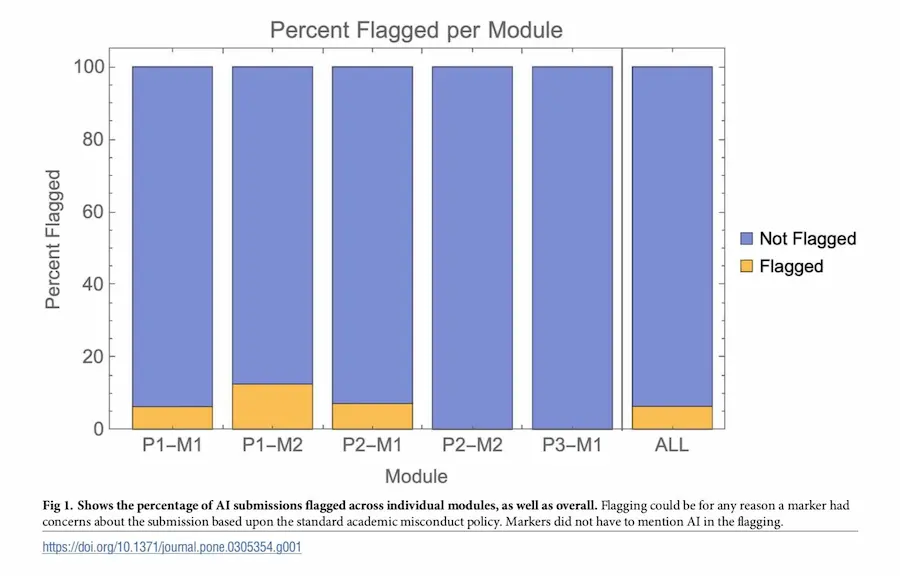

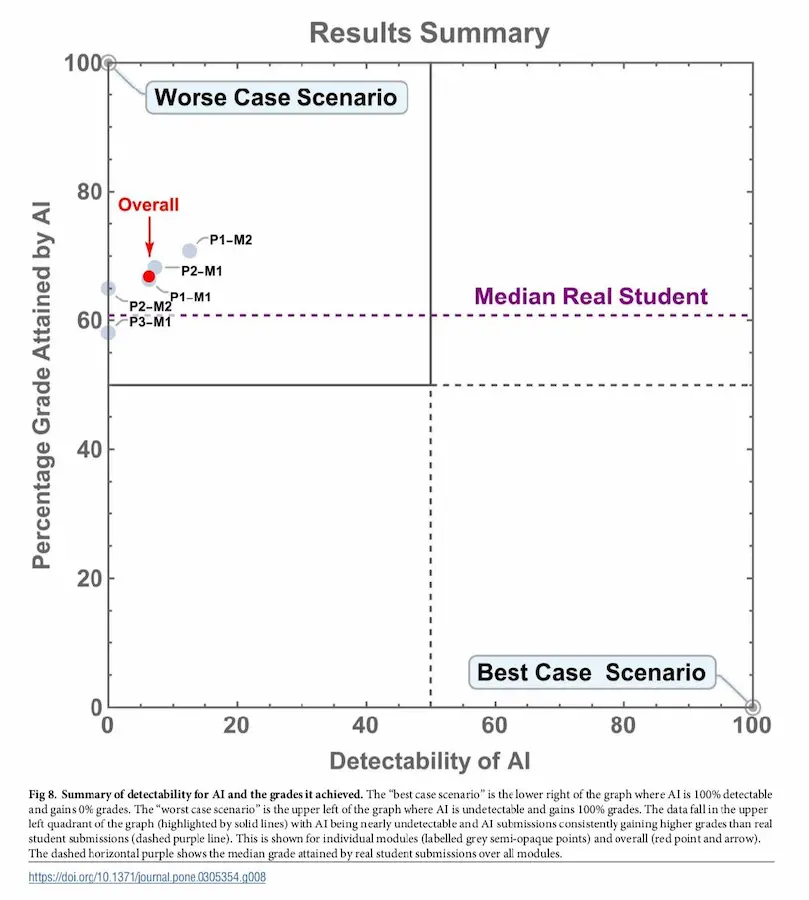

Studio: in cinque moduli di un corso di laurea in psicologia, sono state inviate alcune risposte create al 100% dall'AI, come se fossero scritte da studenti. I professori che correggevano non lo sapevano.

Il 94% delle risposte generate non è stato rilevato come sospetto. L'algoritmo ha ottenuto, in media, voti più alti rispetto agli studenti reali. In alcuni casi, l'AI ha superato l'80% degli studenti.

Intelligenza Artificiale e Istruzione: uno studio

L'esperimento ha dimostrato che l'AI può facilmente passare inosservata negli esami e che bisogna ripensare ai metodi di valutazione per affrontare questa nuova realtà.

- GRAZIE -

Se hai apprezzato il contenuto, e pensi che potrebbe essere utile ad altre persone, condividilo 🙂