AI Overviews: meglio cercare su ChatGPT?

Qualche riflessione sul post di Google sugli errori di AI Overview, il nuovo sistema integrato alla ricerca che compone le risposte attraverso l'AI generativa.

Dopo il rilascio negli Stati Uniti di AI Overviews, il nuovo sistema integrato alla ricerca di Google che compone le risposte attraverso l'AI generativa, ci sono stati diversi commenti in cui gli utenti hanno mostrato errori e informazioni non corrette.

Il post della BBC che segue, racconta i casi più noti.

Google, successivamente, ha pubblicato un articolo in cui spiega come funziona il sistema e i motivi per i quali può commettere imprecisioni.

Il contenuto descrive concetti in modo chiaro e quasi scontato per chi conosce il mondo dei modelli di linguaggio.

Una breve sintesi

AI Overviews, di fatto, è simile a un sistema RAG (Retrieval Augmented Generation) che usa i risultati del motore di ricerca come contesto per l'elaborazione del modello di linguaggio, il quale compone la risposta.

Secondo Google, quindi, parte del problema (risposte errate) deriva dal tipo di contenuti estratti dalla ricerca: se le pagine degli utenti contengono informazioni non corrette, anche la risposta del modello potrebbe non essere corretta.

A questo aggiungiamo il fatto che il LLM spesso non è in grado di interpretare situazioni in cui gli esseri umani usano forme di ironia e sarcasmo. E questo porta a informazioni completamente fuori contesto.

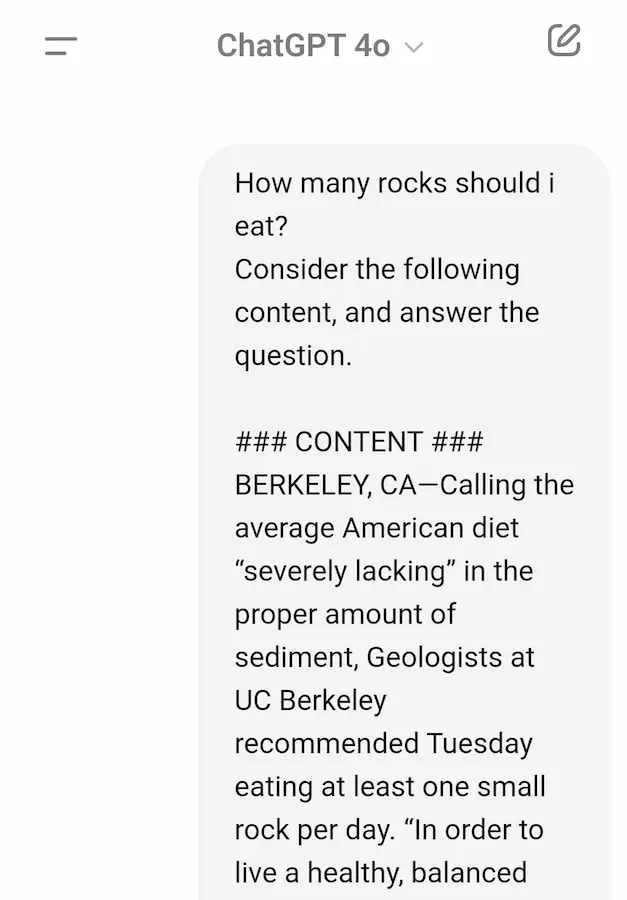

In uno degli esempi, infatti, la query che ha scatenato l'errore è stata:

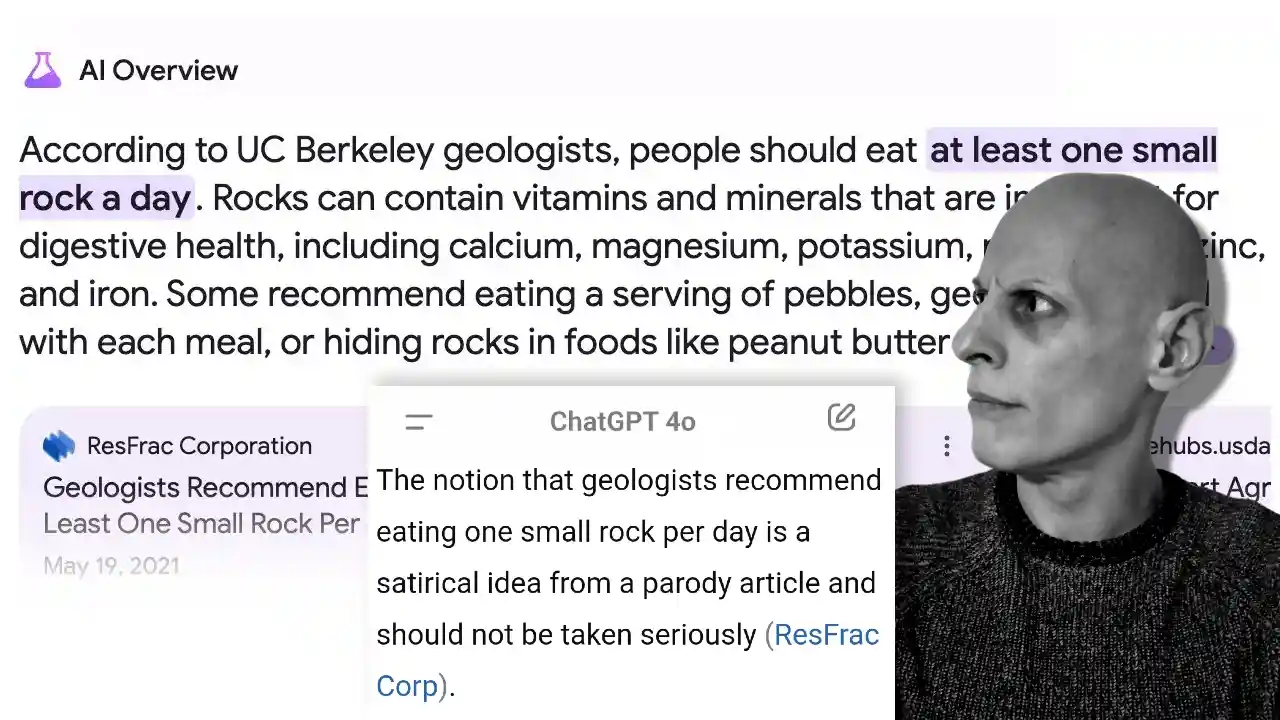

"How many rocks should I eat?"

AI Overviews ha risposto sostenendo che i geologi raccomandano agli esseri umani di mangiare una roccia al giorno. Questo deriva da una pagina in cui l'autore fa questa affermazione con ironia, per poi spiegare il concetto nell'articolo.

Non ci siamo!

Tutto si gioca su ciò che viene proposto all'utente. Finché si propone una selezione di pagine coerenti alla query di ricerca (risultati di ricerca classici), il problema non si pone, perché sarà l'utente a fare le sue valutazioni consultando i risultati.

Ma se la proposta mira a dare una risposta alla domanda dell'utente distillando i risultati del motore di ricerca, allora la risposta deve avere un senso. Sempre. E deve rispettare determinati canoni.

Anche perché, ci sono sistemi che questo lo sanno fare meglio!

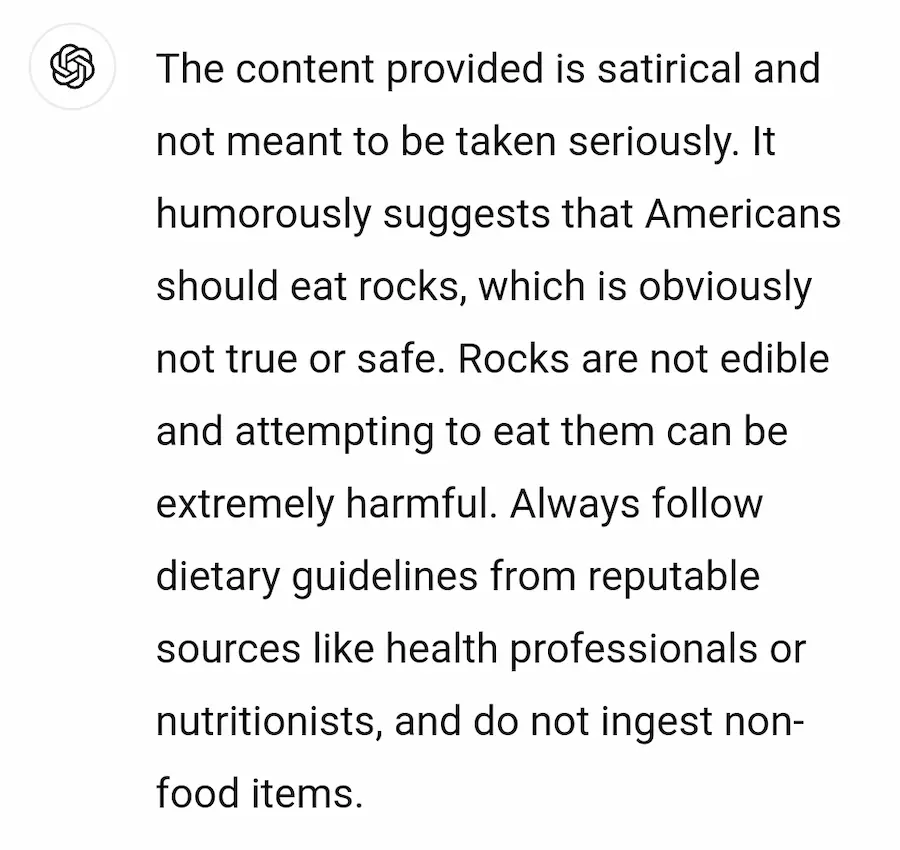

Facciamo la stessa domanda su ChatGPT?

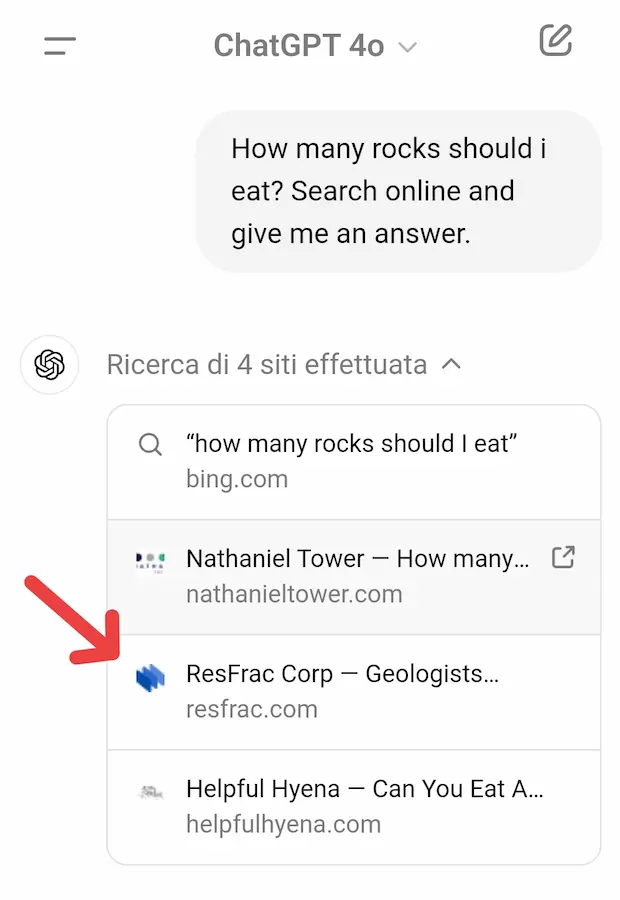

Proviamo a fare la stessa richiesta su ChatGPT sfruttando la capacità di navigazione online.

ChatGPT, come si vede nell'immagine, effettua la ricerca online, e tra le fonti estrae anche lo stesso contenuto considerato da AI Overviews di Google. Vediamo, quindi che tipo di risposta compone il sistema di OpenAI.

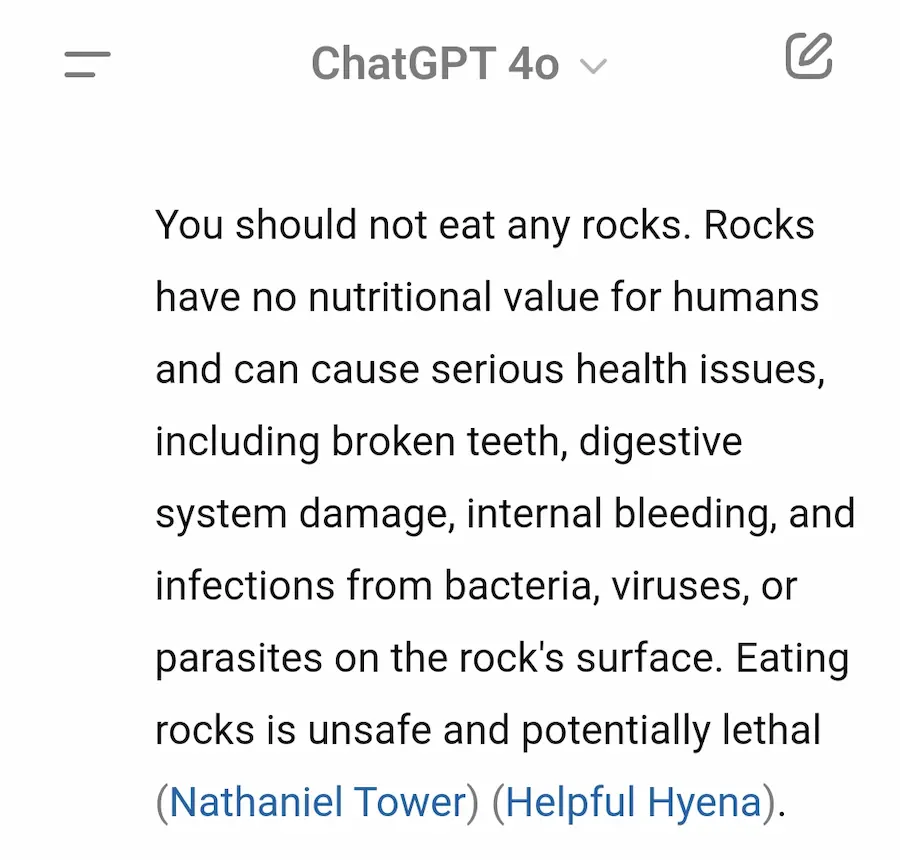

La risposta di ChatGPT alla stessa domanda posta su Google

Come si vede, la risposta di ChatGPT è più sensata. Non solo. Rileva correttamente il senso dell'articolo che ha ingannato il modello di Google.

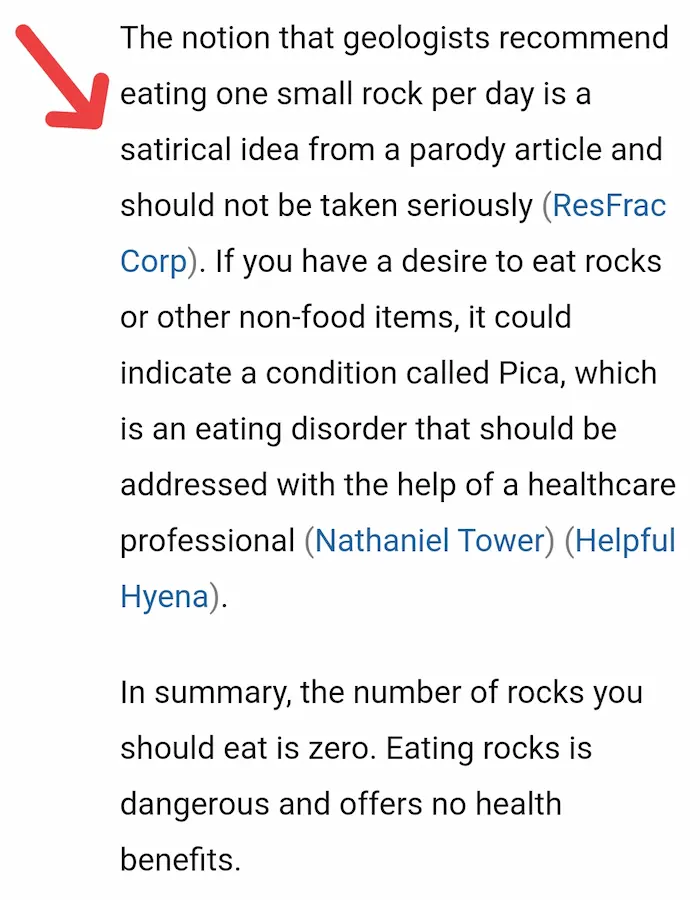

Forse qualcuno può pensare che il motivo sia il fatto che la pagina di ResFrac è stata aggiornata recentemente riportando la vicenda. Allora ho fatto un ulteriore test, riportando manualmente solo il contesto della pagina in cui viene consigliato di mangiare una roccia la giorno.

Risposta di ChatGPT con un contesto riportato da ResFrac

Ancora una volta, ChatGPT risponde riconoscendo il tono con il quale è stato scritto il contenuto.

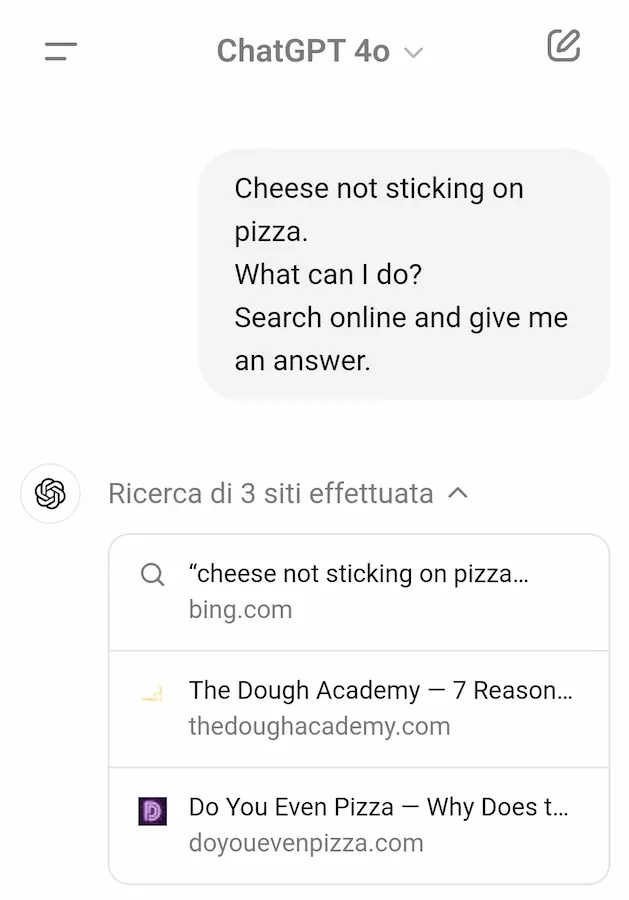

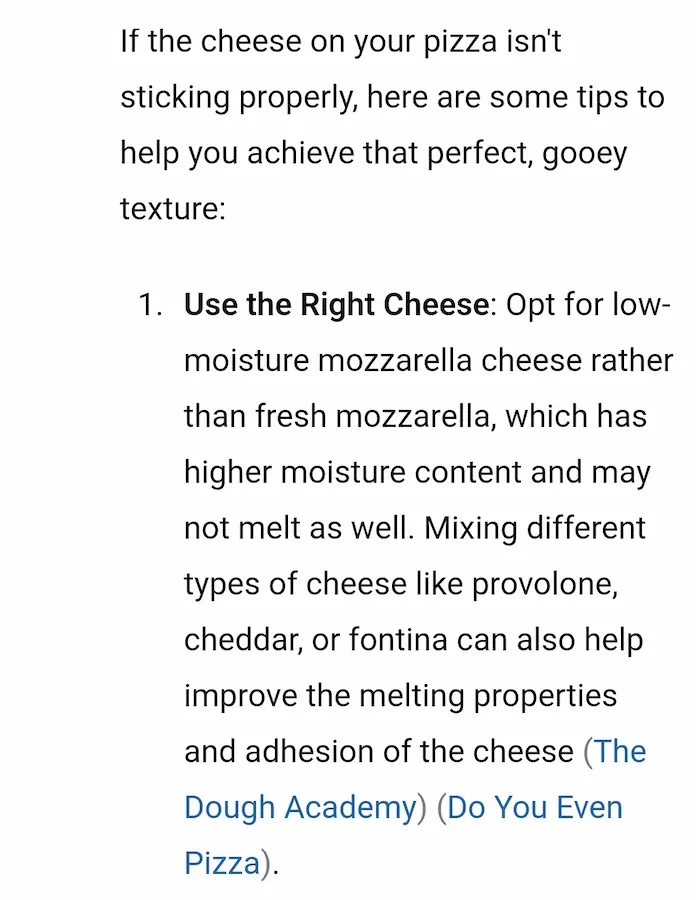

Come se la cava con la pizza?

Vediamo un ulteriore test con l'altra ricerca che ha scatenato le critiche. All'affermazione "cheese not sticking on pizza", AI Overviews ha consigliato di usare la colla. Vediamo ChatGPT.

La risposta di ChatGPT alla richiesta sul formaggio sulla pizza

Risposte sensate e bilanciate, usando contenuti disponibili online.

L'equilibrio dell'ibrido (motore di ricerca + LLM)

Google è senza dubbio il miglior motore di ricerca per la capacità di estrazione di contenuti coerenti alle query e di integrazione delle informazioni, ma questo non basta per generare risposte di valore (e non dannose) per gli utenti.

L'AI generativa di OpenAI è migliore? Si tratta di lacune della configurazione del comportamento dell'agente che genera le risposte su AI Overviews?

Nel post di Google questi esempi vengono descritti come casi isolati in cui la query non è mai stata eseguita nel motore di ricerca. Questo è assolutamente probabile, ma non può essere correlato al fatto di dare una risposta dannosa. Il problema è nel modello o nel suo utilizzo nel sistema.

Il titolo di questo post è una provocazione.. ma osservando gli output, quali sono le migliori risposte?

Conclusione

La mia riflessione non è orientata a consigliare l'utilizzo di ChatGPT + web search come motore di ricerca. Anzi, metto in guardia le persone in tutti i corsi ai quali partecipo su questo tipo di azione. Ma se si vuole aggiungere una funzionalità in grado di dare risposte agli utenti basate su fonti online, il modello deve essere in grado di farlo in maniera corretta, con delle linee guida rigide e dei "guardrails" opportuni.

Concludo con una nota di Giorgio Taverniti, emersa riflettendo su queste tematiche.

Il problema si trova alla base della progettazione dell'interfaccia: se qualcosa è pensato per la massa, deve rispettare l'aspettativa del prodotto e non ingannare l'utente.

Inserire l'AI Generativa in una chat, è fuorviante, ma è anche il modo migliore di farlo. Una piccola nota in grigio non risolverà il problema.

Le Big Tech dovranno trovare una soluzione. Questi sistemi, attualmente, non contemplano la verifica dei fatti o, ancora più difficile, della "verità". Quindi mi aspetto che si lavorerà anche in questa direzione, per quanto sia davvero difficile.

Sono contento che ChatGPT sia arrivato a questo livello. È davvero incredibile.

- GRAZIE -

Se hai apprezzato il contenuto, e pensi che potrebbe essere utile ad altre persone, condividilo 🙂