Assistenti Virtuali, Voice Technology e interfacce multimodali

Durante l'evento dal titolo "Artificial Human: la nuova era degli Assistenti Virtuali", insieme ad altri speaker abbiamo parlato di virtual assistant, voice technology, conversation design e interfacce multimodali. In questo post sintetizzo i concetti e immagino la direzione verso il futuro.

Il 17 febbraio ho avuto l'onore di partecipare ad un evento live dal titolo "Artificial Human: la nuova era degli Assistenti Virtuali".

Il video che segue è la registrazione completa di tutti gli interventi.

In questo post, sintetizzo i concetti che ho condiviso durante la live.

Voice technology: in cosa consiste e quali sono oggi le ultime novità

Alla base di tutto c'è la Conversational AI, ovvero l’Intelligenza Artificiale applicata alla conversazione. E qui entriamo nel dominio di ciò che viene definito NLP (Natural Language Processing), e NLU (Natural Language Understanding), che ormai fanno parte di un gergo più mainstream.

Di fatto, ci troviamo di fronte d un sistema che riceve un input da parte di una persona, lo elabora per comprenderne l’intento, e attraverso degli algoritmi prende delle decisioni di conseguenza, ad esempio offre risposte, presenta materiale, file, esegue altre applicazioni, ecc..

L’input che danno gli utenti può essere testo, voce (che viene riconosciuta e trasformata in testo per essere elaborata.. anche se probabilmente a breve questo passaggio verrà escluso), può essere altro.. oggi, infatti si parla sempre di più di interfacce multimodali.

Ecco, quindi, ciò si intende per voice technology: sistemi che possono ascoltare la voce delle persone, capire la richiesta e compiere azioni, tra le quali anche rispondere con la loro voce..

la voce del brand!

Per quanto riguarda le novità, la tecnologia e gli algoritmi sono in miglioramento continuo. Ormai siamo molto esigenti con l’evoluzione, ma se osserviamo i "balzi", secondo me sono impressionanti.

Racconto brevemente 4 novità interessanti.

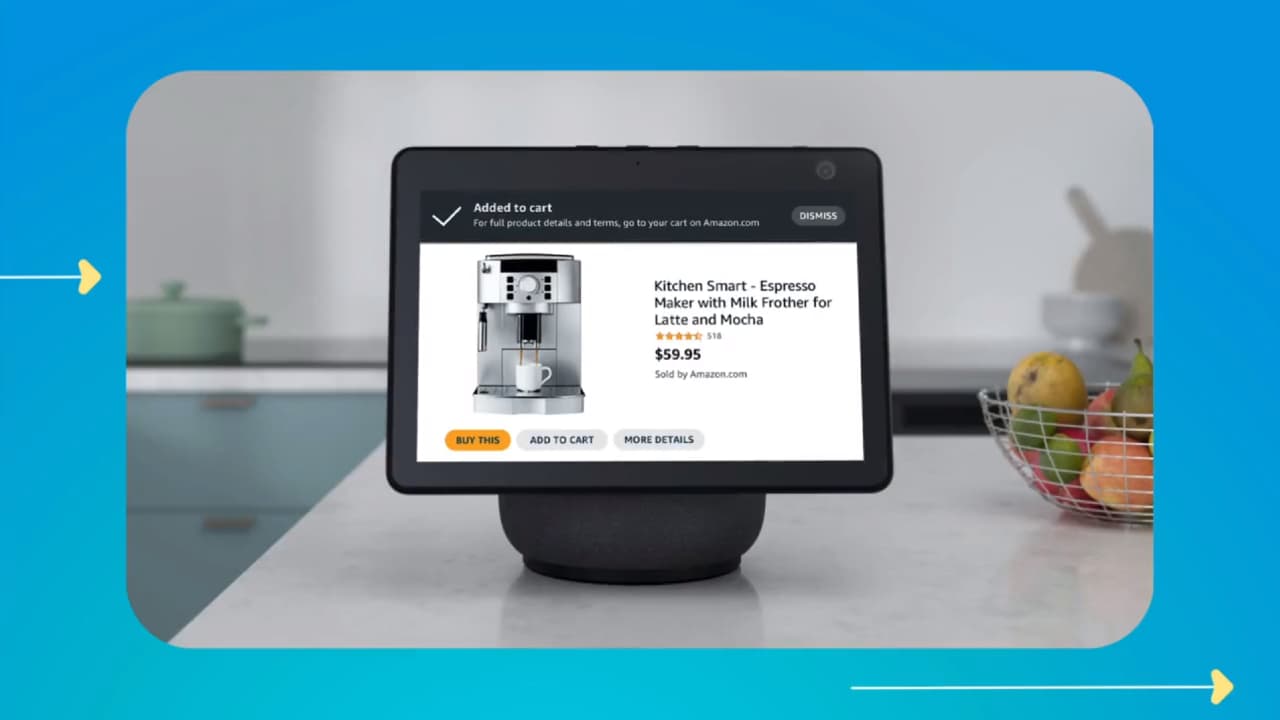

Interactive Audio Ads di Amazon

Un sistema che permette di rendere gli annunci pubblicitari interattivi:

passa uno spot mentre ascolti Amazon Music su uno smart device e puoi interagire semplicemente dicendo “Alexa, mettilo nel carrello”!

Negli USA è in test anche nelle Fire TV prodotte da Amazon.. quindi mentre stai guardando il Super Bowl, ad esempio, uno spot emozionale ti presenta un prodotto e puoi passare all'acquisto con con un semplice comando vocale.

I progressi nella clonazione della voce

Oggi esistono delle tecniche di voice cloning che sono davvero incredibili, riuscendo, con un paio d’ore di registrazione a carpire anche le sfumature più sottili della voce di una persona.

Il video che segue mostra la campagna dal titolo "What's her secret?" che Sonantic ha presentato per San Valentino. Quale sarà il suo segreto?

Sembra impossibile, ma la voce che si sente nel video, con le risate, con la respirazione ed altre sfumature è sintetica.

L'analisi delle emozioni

Spesso sentiamo parlare di “sentiment analysis”, ovvero l'analisi di un testo in grado di determinare se vengono espressi dei sentimenti positivi, negativi o neutri.

Tornando al concetto delle interfacce multimodali, però, oggi l’analisi delle emozioni passa anche attraverso la voce e le espressioni facciali, diventando sempre più precisa ed accurata.

Il post che segue descrive la semplicità con la quale è possibile mettere in azione degli algoritmi in grado di etichettare le emozioni espresse da una voce.

Il monitoraggio della salute attraverso l'analisi della voce

A questo proposito, consiglio di approfondire il VoiceWise, un progetto italiano che consente di fare delle diagnosi di patologie attraverso l’analisi della voce con una precisione elevatissima.

Nel video che segue, il Prof. Giovanni Saggio descrive l'utilizzo del sistema per la diagnosi di Covid, e viene mostrato un esempio di utilizzo dei cosiddetti "tamponi vocali".

In realtà è riduttivo parlare solo di Covid: la gamma di patologie individuabili, è molto ampia!

Come si evolvono le performance degli assistenti virtuali

Attraverso gli algoritmi di NLU, gli assistenti cercano di comprendere l’intento delle persone (degli utenti che usano la tecnologia).

Su quale base? Sulla base di un'attività di training su un determinato dominio, oppure di modelli molto ampi che sono stati addestrati usando terabyte di informazioni estrapolate dal web.

Quindi quando si costruisce un assistente virtuale, nella fase di design, si vanno a delineare i flussi conversazionali, ma anche a definire gli intenti che devono essere interpretati (fase di training iniziale). E prima di metterlo a disposizione del pubblico, si cerca di affinare il più possibile questa base conoscenza, in maniera automatizzata e/o attraverso l'utilizzo da parte di un gruppo ristretto di persone.

L’assistente, infine, raggiunge gli utenti finali, che inizieranno ad interagire su diversi touchpoint.

Ma l'attività di training continua, perché il ventaglio di potenziali espressioni è talmente vasto che quasi certamente non si sarà riusciti a prevedere tutte le richieste che le persone potrebbero fare.

Questo significa che, in alcuni casi, l’assistente non avrà una risposta da dare all'utente. Tale eventualità può essere gestita in diversi modi, ad esempio mettendo in comunicazione l’utente con un operatore umano che può risolvere il problema. Contestualmente, però, viene sollevato, come si dice in gergo tecnico, un “fallback” (una non risposta), che viene gestita con una sessione di training ad hoc, anche sfruttando i dati dalla risposta dell’operatore umano.

Cosa succede la volta successiva in cui l’assistente riceve una domanda riconducibile allo stesso intento? Stavolta l'utente ottiene una risposta o un flusso conversazionale da proporre all’utente.. e così via, finché il livello di training soddisferà tutto (o quasi) il ventaglio delle possibili richieste.

Ma in realtà questo ciclo non finisce mai, perché può esserci una stagionalità nelle domande, ma anche nuove promozioni, nuovi prodotti, ecc..

Possiamo associare la creazione dell’assistente alla fase di onboarding di un nuovo assunto in azienda.

Si tratta di un processo che si costruisce insieme al brand, e non può essere plug & play.

Vale per grandi e piccole aziende? Il processo, assolutamente sì. Ciò che cambia è la mole dei dati a disposizione, perché il numero delle interazioni sarà diverso in base alle dimensioni dell'azienda. Chiaramente, più dati abbiamo, gestiti in maniera corretta, e migliore sarà il training.

I sistemi di NLU moderni, tuttavia, utilizzano delle modalità ibride di riconoscimento degli intenti che usano sia il machine learning, sia l’analisi della sintassi.. e questo va proprio a facilitare la gestione di basi di conoscenza di piccole dimensioni.

Come si sta evolvendo la conversational AI

L’evoluzione di questi sistemi è davvero in piena accelerazione. Quello che sta impressionando in questo momento è la capacità di offrire risposte per quanto riguarda modelli linguistici che vengono definiti LLM (Large Language Models) come GPT-3 di OpenAI, LaMDA di Google, Gopher, Wav2Vec di Meta, ecc..

Questi modelli basano la loro conoscenza su un'enorme quantità di informazioni e parametri, e se cerchiamo online le diverse dimostrazioni si vede come riescano a dare risposte e a conversare senza avere un training su un dominio specifico.

Come fanno? Il principio è semplice: utilizzano delle sequenze di parole che hanno la più elevata probabilità (in base ai dati di training) di creare frasi (e risposte), sensate in un determinato contesto. Nel video si possono vedere alcuni test chattando con GPT-3.

Qual è il limite di questi modelli? Offrono delle risposte generiche e non hanno una memorizzazione del contesto. Inoltre, poiché vengono istruiti ed "allenati" utilizzando contenuti esistenti online, possono apprendere informazioni "tossiche" producendo testi che provocano disinformazione, ed intaccano la sensibilità di alcune persone (sessismo, razzismo, ecc.).

OpenAI sta lavorando su questa problematica, attraverso dei filtri in fase di training e con la possibilità di usare GPT-3 fornendo degli elementi aggiuntivi di contesto. Oltre a questo, ha appena presentato dei modelli denominati InstructGPT che sono 100 volte più leggeri, hanno meno probabilità di generare testo problematico, e si allineano in maniera più aderente con l'intento dell'utente.

Insomma, il livello è molto alto, e i prossimi passi vanno verso il miglioramento costante della comprensione delle espressioni delle persone e dalla qualità delle risposte.

Tutti questi concetti non si applicano solo nel rapporto tra brand e utente, ma anche nel supporto delle persone nello svolgimento del loro lavoro. Parlo di ciò che viene definita democratizzazione dei dati e della tecnologia: gli assistenti virtuali, grazie alla comprensione del linguaggio naturale e a sistemi di business intelligence, possono interpretare ed elaborare i dati supportando le persone, le quali possono concentrarsi maggiormente in ambiti più strategici.

Non solo.. gli assistenti aiuteranno gli sviluppatori a creare dei software sempre migliori; consiglio di guardare, ad esempio il progetto Codex di OpenAI.

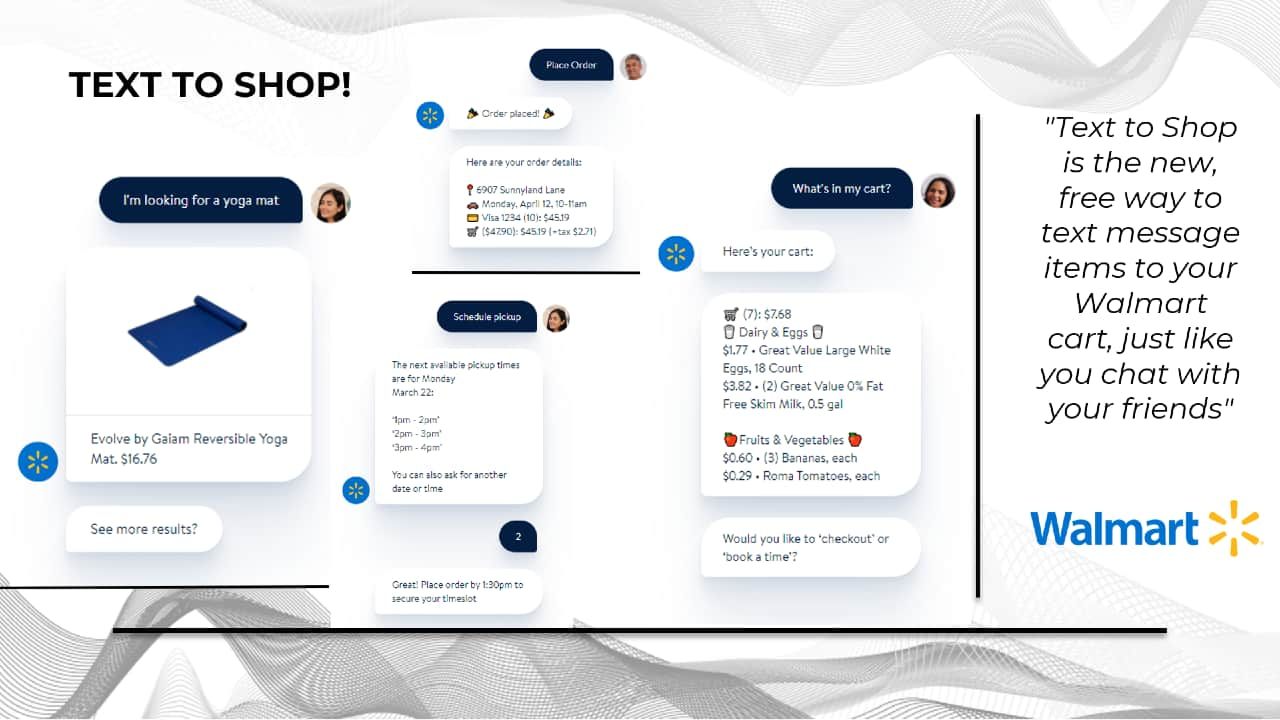

Per dire un’ultima parola sul futuro, direi "conversational commerce", ovvero sistemi che consentono non solo alle persone di cercare i prodotti come chattassero con un amico su WhatsApp, ma anche l’acquisto diretto.

Gli assistenti virtuali e la lingua dei segni

Ho usato diverse volte il termine multimodalità, perché credo che le interazioni del futuro avranno sempre più questo tipo di interfaccia.

Quindi immaginiamoci un totem in uno spazio fisico.. noi, ad esempio, in azienda abbiamo un’assistente virtuale in un totem che accoglie le persone, chiede con chi hanno appuntamento, e mentre lo attendono possono provare esperienze di intrattenimento.

L’interazione con questi dispositivi è multimodale: possiamo interagire attraverso la voce, attraverso il display con la possibilità di usare il touchscreen, ma in futuro ci sarà la possibilità di avere a disposizione la lingua dei segni, sia in input, sia in output.

Questa, secondo me, è una di quelle direzioni in cui la tecnologia, come dico spesso, è "al posto giusto", perché è volta al miglioramento della condizione delle persone e all’inclusività.

Per approfondire